На vmind закрывают вопрос бекапа ВМ с бесплатного ESXi - Создание резервных копий ВМ подручными средствами.

среда, 29 июля 2009 г.

Бекап виртуальных машин с ESXi

понедельник, 27 июля 2009 г.

VCP on vSphere

К вопросу о сдаче VCP 4:

есть мнение, что 8 августа появится возможность зарегистрироваться на сдачу теста, однако сама сдача возможна будет после 31 августа.

Так же, кто сдавал бета версию теста - есть мнение что результаты станут известны чуть ли не на следующей неделе.

VCP410 August 1st, August 8th or August 31th?

воскресенье, 26 июля 2009 г.

VCDX

Сделал страничку

Обратите внимание на тестовый экзамен к Enterprise Exam и демо лабораторных работ.

vCenter Server Heartbeat

Virtual Center - это проблема. Вернее, когда он есть - нет проблем, а вот если с ним что то случается - вот тут у нас начинаются менее счастливые времена.

Да, с одной стороны, на ВМ и ESX сервера падение vCenter влияния оказывает лишь опосредованно - они как работали, так и будут продолжать.

Но не будет происходить мониторинг, не будет работать DRS, VMotion, Storage VMotion. HA работает, но нельзя поменять настройки. Плагины к vCenter не работают.

В общем, не хорошо.

К счастью, сейчас у нас есть правильное решения для защиты vCenter - VMware лицензировало решение от Neverfail, и предлагает его в под именем vCenter Server Heartbeat.

Что эта штука делает:

В сети создаем сервер VC - резервный(с помощью конвертера клонируем оригинальный физический VC. Если первый VC уже ВМ - просто клонируем).

На второй VC непрерывно реплицируются настройки и данные с основного сервера vCenter. В случае смерти основного, резервный выпускается в сеть.

Переход от основного к резервному может происходить и автоматически - по недоступности основного сервера vCenter, так и вручную - пригодится для плановой остановки сервера, когда vCenter стоит на физическом железе.

Вот тут лежит видео и pdf с VMworld - Protecting your vCenter Server with Server Heartbeat.

Отдельно pdf.

Рекомендую глянуть.

Может защищать и Update manager, когда тот стоит на одном сервере с vCenter.

В перспективе, может защищать и Lab, Stage, Lifecycle, Site Recovery менеджеры.

Плохие новости:

работает только если в качестве БД vCenter используется SQL, не Oracle.

Стоит много денег - порядка 10 000 $ на один vCenter.

VMDirectPath I\O

Интересный видеоролик:

Вот тут в хорошем качестве.

демонстрирует VMDirectPath IO на железе Cisco UCS.

Напомню, что эта фича позволяет прокидывать контроллеры ввода вывода(сеть и схд) внутрь ВМ. Эту функцию должно поддерживать железо - а функция достаточно новая, и мне самому с ней поработать пока не пришлось.

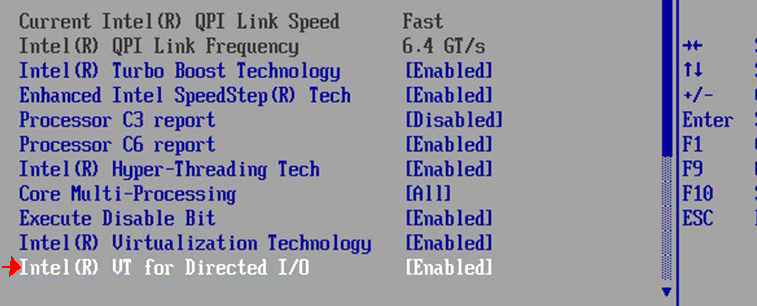

В видеоролике можно увидеть, что в биосе сервера эта опция включатся выключается отдельной настройкой.

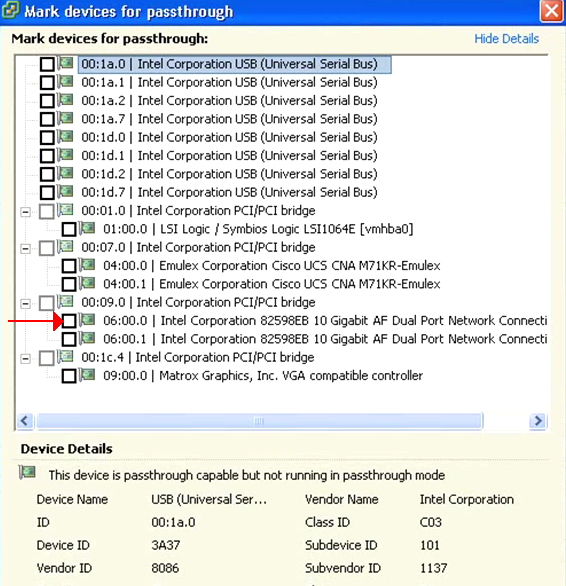

Потом показывается, что надо настроить с точки зрения ESX - очень интересное окно настроек:

Возможно, в перспективе можно будет прокидывать произвольные PCI устройства?

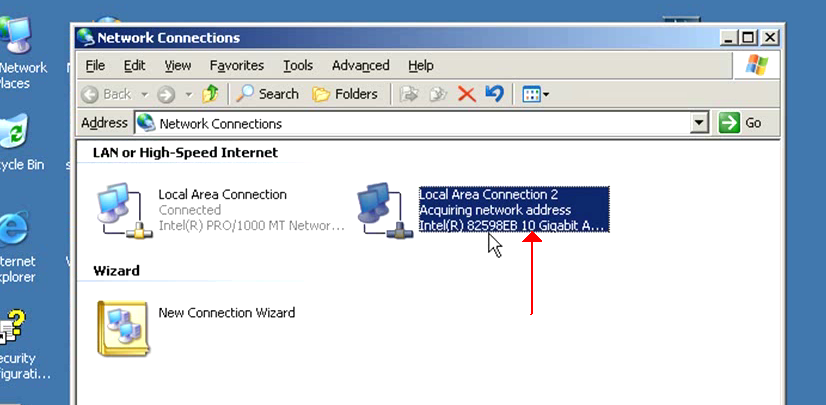

Взяли двухпортовую 10 ГБ сетевушку, настроили возможность ее прокидывания в ВМ. Для применения настройки потребовалась перезагрузка, виртуальные коммутаторы эту сетевушку теперь использовать не смогут. Более того, ESX ее вообще видеть перестает во всех местах, кроме настройки VMDirect Path I/O.

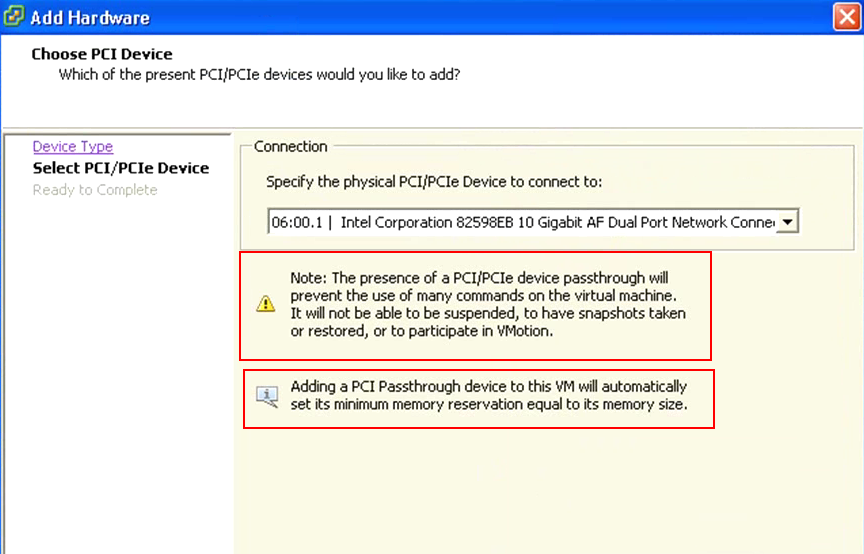

Потом запускаем мастер добавления железа в ВМ, выбираем PCI Device, а там нашу сетевушку.

Когда к ВМ подключено такое устройство, с ней многое становится делать нельзя.

Reservation оперативки такой ВМ должен быть равным объему ее памяти - тоже важный нюанс.

Драйвер от железки должен быть установлен в гостевую ОС.

VMware - EMC vs NetApp

Преза по сравнению СХД EMC и NetApp под ESX:

Я в этом мало что понимаю, поэтому сказать в чем подвох не могу :-)

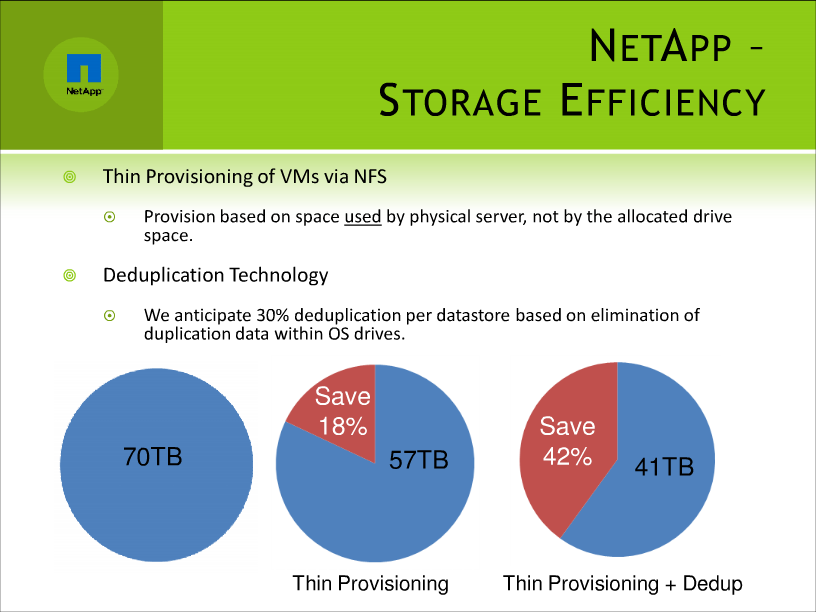

Но для ознакомления может быть мнтересно. Например, данные по эффективности Thin Provisioning и дедупликации:

EMC Storage Viewer + vSphere

Интересные видео - про интеграцию управления СХД EMC в интерфейс vCenter.

Идея в чем:

в vCenter ставится плагин, который знает EMC storage API (Symmetrix and CLARiiON) и VI API - и в интерфейсе vCenter показывает подробную информацию о datastore, storage object, virtual disk, and target-level configuration detail.

Фишка в чем: благодаря такой интеграции, админ вСферы и админ стораджа могут разговаривать на одном языке. Администрирование стыка инфраструктур хранения и виртуализации сильно упрощается.

Немножко подробностей тут:

State of the art – integrating storage and VMware – Part I.

State of the art – integrating storage and VMware – Part II.

А вот тут уже писали, как это все дело устанавливается - Установка EMC Storage Viewer для vSphere.

Linux + Hyper-V

На неделе многие активно обсуждали "что Майкрософт выпустит для Linux(!) integration component под лицензией GPL(!!)".

Правда, активно муссолили тему лищь фанаты Linux и ненавистники Майкрософт.

Всем остальным, если до этого и было дело, то с профессиональной т.зрения.

С профессиональной т.зрения, есть мнение, что с этими компонентами, для улучшени использования Linux в ВМ под Hyper-V, пока что не все до конца хорошо - Even GPL can’t make Hyper-V Linux VMs well.

суббота, 25 июля 2009 г.

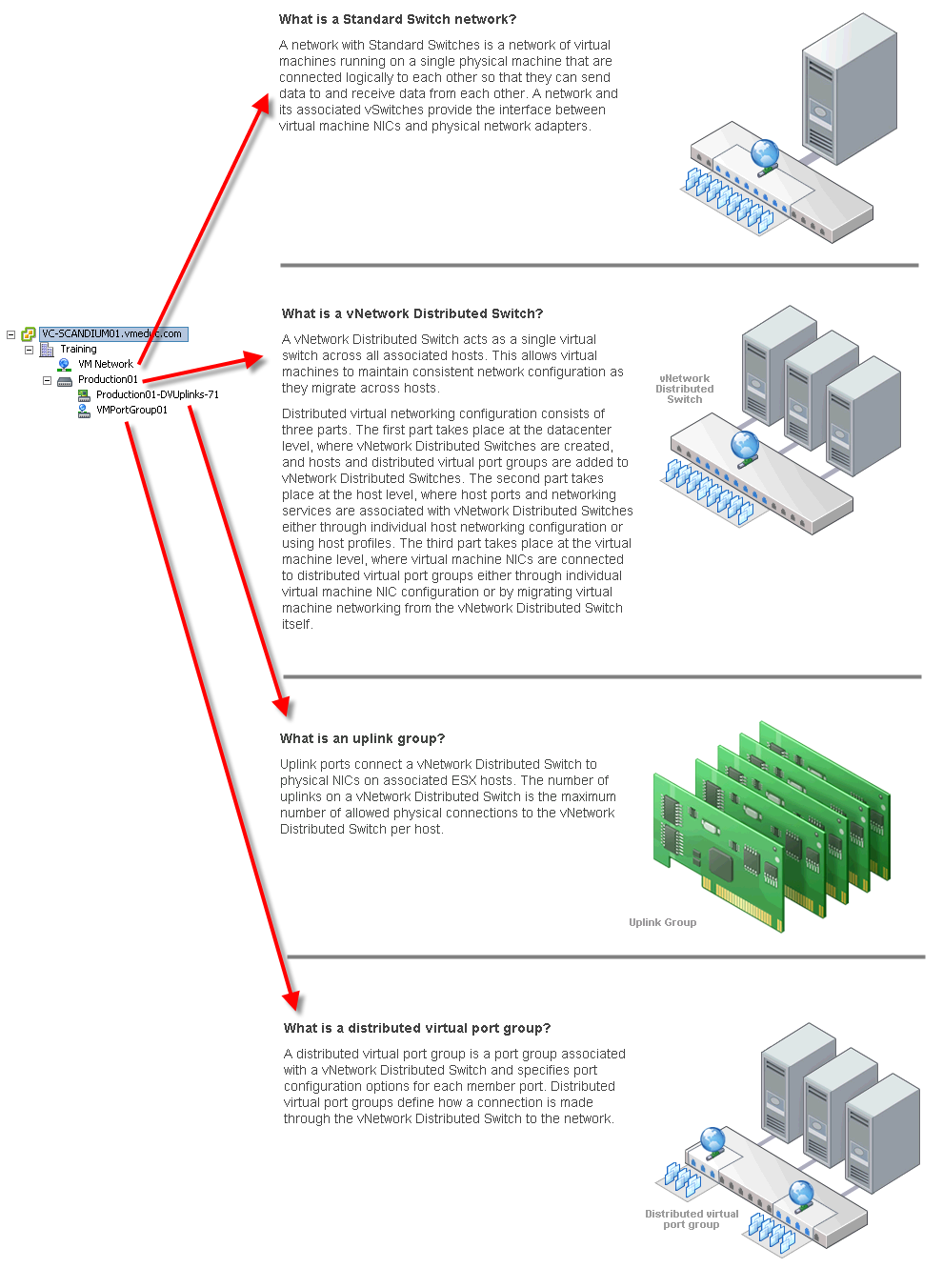

Некоторые подробности про dvSwitch

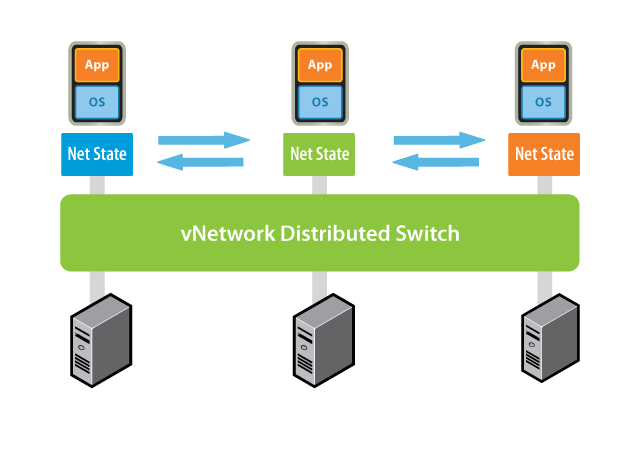

Коллеги, одно из новшеств четвертой версии виртуальной инфраструктуры от VMware - это распределенные виртуальные коммутаторы, dvSwitch.

Что они и зачем они на организационном уровне, думаю, понятно -

Но вот что и как с ними на техническом уровне - это вопрос пока что во многом открытый.

Например, недавно мне подсказали следующую особенность распределенных вКоммутаторов VMware:

если создать коммутатор на несколько хостов, а потом один из хостов убить(не выводя корректно из vCenter и этого dvSwitch), то те порты dvSwitch, что были заняты аплинками с умершего хоста, переводятся в заблокированное состояние. На сутки. И удалить этот распределенный dvSwitch все это время нельзя. (Changing the default timeout for locked dvPorts)

Да, проблема не слишком тяжелая уже потому, что такая последовательность действий достаточно редка. Однако, из доступности вот таких вот нюансов и складывается эффективность использования тех или иных средств и функций.

Это я к чему: потихонечку начинает появляться информация про эти распределенные коммутаторы.

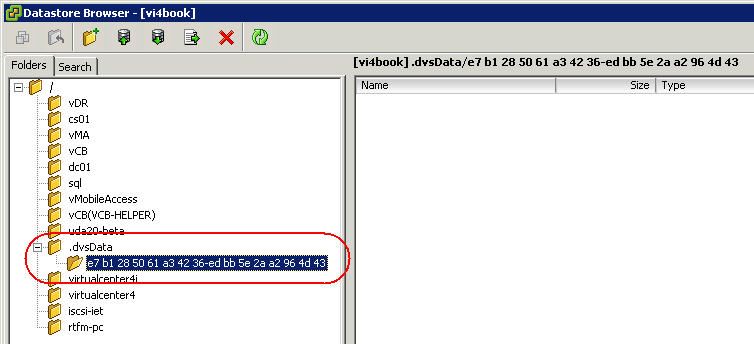

Вот тут - What I learned yesterday: DvSData Folder,View all IPs, Sysprep & Guest Customization - говорят следующее:

При добавлении хоста в распр. вирт. коммутатор, на одном из vmfs разделов хоста появляется папочка типа такой:

что то в ней лежит.

так же, можно воспользоваться командой

./usr/lib/vmware/bin/net-dvs

для вывода инфы о dvSwitch на этом хосте.

и эта инфа еще лежит тут

/etc/vmware/dvsdata.db

Вроде как, это бекап конфига распределенного вКоммутатора, посмотреть который можно командой net-dvs с ключиком -l.

Так же, эту инфу как то можно посмотреть командой vm-support.

Пока все.

Хорошая картинка:

performance troubleshooting example

Весьма интересное описание опыта траблшутинга производительности ESX - How Heavy is your ESX Load?

хост с 44 ВМ, сначала оказалось что SC очень сильно свопит(решили увеличением ей памяти до максимума, выделением большого свопа и ребутом хоста), затем для большинства ВМ изменили конфиг с 2vCPU на 1vCPU. Это очень вкратце, так что лучше смотреть оригинал.

четверг, 23 июля 2009 г.

Security

Коллеги, особенно те из вас, кого всерьез волнуют проблемы безопасности виртуальной инфраструктуры:

Организуем неформальное сообщество VMware Security Group Russia для обмена информацией и опытом.

Точкой отсчета можно считать доклад Марии Сидоровой на vmug, и создание вот этой группы на linkedin - VMware Security Group Russia.

Кроме того, на страничке wiki.vm4.ru\security даются ссылки на тематические документы.

Например сегодня добавились еще две:

документ по секьюрной настройке распределенного виртуального коммутатора от Cisco,

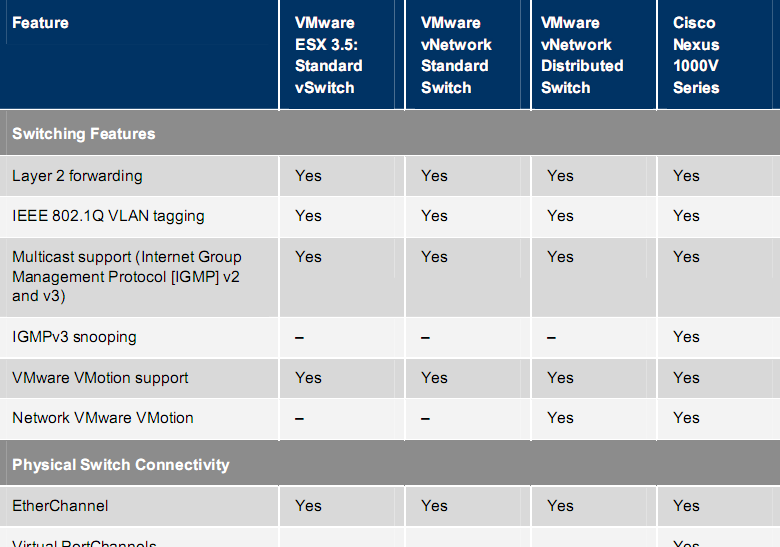

и документ с, в частности, со сравнением коммутаторов, используемых для построения виртуальной инфраструктуры

.

VMsafe + Trend Micro

Мне тут подсказывают про интересный анонс -

Trend Micro выпустила новое решение для защиты виртуальных машин VMware

Компания Trend Micro выпустила новое решение для защиты сред VMware ESX/ESXi под названием Trend Micro Core Protection for Virtual Machines.

Новинка предназначена для всесторонней защиты виртуальных машин VMware как в рабочем режиме, так и в режиме ожидания. Благодаря интерфейсам VMsafe API от VMware этот продукт обеспечивает многоуровневую защиту при помощи специальных сканирующих виртуальных машин, работа которых координируется посредством агентов в реальном времени, говорится в сообщении Tr… полный текст

Источник: CNews

.Вот оно, первое из известных мне решений на VMsafe.

thx Мария Сидорова.

воскресенье, 19 июля 2009 г.

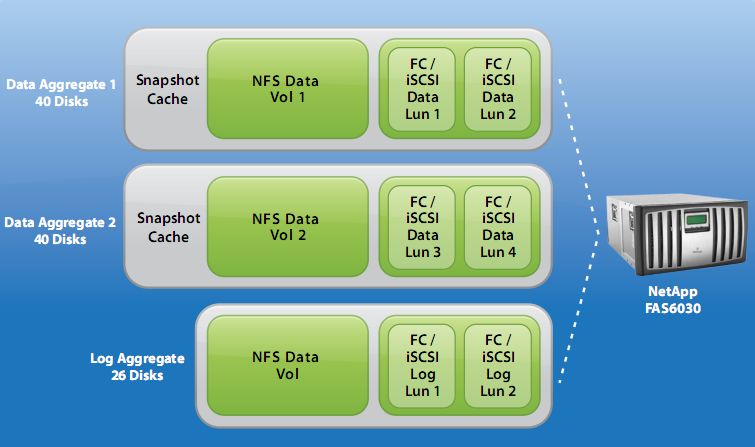

storage protocol comparsion

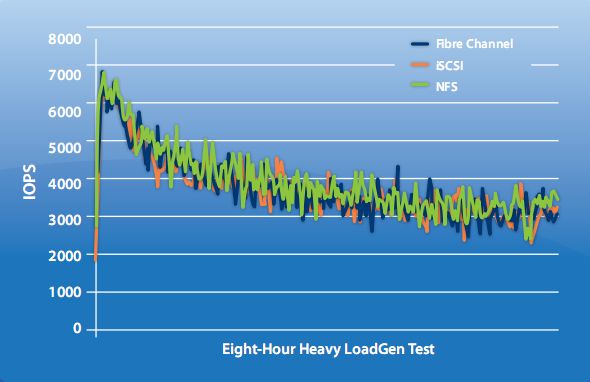

Очень, очень и очень, имхо, интересная дока - VMware vSphere 4: Exchange Server on NFS, iSCSI, and Fibre Channel.

Взяли сторадж NetApp FAS6030.

Настроили ЛУНов, настроили их отдачу по FC или iSCSI, настроили ЛУНы с отдачей по NFS.

Создали 8 ВМ с Exchange 2007 - каждая для обслуживания 2000 клиентов.

Win2003 EE, 14 ГБ ОЗУ, 2vCPU.

Для имитации нагрузки использовался LoadGen.

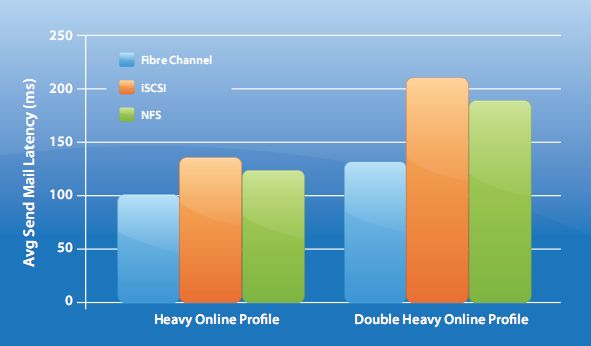

Самое интересное:

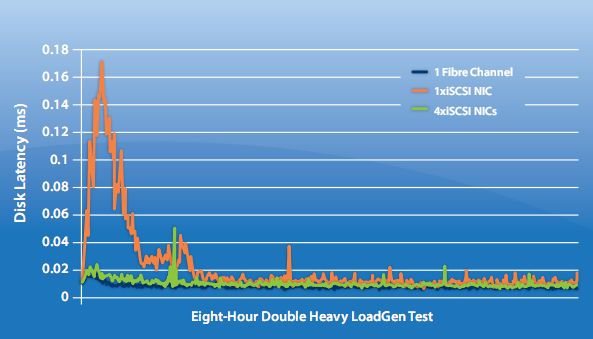

Как видно, iSCSI обещает самые большие задержки. Однако, посмотрите на отличия в задержках iSCSI с одним NIC и с четырьмя:

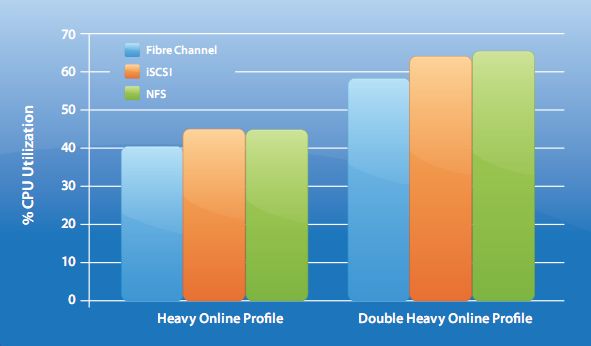

Загрузка процессоров сервера отличается незначительно:

Performance Best Practices

Дока Performance Best Practices for VMware vSphere 4.0.

Если вас интересует вопрос - как добиться максимальной производительности под ESX 4, то эти 54 страницы первое, что стоит прочесть.

суббота, 18 июля 2009 г.

Advanced Technical Design Guide

Вот тут - VMware Infrastructure 3: Advanced Technical Design Guide Downloads - можно скачать готовые главы из книги VMware Infrastructure 3: Advanced Technical Design Guide.

За ссылку thx Марат Лесных.

командная строка

Вот тут - Know Your History - можно овладеть несколькими полезными навыками обращения с шеллом SC.

В частности, комбинация Ctrl-r запустит интеллектуальный поиск по истории команд.

Два интересных списка

Два интересных списка:

У VMware есть продукт Update Manager - умеющий патчить ESX(i), гостевые ОС и приложения в гостевых ОС. Это прикольно. Это может стать поводом использовать для управления обновлениями и Windows именно VUM, нежели какой то другой продукт, типа WSUS.

Однако, было бы здорово понять, а какие продукты может патчить VUM. Помочь в этом может список вот отсюда - http://xml.shavlik.com/data/supportedproducts60.htm.

А вот тут - http://kb.vmware.com/selfservice/google/searchpage.jsp - доступен индекс KB VMware. Может быть удобно зайти на эту страницу, нажать Ctrl+F и исать по 5000+ названиям статей.

vSphere licensing

Подборка статей в KB про лицензирование и администрирование лицензий vSphere:

KB ID | Title |

| Adding or modifying secondary license administrators or support administrators on a contract | |

| Distinction between License Administrator (LA) and Support Administrator (SA) | |

| vSphere 4.0 upgrade options | |

| Registering a License Key | |

| Downgrading vSphere 4.0 License to ESX 3.5 version | |

| Troubleshooting Missing or Incorrect Licenses on the Portal | |

| Licensing ESX 4.0, ESXi 4.0, and vCenter 4.0 | |

| Ensuring validity of Subscription Contracts to receive product upgrades | |

| Uploading the License file to the License Server | |

| Locating VMware Serial Number online |

VCP on vSphere 4 - http://vsphere.vm4.ru/vcp4

К вопросу о сдаче теста на VCP - решил завести отдельную страничку.

http://vm.pro-it.kz/

Сегодня узнал еще об одном русскоязычном блоге на нашу любимую тему - http://vm.pro-it.kz/.

Решение для малого бизнеса с деньгами

Русскоязычных ресурсов по виртуализации не так много, и, думаю, все читают все.

Мой список тут - http://wiki.vm4.ru/info.

Если я ошибаюсь, то моим читателям может быть интересен пост на vmind - Решение для малого бизнеса с деньгами.

Интерфейсы XenServer и vCenter

Интересный пост мне тут подсказали - Cross Training to Citrix XenServer.

Суть в сравнении интерфейсов продуктов VMware vCenter и Citrix XenServer.

Есть, конечно, и отличия - но похожего много.

Это, с одной стороны, не удивительно - делают то продукты одну и ту же работу.

С другой стороны, про тот же Hyper-V я не раз слышал отзывы про неудобство настройки инфраструктуры из разных консолей - что то делается из консоли Hyper-V, что то из консоли управления кластеризацией..

среда, 15 июля 2009 г.

практический опыт

Из переписки:

Добрый день Михаил!...

Извините за беспокойство, очень нужен совет. Ситуация следующая: два сервака HP 380 G4 объединены в кластер DRS. На каждом хосте имеются ресурсы: 2CPUx3.6 Ghz with Hypertraiding , 8 Gb Memory. Каждый из этих хостов соединен двумя оптическими картами к хранилищу Clariion CX-400. Лун, на котором хранятся файлы ВМ имеет размер 500 Gb. Карточки Emulex. ВМ в основном 2-х процессорные с 2000 Gb памяти. При работе ВМ получаем проблему: при запуске обычного копирования любым способом (Far, Total Commander, Explorer) процессор на ВМ уходит в нагрузку 100%, ядро процессора грузится на 70-80 %. ВМ просто «умирает». При этом хосты ESX не испытывают особой нагрузки. Пробовал поиграться с оптическими картами – не помогло. Откатил дрова, которые установили Tools, менял тип адаптера с LSI на BUS Logic в настройках ВМ, тоже никакого результата. Можете что-нибудь подсказать?

Проблему частично удалось решить, применив пару ваших советов и благодаря блогам vmgu.ru; vm4ru....

В двух словах – для всех юзеров , решивших посвятить свою жизнь виртуализации, «читайте мануалы внимательно! Shares, Transparend Page Sharing, DRS это не просто красивые слова. Понимание принципа работы этих механизмов упростит вашу жизнь и жизнь ваших виртуальных питомцев».

Итак, была проблема высокой загрузки вЦПУ ВМ при копировании с FTP или просто по сети.

Изначально при построении кластера и запуске ВМ я не особо настраивал распределение ресурсов в кластере, за что потом и поплатился. Т.е. ВМ работали, кто хорошо, кто плохо. Почитав и поняв свои ошибки я проделал следующие действия:

1. Распределил все ВМ по приоритету задач, т.е одна группа ВМ работает с высокой дисковой активностью, а вторая группа ВМ выполняет какие-то приложения, в основном это WEB приложения.

2. Для первой группы ВМ прописал в файлах параметр mainMem.useNamedFile = "FALSE", отключать Transparend Page Sharing не стал, хосты на данный механизм не сильно много и тратят своих ресурсов. Создал для этой группы ВМ Port Group на vSwitch, где в настройках Traffic Shapping понизил значения Average Bandwidth и Peak Bandwidth до 4000 kb/s. Это реально понизило нагрузку на вЦПУ, хотя ВМ работать стала медленнее по сети, но этим в моей ситуации можно и пожертвовать. Также в настройках ВМ в меню Resourses – Disk – Shares – High. В настройках кластера Resourse Allocation для этих ВМ выставил Shares – High, повысил значение Reservation и Limit. После этого ВМ работают отлично, хотя и хосты прилично напрягаются.

3. Для второй группы ВМ ничего особенного не делал. Просто распределил оставшиеся ресурсы. Приложение, которые на них крутятся не особо и нагружают вЦП, а соответственно и хост.

После решения этой проблемы произошло обновление до Update 4.

Затем дали поиграться железяку HP DL 380 G5 с 6 SAS дисками. И приключилась проблема, точнее несколько. На дисках я собрал 5 RAID, общая емкость получилась 350 Gb. VMFS-раздел – 330 Gb. Скорость копирования в пределах VMFS, и на него – 2 MB/s. Это был удар ниже пояса. Я не мог смигрировать ВМ с большими vmdk. Миграция отваливалась по тайм ауту (длилась 1 час, а потом ошибка). Причем копирование из каталога Home в каталог User показывало скорость 20 MB/s. Я подумал, что нужно увеличить размер блока при форматировании в vmfs. В конфигурации Storage я выбираю Remove, затем произвел Rescan All Vmhba, затем Add Disk/Lun и не вижу ничего. Немного поигравшись, выполнил следующее:

Fdisk -l , и увидел пустоту в несколько тысяч цилиндров. Умножив количество цилиндров на емкость получив цифру в 350 Gb.

Fdisk /dev/cciss/c0d0

Command (m for help): n

Далее указал первый цилиндр, затем последний.

Далее W.

После этого при помощи ключа t в команде fdisk меняю ID файловой системы на fb. Провожу rescan hba и получаю свое хранилище обратно, даже файлы сохранились. Но проблема не ушла. Еще раз проделав все выше описанное, но уже без ключа t, применив команду vmkfstools отформатировал хранилище блоками по 2 Mb. Но и эти телодвижения не помогли. Затем железяку забрали. Проблема осталась открытой. (Конечно нужно было все заснепшотить для правильности изложения, но не подумал, пишу по памяти).

Сейчас дают два лезвия на IBM Blade Center H. Буду строить кластер HA с общим Storage на iSCSI. Затем нужно сделать NLB кластер ВМ. Не знаю, уживутся ли NLB кластер и VMotion. Очень много статей по этому поводу, так что буду наступать на свои грабли.

thx Vitaly Shindler

Примеры вопросов VCP 410

Как я упоминал, сдавал на днях бета версию теста VCP 4.

Несколько примеров. Вопросы разные. Само собой, про многие новые фичи - FT, vApp, dvSw. Есть вопросы про View и Lab Manager. Немножко на базовые команды командной строки - типа как посмотреть настройки файрвола, как посмотреть настройки vSw.

Все вопросы - вопросы, с указанием кол-ва ответов. Небольшая часть требует ознакомления со скриншотом настройки или данных мониторинга.

Есть вопросы на знание конкретных вещей.

- Дефолтный порт для iSCSI.

- Какая из следующих фич не входит в лицензию vSphere Advanced.

- Дефолтный размер раздела swap.

- У вас 10 000 ВМ в двух ЦОДах - примерно по 5000 в каждом. Какое минимальное количество vCenter в linked режиме, и dvSwitch надо в этом случае.

- Сколько задач бекапа может делать VMware Data Recovery одновременно.

- Какой из разделов надо увеличить, если хотите поставить памятеёмкий софт в Service Console.

- Для каких задач оправдано применение Fault Tolerance.

- Преимущества pRDM над vRDM.

- Что из перечисленного является преимуществом ESXi над ESX.

- Почему стоит выбрать ESXi а не VMware Server 2.

- У вас есть образы \ ВМ в форматах Norton Ghost 9, Acronis True Image, MS Virtual PC, Fusion. Что из этого заведется под VMware Player.

- Что можно настраивать с помощью host profiles.

- Админ делает compliance для HA\DRS кластера. Что из перечисленного произойдет, если никакого host profiles не назначено на этот кластер.

- Вы создаете группу портов на dvSwitch. Какое дефолтное значение настройки port binding.

- Что можно настроить с закладки Resource allocation для DRS кластера.

Дурацкие:

- Вы конфигурите Oracle Connection для vCenter. Что из перечисленного надо сделать. Перечисленны всякие коварные скрипты и загадочные аббревиатуры.

- Как называются пулы ресурсов одного уровня (в ответах Child, Parent и еще какие то английские слова)

- Какие из следующих настроек недоступны, если выключены "Applaince Options" (для vApp).

Как то так

.

вторник, 14 июля 2009 г.

по итогам встречи сообщества VMware

Вот тут - http://vsphere.vm4.ru/vmug/2009-1 - (или вот тут в альтернативном варианте оформления) лежат доклады с VMUG 2009, в моем изложении. Это означает - бледное подобие оригиналов :( , но, думаю, это лучше чем ничего.

воскресенье, 12 июля 2009 г.

Host currently has no management network redundancy

Host

Если вас раздражает это предупреждение, см статью в KB - Network redundancy message when configuring VMware High Availability in VirtualCenter 2.5.

Напомню, что про прочие коварные настройки HA кластера можно прочесть тут.

thx Дмитрию Кузнецову.

пятница, 10 июля 2009 г.

vcp 4 beta exam

Сегодня сдавал бета версию теста на VCP 4.

Я как то не ожидал на что подписываюсь - 270 вопросов за 285 минут %)

А да, и за это платить должен я - 175$. Хорошо хоть как бета тестеру дали скидку в 120.

Результаты обещают недель через 6. Примеры вопросов планирую привести через несколько дней.

пятница, 3 июля 2009 г.

Теория виртуализации

Для интересующихся теорией виртуализации (и читающих на английском) интересной может оказаться информационная дока от VMware - Software and Hardware Techniques for x86 Virtualization.

VMware HA troubleshooting

Запись в kb VMware - что делать, если кластер HA не собирается - Troubleshooting Adding an ESX Server Host to a VMware High Availability Cluster.

VMotion, CPU mask, EVC

VMotion. Очень хорошая штука. Из условий самое неприятное - требование совместимости процессоров хостов.

Если этой совместимости нет, а живой миграции хочется, что можно сделать:

Статья из kb VMware про все способы разрешить vMotion между хостами с разными процессорами - VMotion CPU Compatibility - Migrations Prevented Due to CPU Mismatch - How to Override Masks.

Статья в kb VMware про EVC - Enhanced VMotion Compatibility (EVC) processor support. В частности, там приводятся группы совместимости ЦП с т.зрения EVC.

Microsoft Support Check wizard

У Microsoft есть программа валидации сторонних гипервизоров - SVVP. На соответствующем сайте можно посмотреть, какие конфигурации железа и софта будут поддерживаться со стороны Microsoft. Напомню, про интересные дискуссии о поддержку MS своего софта на не своей виртуализации можно глянуть тут.

Углядел на этом сайте мастер - Support Policy Wizard.

среда, 1 июля 2009 г.

ESXi Troubleshooting

Некоторые хинты траблшутинга ESXi:

Если локально нажать .. то увидим .. .

ALT+F1 - консоль(та, что неактивна по умолчанию).

ALT+F2 - дефолтное меню.

ALT+F11 - сводная инфа - версия, модель сервера, CPU, память.

ALT+F12 - vmkernel.log.

Консоль, доступ к которой можно получить, набрав unsupported в ALT+F1 - не поддерживаемая, как и все манипуляции в ней. В логах оседает сам факт входа в эту консоль, но не все выполняемые в ней команды. Если хочется отключить саму возможность в нее заходить, то:

Идем в Configuration -> Advanced Settings-> "VMkernel" -> снять галочку VMkernel.Boot.techSupportMode.

Потом рестарт.

Места на партиции с ESXi мало, поэтому логи перезатираются быстро. Вот тут

Configuration -> Advanced Settings -> Syslog -> Remote.

Тут можно указать имя\IP сервера для удаленного сбора логов.

Локальные лежат в /var/log/ и /var/log/vmware

Configuration -> Advanced Settings -> Syslog -> Local -> [datastore]\folder

Так же, можно настроить запись логов на какое то из хранилищ:

Если посмотреть на разделы диска(флешки) где установлен ESXi, то первыми будут два одинаковых раздела с одинаковым содержимым. Это - основной и резервный "bank" с ESXi. Если, например, обновление прошло неудачно, и ESXi не загружается с основного раздела, то можно загрузить его с раздела резервного, куда обновление не ставилось.

Перезагрузите ESXi. Когда увидите Loading VMware Hypervisor…, нажмите Shift + R для загрузки с резервной партиции.

Команда RCLI

vicfg-cfgbackup --server <3i-host-ip> --portnumber--

protocol--username root --password -s

забекапит настройки ESXi.

Команда RCLI

– vicfg-cfgbackup --server <3i-host-ip> --portnumber--

protocol--username root --password -l

восстановит настройки. (скорее всего, не заработает с ESXi с бесплатной лицензией).

VMware ESXi Troubleshooting.

Reducing FT logging traffic for disk read intensive workloads

Интересная статься в kb про FT - Reducing FT logging traffic for disk read intensive workloads.

Из нее узнаем, что

When FT is enabled, all the inputs to the virtual machine are recorded and sent to the secondary host over the NIC designated for Fault Tolerance logging.

The inputs to the virtual machine include incoming network traffic as well as disk reads. If the virtual machine is doing throughput intensive disk reads (like sequential I/O), a lot of logging traffic needs to be sent to the secondary.

For example, a virtual machine doing disk reads at a 80Mb/sec generates at least 80 x 8 = 640Mb/sec of logging traffic.

Т.е. выделенной гигабитной карточки под траффик FT может и не хватать.

Но если действительно у нас есть ВМ, для которой FT генерирует столько трафика, можем кое что прикрутить:

в vmx файл этой ВМ добавить

replay.logReadData = checksum

Тогда данные будут сразу писаться на диск, без пересылки по сети.

Вариант по умолчанию дает большую производительность, поэтому этот хинт стоит использовать лишь при затыке в сети FT.