Решил написать сейчас, а то после НГ точно забуду.

Не редко создаем ВМ с именем "111" или "New" или "Temp", а она потом выводится в продакшен ! Переименование ВМ в VC это пол дела, а вот как переименовать все файлы с ней связанные, чтобы потом глядя на DataStore не вспоминать мучительно что же это за каталог такой ?

Многое пытались сделать, и удаление ВМ кроме дисков, и пересоздание каталогов для ВМ.....

Но случайно получилось следующее:

переименовываем ВМ в VC, а затем через svmotion переносим на другую DataStore. Вот в этот момент создается каталог уже с новым именем, и файлы туда копируются (а не перемещаются) с именами новой ВМ, и конфиги правятся. Вообщем, второе рождение с новым именем.

вторник, 30 декабря 2008 г.

Переименование ВМ

НГ

Драйвера в ESXi

Насколько я понимаю, есть вероятность возможности добавить драйверов в ESXi.

Есть ссылки на

- 3Ware 9650SE SATA controller

- 3Ware 9650SE/9690SA controllers

- LSI MegaRAID SATA 300-8X controller

- Intel ICH10 controller

- Intel ICH8 controller

Кому интересно, смотрите - Customizing your ESXi install with oem.tgz.

Настройка ротации лог файлов

На ESX и vCenter лог файлы имеют по умолчанию следующие настройки:

кол-во файлов - 10

максимальный размер - 5 МБ

Кроме того, для некоторых служб ротация происходит не только по достижению максимального размера, но и при старте\рестарте службы.

Это может привести к тому, что инфа из логов будет быстро пропадать из за ротации.

Так вот, попалась тут мне статья на эту тему в KB - Changing the size and number of logs for hostd, vpxa and vpxd.

понедельник, 29 декабря 2008 г.

RCLI

Ну и еще разок за сегодня про автоматизацию рутины.

Вот, к примеру,

хотим мы добавить еще одну группу портов на вКоммутатор, и задать ей VLAN ID. Легко - через VIC делается большинство настроек.

А на 20 ESX серверах сразу?

Лениво.

Можно сделать так:

Взять Remote CLI. И с помощью команд vicfg-(esxcfg-) централизованно выполнять манипуляции с хостами ESX 3.5 \ ESXi 3.5.

Примеры тут - Using RCLI to configure multiple ESX 3.5 Servers.

применение API к ESX для автоматизации действий с ВМ

Автоматизация рутинных действий с ВМ:

У VMware существует штука под названием VIX API.

В прикладном смысле это небольшой дистрибутив, после установки которого у нас появляется программа vmrun ( на Windows она лежит в %PROGRAMFILES%\VMware\VMware VIX, на Linux тоже где то лежит).

И с ней мы можем например такое делать:

- Вместо открытия VI клиента,

- открытия консоли к ВМ,

- авторизации,

- запуска cmd и выполнения(к примеру)

route add -p 192.168.100.0 mask 255.255.255.0 192.168.15.1 1

мы можем сделать так:

- Открыть cmd и сделать

vmrun -T esx -h https://esx/sdk -u cody.bunch -p password -gu guest.user -gp guest.password runProgramInGuest "[datastore] vm/vmx.vmx" c:\windows\system32\route.exe add -p 192.168.100.0 mask 255.255.255.0 192.168.15.1

с тем же эффектом.

Еще один пример:

Копирование файла MSI с рабочего стола внутрь ВМ:

vmrun -T esx -h https://esx.example.com/sdk -u root -p secretpw -gu user -gp userpw copyFileFromHostToGuest "[storage1] Windows/Windows.vmx" "c:\program files\my agent software\agent.msi" c:\agent.msi

Еще примеры и список доступных действий тут - Managing VM guests using vmrun.

Произвольная(нужная именно тебе) инфа в клиенте VI

Вполне вероятно, что поработав с VI какое то время, вы начнете ощущать потребность в легком доступе к информации, которая не на виду в VIC.

Помочь с этим могут посты:

Add Snapshot Information to the VI Client using Powershell.

Тут дается пример, как с можно углядеть кол-во снапшотов ВМ на закладке VIC.

Выглядеть это будет так:

Add Custom Fields to VI Client with Powershell (Samples).

А тут даются готовые решения для вывода информации о

- Snapshot Count

- Total Snapshot Size

- Host Hardware Model

- Host ESX Version

- Host LUN Count

Add RDM Size info to VI Client using Powershell - название говорит само за себя.

ESX Deployment Appliance - устновка ESX \ ESXi с PXE загрузкой сервера

Если вас интересует установка ESX\ESXi по сети, то имеет смысл присмотреться к виртуальному решению ESX Deployment Appliance(на страничке ссылка и на гайд по нему есть).

Сегодня актуальна версия 0.85, которая научилась

* ESXi support (it works, just not unattended yet. hints appreciated!)

* New scriptbuilder interface. Makes building scripts even easier and more accessible

* Scriptpart editor. rudimentary but working nicely ;)

А в следующей обещают еще и

* Boot from SAN support

* Editing the order of the scriptparts

* Hopefully, unattended ESXi installations

Чуток подробностей тут - ESX Deployment Appliance.

Как это все выглядит:

что произошло в 2008

Скопипащу интересный пост - The year that was - 2008 review of VMware world.

Окинув взглядом путевые точки, можно попытаться углядеть куда идем..

Jan

* Acquisition of Thinstall

* Stage Manager released

* Virtual Desktop Manager 2.0 released

* Microsoft acquires Calista

* Quest acquires Vizioncore

Feb

* VMworld Europe

* VMsafe announced

March

* Lifecycle Manager released

April

* Update 1 released

May

* Site Recovery Manager released

* Stage Manager released

* Management and Automation bundles (M&A) released

* Acquisition of B-hive

* First Communities Round Table Podcast

June

* Virtual Desktop Manager 2.1 released

July

* ThinApp 4.0 released

* Diane Greene is out and Paul Maritz is in

* VMware Infrastructure Toolkit released

* Free version of ESXi released

* Citrix XenDesktop released

* Update 2 released

August

* Lab Manager 3 released

* Update 2 time bomb failure and re-release of Update 2

* Microsoft announces support for 31 applications running under a Server Virtualization Validation Program (SVVP) listed hypervisor.

September

* Mendel Rosenblum leaves

* ESX qualifies as first hypervisor for Microsoft Server Virtualization Validation Program (SVVP)

* VMworld

* VMware announces VDC-OS, vCloud and View

* Fusion 2.0 released

* Teradici partnership

* Cisco and VMware announce the Cisco Nexus 1000V & VN-Link

* Workstation 6.5 released

* Server 2.0 released

October

* Microsoft Hyper-V Server released

November

* VMware acquires Tungsten Graphics

* Update 3 released

December

* VMware renames most components of the product line

* View Manager 3 released

* Site Recovery Manager Update 1 released

загрузить ВМ с USB устройства

С мест сообщают:

если есть необходимость загрузить ВМ с USB устройства - то это может быть проблемой.

В VMware Workstation \Server к ВМ можно добавить контроллер USB и цеплять устройства, подключенные к хосту.

Но их нельзя сделать загрузочными(я сам проверял для Workstation - действительно, в БИОСе нет соответствующей возможности. Для VMware Server 2.0 не проверял).

Ну так вот - есть информация как это сделать под QEMU - USB flash drive boot test on VM.

thx DimiG.

Подборка ресурсов про Site Recovery Manager

Подборка ссылок про SRM - VMware Site Recovery Manager - links, lessons, and labs.

И пара видео:

VMware Site Recovery Manager Overview

VMware SRM Installation

четверг, 25 декабря 2008 г.

некоторые аспекты работы HA

Предположим, есть у нас пара шасси с блейдами. Штук по 6 в каждом.

На них, само собой, установлены ESX.

ESX включены в состав кластера HA.

И тут мы умудряемся уронить все лезвия в одном шасси - к примеру, в следствии кривой прошивки комутаторов все шасси оказывается полностью отрезанным от сети. Неприятно, но у нас же есть HA.

Опа. А оказывается, и нет - если среди упавших серверов оказались все 5, агенты HA на которых были назначены Primary - т.е. управляющими работой кластера.

Такое не исключено - когда мы включали сервера в кластер, в общем то, логично было сначала добавить все сервера с одного шасси, потом все с другого. И все 5 Primary оказались в первом.

Чтобы измежать подобных проблем, есть два подхода:

1) Делать не один кластер, а несколько.

2) Делать "Reconfigure for HA" после добавления всех хостов - тогда Primary переназначаться в случайном порядке. Проверить, что этот случайный порядок нас устраивает, можно так:

/opt/vmware/aam/bin/ftcli -domain vmware -connect YOURESXHOST -port 8042 -timeout 60 -cmd "listnodes"

Node Type State

----------------------- ------------ --------------

esx1 Primary Agent Running

esx2 Primary Agent Running

esx3 Secondary Agent Running

esx4 Primary Agent Running

esx5 Primary Agent Running

esx6 Secondary Agent Running

esx7 Primary Agent Running

Еще можно попробовать

“more /opt/LGTOaam512/log/aam_config_util_listnodes.log”

или

“more /var/log/vmware/aam/aam_config_util_listnodes.log”

По материалам Blade enclosures and HA.

Гайд для поднятия стенда SRM на одной единственной машине

VMware Site Recovery Manager - продукт потенциально интересный.

Хочется, конечно, попробовать в деле.

Теперь поднять стенд достаточно легко - появилась инструкция "VMware Site Recovery Manager Laptop Demo Guide".

На все про все нам понадобятся:

o VMware Workstation 6.5

o VMware ESX 3.0.2 U1 or 3.5 U1

o VMware VirtualCenter 2.5 U1

o Microsoft Windows Server 2003 SP 2

o VMware Site Recovery Manager v1.0

o VMware Site Recovery Manager Plug-In

o LeftHand Network VSA for VMware ESX(или другой виртуальный сторадж, от NetApp к примеру)

o LeftHand Network Centralized Management Console (CMC)

Требования к ноуту, для получения такой картинки:

- Проц с поддержкой Intel-VT.

- Хотя бы 3 ГБ ОЗУ.

- Хотя бы 12 ГБ места на харде(а если 50 ГБ то совсем хорошо).

вторник, 23 декабря 2008 г.

Видео про SRM

Для владеющих английским и\или кому проще воспринимать видео - ролик про Site Recovery Manager. 15 минут официального рассказа про продукт.

thx Dmitry Tikhovich

Unified Host Utilities Kit 5.0 for ESX Server

Углядел тут интересный пост на блоге про NetApp - Unified Host Utilities Kit 5.0 for ESX Server is Released.

Какая то штука, которая вроде как умеет, в частности:

There's a new utility that has been added, called mbrscan. The purpose of mbrscan is to identify wheather or not a VM has properly aligned partitions.

Ну, и многое другое.

Here's a list of the all the scripts included as part of the Unified Host Utilities Kit v5.0:

# install - Install script for the EHU

# brocade_info - Collects configuration information about Brocade FC switches

# cisco_info - Collects configuration information about Cisco FC switches

# config_hba - Utility used to set HBA parameters for communicating with NetApp storage devices. This script will get run as part of the installation and can be executed subsequently at any time. Support was added for 8GB FC HBAs and well as FCoE CNAs.

# config_mpath - Utility used to determine which of the available paths are primary paths and to set primary paths

# config_nfs - Utility used to set the NetApp recommended NFS Heartbeat settings.

# controller_info - Collects configuration information about NetApp storage devices.

# mbrscan - Utilty used to check vmdk files for proper alignment from the ESX console (for VMFS and NFS datastores), and from unix/linux (NFS datatstores).

# mcdata_info - Collects configuration information about McData FC switches

# qlogic_info - Collects configuration information about QLogic FC switches

# san_version - Prints the EHU version

# sanlun - collects information about the LUNs currently mapped to your host

# uninstall - Uninstall script for the EHU

Видимо, заточена она под NetApp СХД.

бесплатные решения под бесплатный ESXi

Одно из ключевых отличий ESXi с бесплатной лицензий от лицензирования его за денюжку - это отсутствие возможности централизованного управления через vCenter.

Поэтому более чем естественно желание еще бы как нибудь и управление\мониторинг централизованное прикрутить. На халяву.

Вкратце, куда можно глянуть:

Free tools with VirtualCenter -like features - о нескольких полезных утилитах.

Veeam Monitor 3.0 Free Edition - новенькая утилита от Veeam. В бесплатном варианте сильно урезана, зато бесплатна. Про нее по русски еще тут написали - Бесплатная утилита от Veeam Software: free Veeam Monitor for VMware ESXi.

Так же, однозначно имеет смысл смотреть в сторону скриптов.

К примеру:

Top 10 PowerShell scripts that VMware administrators should use.

Так же, PowerShell скрипт для обновления VMware Tools на всех ВМ, в т.числе можно подавить автоматическую перезагрузку. Актуально, когда обновились до Update 3, тулзы надо бы обновлять, а виртуалок несколько сотен.

понедельник, 22 декабря 2008 г.

Мусор в каталоге ВМ

При работе ВМ в её каталоге появляются различные файлы. Не все они одинаково полезны.

Например ВМ-b3ab8ade.vmss

Это файл содержит RAM остановленной (suspended) машины. При старте такой suspended машины, файл (по идее) должен удаляться. Но он остаётся. Не удаляется он и при ребуте (рестарте) ВМ машины. Только при полной её остановке. НО. Если машина уехала через svmotion, то файл остается в старом каталоге, так как нигде в настройках машины (ВМ.vmx) он уже не фигурирует и никогда не будет удален автоматически. Соответственно совет, после выхода из состояния suspend нужно такой файл удалять руками. Вот еще один минус этого состояния.

Так же обнаружил файл vmware-vmx-zdump.000 в старом каталоге ВМ после svmotion. Это файл coredump от ВМ. Его рекомендуют отдать в суппорт. А файл лежит и занимает место.

Видимо нужно писать скрипты для поиска и чистки мусора.

воскресенье, 21 декабря 2008 г.

Как надо использовать снапшоты

Какое то время назад выкладывал прикольный скриншот Snapshot Manager'а.

По какой то причине, картинка практически сразу перестала отображаться, и многие ее не увидели.

Вот она:

Источник - Benefits of VMware Workstation for Branding.

новые полезные статьи в базе знаний VMware

Углядел тут пост про новые полезные статьи в базе знаний vmware - Notable KB Articles from the week.

В общем то, все понятно, так что свои комментарии не добавляю.

суббота, 20 декабря 2008 г.

Обновился VirtualBox

Основным конкурентом VMware Player \ Workstation \ Server на десктопной арене мне видится VirtualBox.

Честно бесплатный, маленький, шустрый.

Тем, кому многого не надо, тем, кто не любит общепризнанных лидеров - в самый раз.

Этот продукт обновился - VirtualBox 2.1.0.

Одна из новых фич:

Experimental LsiLogic and BusLogic SCSI controllers - это означает, что ВМ, созданные под продуктами VMware, заведуться под VirtualBox без дополнительных телодвижений.

Для этой же цели служит и Full VMDK/VHD support including snapshots.

Еще интересная потенциально важная штука - Experimental 3D acceleration via OpenGL.

VMware Infrustructure 4 -> VMware vSphere

Срочно в номер:

появились слухи, что следующая, 4ая, версия VMware Infrustructure будет называться

;)

Обобщение опыта переезда и решения проблем с VMFS

Обобщу всё уже сказанное тут и не совсем тут.

Итак, был переезд с его опытом и проблемами. (Переезд VI3. Опыт. Грабли.)

После включения VI, выяснили что VMFS пустые.

Сначала решили что дело в блокировании LUN'ов. (Проблемы переезда VI). Не помогло.

Затем грешили на snapshot LVM'ов и возможной проблемой LVM.Resignature

(подробнее об этом в документации part1 -> Issue 2).

И это не помогло.

Причины проблемы так и остались не выясненными, но лечение описано (Пропал VMFS раздел - что делать? документация part2 страницы 64-75)

Побочным эффектом стало изменение имени DataStore. (Изменение имени DataStore).

В результате перестали запускаться ВМ со вторыми дисками. (Потеря связанности со вторыми дисками).

В догонку выснились некоторые фичи о необходимости форматировать VMFS (Дефрагментация VMFS).

В итоге инфраструктуру всё-таки подняли.

Спасибо за помощь Антону Жбанкову и Олегу Кириллову (Service department manager OCS Distribution) за консультации.

Так же Олег предоставил документацию, по которой всё и делалось.

Top Support Issues part 1

Top Support Issues part 2

Дефрагментация VMFS

В момент решения проблем с VMFS, дополнительно выяснили у Олега Кириллова из компании OCS, что VMFS подвержена фрагментации.

А именно, файлы на VMFS хранятся единым куском, без возможности разбивки на части. Таким образом, при удалении дисков или целой ВМ, в VMFS остается "дырка" размером с ВМ. И если новая ВМ больше этой дырки, то выделяется новая область VMFS, а старая не задействуется.

Получается, что может наступить момент, когда свободного места на VMFS много, а создать диск на немножно Гб не получится.

А возможности дефрагментации на VMFS нет. Единственный выход - сливать все машины с DataStore и форматировать её.

Такая же ситуация с фрагментацией присутствует и на ряде СХД, но там есть кнопка Defragment.

пятница, 19 декабря 2008 г.

Потеря связанности со вторыми дисками

В продолжение темы переезда - Переезд VI3. Опыт. Грабли и Изменение имени DataStore.

После перерегистрации (unregister/register) ВМ, у которой был второй (или более) диск на другой DataStore, машина не запускается с примерно такими словами "Lock file for disk".

Причина в следующем:

в файле VM.vmx диски описаны таким образом:

диск, который лежит рядом с машиной:

scsi0:0.filename="VM.vmdk"

диск, который лежит на другой DataStore:

scsi0:1.filename = "/vmfs/volumes/vmfs_uuid/VM/VM.vmdk"

где vmfs_uuid это строка примерно следующего вида: 4847ea1e-d1d37316-89fa-001cc4c068c2

В момент разрегистрации ВМ, информация о vmfs_uuid теряется, и (в моем случае) получаются две ссылки на один диск, который лежит в каталоге с ВМ.

А в случае, если имя диска на другой DataStore было отличным от имени ВМ, получим ссылку на несуществующий диск.

Лечение:

после регистрациии машины "вспоминаем" на какой DatStore лежал второй диск, ищем uuid этой DataStore и восстанавливаем его на место в файл конфигурации машины.

Аггресивному маркетингу Майкрософта мы ответим постом про его косяки!

Итак, с мест сообщают, что:

Если делать QuickMigration между хостами с разными процессорами, то нас не предупреждают об этом, и разрешают миграцию. Уточню, что в данном контексте под "разными процессорами" понимаются процессоры с отличающимся набором инструкций. Это означает, что ВМ работает на одном хосте, использует некую функцию его(если использует, это от приложения зависит), а потом она переезжает и не обнаруживает эту функцию. Шок и bsod!

(ну про bsod я приврал, для рифмы. Хотя и его исключить, наверное, нельзя. В приведенном примере и видеоролике падает только приложение)

Читаем подробности - Hyper-V подвергает риску приложения в виртуальных машинах при миграции (Quick Migration) - на vmguru.

Есть даже видеоролик с доказательствами, размещенный на необычном хостинге.

Еще один звоночек - Don’t know much about resource pools.

Да, SCVMM может управлять ESX'ами. Но. Ему для этого нужен VC. И, пока что это управление не совсем отлажено - сейчас SCVMM не особо знаком с такой штукой. как пулы ресурсов в DRS кластере, и игнорирует членство ВМ в них при VMotion.

Коллеги, особенно из Microsoft,

сразу прошу расценивать этот пост не слишком аггресивно.

Я сразу признаю, что обе проблемы носят не слишком тяжелый характер, что их исправят. Скорее всего. Когда нибудь ;)

Так что дискуссии на эти темы затевать, думаю, не стоит.

четверг, 18 декабря 2008 г.

VMware поглотила компанию Tungsten Graphics, занимающуюся разработкой Mesa 3D

Интересно почитать обсуждение.

вторник, 16 декабря 2008 г.

VMware View - это все о нем

VMware View - новое название VMware VDI. Или название новой версии VMware VDI.

Где что про нее можно почитать:

Официально, по английски:

Release Notes.

Documentation Page.

Download Trial Link.

VMware View: What’s New? [PDF; 1.6Mb] - ссылка подсмотрена у Михаила Козлова.

Upd. там же - Новые возможности по виртуализации и централизованному управлнию ПК с VMware View (ранее VMware Virtual Desktop Infrastructure (VDI).

Неофциально, по русски:

VMware View (aka VDI3) у Антона Жбанкова.

UPD. Цена и комплектация VMware View там же.

Компания VMware меняет названия продуктов и выпускает VMware View (новое название VDI) на VMguru.

Так же, интересными могут быть записи англоязычных блоггеров

A New Era for Virtual Desktops - на блоге чувака из NetApp. Рассказывает про View совместно с NetApp.

Пример подсчетов, почему VDI это хорошо - Move over, Minitel; here come virtual desktops - в комментариях.

A New “View” of Virtual Desktop Computing - Неплохой обзор нового.

Отличный пост с картинками про использование места на СХД в VDI решении - Storage Analysis of VMware View Composer.

Нечасто встретишь хенд-мейд картинку:

Приводятся расчеты:

Parent VM is 16G - эти 16 ГБ суть номинальный размер диска каждой клиентской ВМ. Ключевое слово тут - каждой.А следующий пост - критика основы метода экономии места на сторадже - VMware View - Linked Clones Not A Panacea for VDI Storage Pain!.

Replica and source is 2.1G.

1000 machines including swap is 600G.

Grand storage space for 1000 users is 619GB - а это итог. Вместо 16ГБ*1000 юзеров=16 ТБ, мы имеем 0,6 ТБ занятого места после развертывания 1000 клиентских машин. Но см. следующий пост в списке.

Идея в том, что дельты, которые создаются для каждой ВМ, очень быстро вырастают до номинального размера диска ВМ. Каждая дельта. Автор ссылается на свои собственные тесты. Причину он видит в особенности работы NTFS - которая сначала использует обнуленные блоки, и только за их отсутствием будет использовать те, которые заняты удаленными файлами. Например - если мы создадим и сразу удалим файл в 1 ГБ 10 раз подряд, то с т.зрения гостевой ОС у нас свободного места как было, так и осталось. А снапшот(файл дельта) вырос на 10 ГБ.

Таким образом, вещи типа временных интернет файлов, да и вообще любых временных файлов, от того же офиса; кэши дистрибутивов софта и патчей, данные для деинсталляции патчей и т.п... Все это приведет, даже привОдит к быстрому росту дельты.

Наконец, дельты увеличиваются. Увеличиваются блоками по 16 МБ. И каждое увеличение требует резервирования LUN хостом с этой ВМ. Таким образом, на один LUN положив много VDI машин в Liked Clone режиме, мы можем получить снижение производительности из за этих паразитных блокировок LUN'а.

Автор резюмирует: вышесказанное не аксиома, нюансы есть. Тем не менее, он уверен в том, что для многих VDI решений эти проблемы будут актуальны. Он видит решение в "stateless" клиентах, у которых дельта обнуляется после выключения ВМ(хотя это решает только первую проблему).

UPD:

И, наконец, комментарии этого комментария :)

VMware View Composer/Linked Clones - they are NOT a panacea.

Для интересующихся вопросом к ознакомлению рекомендуется.

Так же из почты:

2 свежих статьи от ГУРУ Citrix и VMware.VMware releases their new VDI product, View 3. Here's a 60-second overview.

Do you think VMware is catching up to Citrix in the desktop space? Balderdash! Citrix needs to catch up to VMware.

Достаточно интересное мнение о том, что происходит сейчас в сегменте VDI решений между Citrix и VMware.

И еще из почты:

Вопрос: Как мы знаем VMware View работает только MS AD для аутентификации. Но как быть, например, если используется Novell eDirectory?

Ответ: With Novell’s Identity Manager (http://www.novell.com/documentation/idm36/) you can *easily* synch multiple AD’s from eDirectory info. I have never done it by myself though, but it looks nice in ppt’s.

P.S. Интересно было бы услышать коментарии...

И, буквально, перед сдачей поста в номер :) новости от VMware-Россия:

Референсная архитектура по развёртыванию VMware View. Часть 1.

Цитата:

...

Итак. По адресу http://www.vmware.com/resources/wp/view_reference_architecture_register.html можно пройти регистрацию и получить доступ к следующему набору документов.

* VMware View Reference Architecture;

* Guide to Profile Virtualization;

* Windows XP Deployment Guide:

* Storage Deployment Guide for VMware View.

Данные референсные архитектуры разработаны совместно инженерами VMware и партнёрами. Основной целью их является помощь заказчикам – ИТ-архитекторам, администраторам на этапах планирования, разработки и внедрения решений по внедрению VMware View. Целью создания этих архитектур является предоставление стандартизованного, повторяемого и масштабируемого дизайна решения, который может быть адаптирован к специфичной вычислительной среде и требованиям заказчика.

Теперь пройдёмся кратко по всем документам...

P.S. в декабре-январе в планах составить собственное внятное мнение про продукт, заодно и начать приглашать вас на курсы по нему. Так что если у кого есть интересные вопросы, не требующие немедленного ответа - буду им рад.

Запуск под VMware Workstation \ Server ESX 3.5 и Hyper-V и Xen

ESX 3.5 запускается в ВМ под VMware Workstation.

Так же, под VMware Server 2.0.

Так же, в под VMware Workstation \ Server можно запустить и Hyper-V и Xen.

подробности и пара ссылок - Running ESX 3.5, XenServer 5.0, and Hyper-V on VMware Server 2.0.

Померяемся?

Картинка из разряда "У кого длиннее?" Конечно, в данном случае имеется в виду аптайм.

Конечно, в данном случае имеется в виду аптайм.

Источник.

WAN между vCenter и ESX

Если перед вами стоит проблема - через vCenter управлять стоящим далеко, за медленным каналом, ESX сервером, то вам будет интересен документик - Proven Practice: ROBO - Managing Remote ESX Hosts Over WAN with VirtualCenter.

Пример того, что в нем можно углядеть:

The performance of VC commands listed above is examined with the following network configurations:

Bandwidth | Delay (RTT) | Error Rate | Other Traffic |

56 kbps | 200-300 ms | 0.05%, 0.1% | Up to 60% |

128 kbps | 200-300 ms | 0.05%, 0.1% | Up to 60% |

192 kbps | 500-650 ms | 0.05% | Up to 50% |

256 kbps | 150-250 ms | 0.05% | Up to 50% |

разное от Leo Ramblings

У камрада Leo Ramblings куча интересных постов:

Auditing ESX root logins with email…

как получать оповещение по электронной почте каждый раз, когда кто то логинится в Service Console по рутом.

Кто то из админов ESX интересуется как бы его можно забекапить. Кто то считает что поднять с нуля быстрее. Для первых может быть интересен пост Backing Up your ESX Service Console.

А для вторых - Cloning an ESX Server network configuration. Сеть настроена у всех ESX одинаково - это следствие требований VMotion\DRS\HA. Вот и хорошо бы эту одинаковость обеспечивать автоматически.

Вроде бы уже писал про это, но повторюсь - Linked Clones in ESX 3.5.

Как нам ручками реализовать этот подход к экономии места на сторадже.

Впрочем, см. предыдущий пост про VMware View, где говорится о потенциальных минусах этого подхода.

воскресенье, 14 декабря 2008 г.

MS MOM\SCOM и ESX\VI

Сильная сторона Microsoft - это инфраструктура.

Я думаю, многие из тех, кто использует серверную виртуализацию не от MS, использует ее продукты для управления и мониторинга - SMS\SCCM и MOM\SCOM в первую очередь.

И меняться в будущем тут ничего не будет.

Компания Veeam анонсировала четвертую версию Management Pack для VMware VI.

Так что те, кто использует MOM\SCOM и ESX\VI - у вас есть хороший способ их подружить.

Подготовка к VMware Certified Design Expert (VCDX)

Какое то время назад я писал про новые сертификации VMware - VMware Certified Design Expert (VCDX).

Есть официальный список тем для теста - VMware Enterprise Administration Exam Blueprint v3.5.

А тут еще советуют для подготовки:

Configuration Maximums - все максимумы ESX\VI.

B2V Guide to VMware ESX Server 3 - на вид толковый гад по командной строке ESX.

VMware Enterprise Administration Exam study guide 3 - что то вроде ответа на Blueprint - объяснение многих тем на 75 страницах.

Источник - VMware Certified Design Expert (VCDX).

Баг в ESX\ESXi 3.5 Update 3 HA VM failure monitoring

Если у вас есть ESX\ESXi 3.5 Update 3,

то у вас могут быть проблемы, если вы используете VMware HA со включенным мониторингом ВМ - VM failure monitoring.

Есть вероятность, что этот самый мониторинг будет ребутать ваши ВМ на ровном месте.

Происходит это потому, что при включении или VMotion ВМ может сбиться настройка отсылания heartbeat сигналов. Не получая их HA агент думает: "Ага! нет сигналов, надо бы ее ребутнуть". И ребутает.

Метод решения описан в KB - Virtual Machine may unexpectedly reboot when using VMware HA with Virtual Machine Monitoring on ESX 3.5 Update 3.

Суть решения весьма проста:

1.Disconnect the host from VC (Right click on host in VI Client and select "Disconnect" )

2.Login as root to the ESX Server with SSH.

3.Using a text editor such as nano or vi, edit the file /etc/vmware/hostd/config.xml

4.Set the "heartbeatDelayInSecs" tag under "vmsvc" to 0 seconds as shown here:

<vmsvc>

<heartbeatdelayinsecs>0</heartbeatdelayinsecs>

<enabled>true</enabled>

</vmsvc>

5.Restart the management agents for this change to take effect. See Restarting the Management agents on an ESX Server (1003490).

6.Reconnect the host in VC ( Right click on host in VI Client and select "Connect" )

thx Denis Baturin.

суббота, 13 декабря 2008 г.

Отслеживание изменений в wiki.vm4.ru

Коллеги,

wiki.vm4.ru я завел для структуризации информации.

Время от времени я добавляю туда какую то полезную ссылку, или пишу текст. Это могу делать не только я.

На днях я сообразил, как можно малой кровью сделать общедоступный лог изменений.

Так что, кому интересно следить за новинками wiki - велкам.

Подписывайтесь по rss или email на блог changes.wiki.vm4.ru.

Снапшоты ВМ

Почитал три интересные заметки про снапшоты:

How VMware snapshots work.

Deleting virtual machine snapshots without wasting disk space.

Troubleshooting VMware snapshots.

С использованием информации оттуда переписал страницу про снапшоты на wiki.

Унификация рабочих мест

на руборде задали вопрос:

Возникла необходимость унифицирования ОС win xp, в офисе под разное оборудование. Появилась идея виртуализовать ОС, а на машинах поставить беслатное по виртуализации.

Решил, поставить линукс и vmware server. Как я понял после установки работать с ним можно только через веб. Соответственно вопрос на каком продукте можно получить виртуализованную ОС, при том что она должна автостартовать при включении хоста и раскрываться на полную (точного термина не знаю - т.е. чтобы работа происходила именно в ней)

А в ответ камрад Jaba_B_Ta3e поделился ссылкой - Kiosk system with VMware.

интересная штука.

На компьютере ставится Linux(автор использовал gentoo).

Потом - VMware Workstation.

В ВМ на ней - Windows.

И настраивалось это все следующим образом:

- Включался компьютер. У него загрузка жестко с харда. USB\Fireware отключены в биосе или драйвера для них не грузятся в линуксе - из соображений безопасности.

- У линукса прописан автостарт

vmware -X -q /path/to/the/vmxfile.vmx

эти ключи для запуска ВМ в полноэкранном режиме, и выхода из Workstation после выключения ВМ. Даже больше - скрипт запуска всего этогопрописан в качестве дефолтного оконного менеджера.

Так же прописано выключение хоста после выхода из ВМ. - Стартует ВМ. Само собой, в ней все красиво - патчи, домен, антивирус и т.п.

забавный момент - у автора диск ВМ в режиме "non persistent"- это означает, что после выключения ВМ пропадают все изменения диска с момента включения. "Принцип Дарвина"- когда несколько раз пропадут сохраненные локально данные, даже самые тупые поймут ценность хранения на сервере. - Пользователи работают в Windows в ВМ. (в идеале, работают :)

- Потом выключают ее. Все изменения с ее диском отбрасываются.

После shutdown'а ВМ автоматически следует выход из Workstation.

После выхода из Workstation автоматически выключается Linux.

Выводы автора:

Все работает отлично.

Для улучшения решения автор думает:

Использовать VMware Player вместо Workstation - это дешевле на $200 за каждое место.

Использовать CentOS вместо Gentoo.

Возможно, централизованно хранить образ ВМ.

четверг, 11 декабря 2008 г.

online Hardware Compatibility Guide

Как вы знаете, один из недостатков ESX - это ограниченный список железа, на котором он работает.

Назвать это большим недостатком будет неправильно - "ограниченный" не значит "маленький", и достаточно свериться с соответствующими списками совместимости(HCG), чтобы этот момент не стал проблемой.

Тем более сейчас процесс сверки упрощается.

Встречайте

online Hardware Compatibility Guide.

This online Hardware Compatibility Guide replaces the former Hardware Compatibility Guides for systems, I/O devices, and SAN arrays for ESX 3.0 and greater versions, as well as VMware View Client.

Пример:

Красота!

Притом, обратите внимание на правую панельку этого веб ресурса - пункты оттуда заслуживают интереса. К примеру, What's New.

гипервизор MS Azure

Чуть больше месяца назад писал про слухи о том, что в MS Azure в качестве гипервизора будет использовать не Hyper-V - Azure гипервизор.

Новости на эту тему: Будущее виртуализации в Windows Server и облаке. Часть 6.

Высказывались даже такие точки зрения, что Microsoft разработала ещё один засекреченный гипервизор, который превосходит Hyper-V по всем параметрам. Или, наоборот, что в Windows Azure уже работает вторая версия Hyper-V. В одном эти предположения не ошиблись — в Windows Azure действительно работает не Hyper-V.

Однако, придётся снизить градус пафоса. На самом деле, гипервизор Azure является всего лишь одной из ветвей, которая сравнительно недавно «отпочковалась» от основной версии исходных текстов Hyper-V. Связано это было с тем, что задачи Azure весьма специфические, и при этом чётко ограничен набор моделей оборудования, которое необходимо поддерживать. Иными словами, для Azure оказалось возможно очень тонко оптимизировать гипервизор с использованием узкоспециальных приёмов и драйверов. С другой стороны, при разработке производственной версии Hyper-V стояли принципиально иные задачи. Во-первых, здесь установлены совершенно другие циклы разработки — как мы знаем, первая версия уже была выпущена этим летом, а вторая должна выйти буквально через год. Во-вторых, Hyper-V должен одинаково хорошо работать на всех моделях серверов, которые прошли ряд автоматизированных проверок на совместимость с Windows Server 2008.

В результате в Windows Azure будет работать узкоспециальная версия Hyper-V, которая использует те же основные принципы, что и дистрибутив, ушедший в широкое распространение. При этом она доработана специальным образом, исходя из специфических требований и возможностей ЦОД Microsoft. Из сказанного очевидно, что эта версия не может считаться «другим» гипервизором, не является не «лучше» и не «хуже», чем Hyper-V. Однако понятно, что эта доработанная версия Hyper-V непригодна к массовому применению, и поэтому её широкое распространение никогда не планируется.

различие между ICA в XenApp Server и ICA в XenDesktop

Из почты:

Ниже приведена ссылка с официального блога Citrix. В статье описывается различие между ICA в XenApp Server и ICA в XenDesktop.

http://community.citrix.com/blogs/citrite/martinm/2008/12/02/Why+ICA+is+not+ICA

thx Dmitry Tikhovich.

среда, 10 декабря 2008 г.

Слухи слухи

Возможно, нас ждет повышение стоимости Windows Server Datacenter.

Там же еще раз про лицензирование MS рассказывается.

вторник, 9 декабря 2008 г.

Пара обновлений wiki

Коллеги, лазал тут по разным своим почтовым ящикам, и понаходил несколько попавших в спам писем от вас.

Напомню - я_обязательно_отвечаю, так что если за сутки(ну другие) не ответил - не стесняйтесь написать еще разок, скорее всего дело в спам фильтрах.

По делу:

Инструкции по решению проблем от VMwareWolf.

Логи ESX и vCenter - http://wiki.vm4.ru/logs

воскресенье, 7 декабря 2008 г.

Site Recovery Manager на NetApp - построение тестового стенда

К вопросу о поиграться с Site Recovery Manager -

SRM in a Box.

Building a VMware Site Recovery Manager demo with the Netapp simulator.

This document describes how to install VMware Site Recovery Manager in

VMware workstation with the Netapp simulator.

thx Denis Kazakov.

проблемы с правами в Virtual Center

К вопросу о раздаче прав в vCenter - Lost permissions to a folder in VC.

Проблема:

На папку в VC были даны права Read Only для группы Users. Локальной группы, на машине где стоит VC.

Это привело к тому, что для любого пользователя права на эту папку стали read only. Т.е. и прав на изменение привилегий ни у кого не осталось. И это навсегда.

(кстати, кто был у меня на курсах - я на это обычно стараюсь обратить внимание - что упаси вас бог раздавать права группам, членство в которых автоматическое для всех. Помниться, однажды дали мало прав группе "Гости", притом на корень иерархии. Прав не осталось никаких ни у кого :))

Для решения такой проблемы(перед переустановкой VC ;) рекомендуют попробовать

# Open the SQL Server Enterprice Manager and browse to the VC_DB (or what you have called the VC database)

# Locate the table VPX_ACCESS and right click it and choose Open Table -> Return all rows

# In the buttom of the table you should be able to locate the wrong permissions entery - make a note of the ID.

If you can’t find the user/group, you can browse the VPX_ENTITY table to locate ENTITY_ID you need.

# Open the SQL Query Analyzer an choose the VC database

# To delete the row that contains the wrong permissions run the below SQL code or modify it for you liking.

To only delete row 221 from the table

DELETE FROM esx.VPX_ACCESS WHERE ID = 211

To delete all rows containing a specific user/group from the table

DELETE FROM esx.VPX_ACCESS WHERE PRINCIPAL = 'your_user_group'

И рестартануть службу VC.

Раздача прав, контроль доступа в vCenter

Вполне возможно, перед нами стоит(будет стоять)задача раздать права в иерархии Virtual Center (пора уже привыкать к новому его названию - vCenter).

В этом случае строго рекомендуется к ознакомлению следующие ресурсы:

1) Давно известный официальный pdf - Managing VMware VirtualCenter Roles and PermissionsManaging VMware VirtualCenter Roles and Permissions.

Однако, как показывает практика, его не достаточно. Камрад VMwarewolf говорит, что в саппорт VMware очень часто обращаются с вопросами и проблемами на эту тему.

Для лучшего понимания ситуации был написан документик - VI3 Roles and Permissions, который содержит кое какую уточняющую информацию о правилах раздачи прав, с примерами.

Источник - Understanding VMware Roles and Permissions.

БД на ВМ

"А годятся ли виртуалки для запуска в них серверов БД? Что то мне ссыкатно.." - это один из популярнейших вопросов про виртуализацию, с которым мне приходится сталкиваться.

Ответ, разумеется, положительный. А еще можно ссылаться на официальные вайтпепперы от VMVware -

SQL Server Performance in a VMware Infrastructure 3 Environment

Выводы:

и

The performance results we describe in this paper support the conclusion that running Microsoft

SQL Server 2005 inside VMware virtual machines can provide an effective production-ready

platform for running transaction-processing workloads.

Your IT organization can leverage the sizing data we present in this white paper to deploy

Microsoft SQL Server successfully using VMware Infrastructure 3. By comparing effective workload

throughput and resource utilization for your datacenter with the results presented in this paper,

you can design and size your virtualized environment to meet your SLA targets.

The number of actual users and transactions you can support in a production environment will, of

course, depend on the specific applications used and the intensity of user activity. The results of our tests clearly demonstrate that in a VMware Infrastructure 3 environment, the transaction

throughput scales almost linearly even as the number of clients increases, for every configuration

we tested. Our results show that the throughput rate of UP virtual machine is comparable for 32-

bit and 64-bit environments. However, for SMP virtual machines, the throughput rate is slightly

higher in a 64-bit environment compared to a 32-bit environment. Further, SMP virtual machines

can service a higher number of users. One disadvantage of SMP virtual machines is that they have

higher CPU costs per transaction than UP virtual machines. From a performance perspective, we

recommend using SMP virtual machines rather than UP virtual machines for Microsoft SQL Server,

and if possible, a 64-bit environment if your application stack supports it.

SQL Server Workload Consolidation.

Цитата из "Выводов":

Experiments discussed in this paper demonstrate the highly scalable virtualization platform provided by ESX

3.5 for consolidating servers running SQL Server databases. Results shown indicate the efficiency of ESX in

distributing the processing power available on modern large multi-way servers among multiple virtual

machines, resulting in a very high utilization of the systems. While doing so, ESX provides each virtual

machine a near-native experience through isolation and guaranteed resource allocation. ESX seamlessly

handles variations in demand for resources when the application load in the virtual machines fluctuate, while

at the same time preventing resource hogging by a few virtual machines causing starvation for others in a

shared environment. Just like native platforms, applications continue to meet or exceed their service levels on

a virtualized platform using ESX 3.5, but at much lower cost. All these traits make ESX 3.5 an excellent choice

for consolidating servers running SQL Server databases.

Конечно, VMware всегда можно обвинить в пристрастности. Поэтому можно послушать заведомо беспристрастного Майкрософта, например тут - Окончательный выпуск Hyper-V — занятная статистика, от 26 июня этого года, почти полгода назад. Цитата:

Данные внутреннего развёртывания в Microsoft

1. Служба Microsoft IT использовала Hyper-V начиная с бета-версий.

2. В скором времени общее количество виртуальных машин, которые находятся в промышленной эксплуатации, превысит 500.

3. Планируется до 30 июня перенести в виртуальные машины более четверти инфраструктуры Управления обслуживанием приложений (Application Service Management, ASM).

4. Среди виртуализуемой нагрузки можно выделить два самых популярных направления.

* Веб-серверы IIS — уже виртуализовано 140 серверов, ещё 169 запланированы к миграции;

* СУБД SQL Server — уже виртуализовано 65 серверов, ещё 50 запланированы к миграции;

* помимо этого, заявлено, что виртуализируются любые существующие нагрузки. Например, сервер Exchange, который обслуживает саму команду виртуализации.

5. Заявлено также, что и по результатом этого тестирования не были выявлены какие-либо проблемы.

UPD.

в комментариях задали вопрос про Oracle, поиск(по блогу и в кастомном поимке) пару ссылок сразу показал:

Oracle Database Scalability in VMware® ESX.(что интересно, поиском на сайте VMware я этот док не углядел, хотя искал и про Oracle тоже, а гугл показал на первой странице).

Realistic Virtualization Benchmarks.

Celerra Virtual Machine

Интересная штука: Celerra Virtual Machine.

Судя по описанию, это virtual appliance представляет из себя СХД, умеющую отдавать дисковые ресурсы по iSCSI и NFS.

Притом, похоже, это официальный симулятор Celerra.

Изначально, он поставляется в формате Workstation, и использование его предполагается для обучения или тестов.

Однако, можно ознакомиться с трудами камрадов

Celerra Virtual Appliance HOWTO 101 - Basic Setup and Configuration - и узнать, как его ввести в эксплуатацию на ESX и настроить. Притом подробно, притом с видеороликами в больших количествах.

Celerra Virtual Appliance HOWTO 201 - Adding More Physical Storage - как добавить еще дисковых ресурсов чтобы расшарить их.

Celerra Virtual Appliance HOWTO 301 - Replicating Between Two Celerra VSAs - как настроить репликацию для, в частности, работы с Site Recovery Manager.

суббота, 6 декабря 2008 г.

чуток информации о VIMA

VIMA - VMware Infrastructure Management Assistant.

Как много в этом слове надежд на клевую штуку...

что пока о ней можно сказать:

VIMA - это ВМ. Бесплатно скачивается с соответствующего ресурса.

Зачем ее скачивать?

Она позиционируется как точка централизированного управления инфраструктурой на ESX.

Управления в смысле:

запуска команд и скриптов - для этого в эту ВМ предустановленны RCLI - Remote Command Line Interface. (впрочем, сами RCLI так же можно получить в виде Virtual Appliance, кроме дистрибутивов под Win\Lin)

Кроме RCLI, в составе этой ВМ есть, цитирую

Applications installed include VMware Tool, Perls command line tools that function similarly to the ESX service console commands, the VI Perl Toolkit, Java JRE 1.5, a VMware authentication component called vi-fastpass, a VMware logging component called vi-logger, and a Simple Network Management Protocol (SNMP) server.

Таким образом, если у нас появятся приложения, которые применяются для управления ESX'ами - можно их ставить в VIMA, и из одного места управлять всем. Тем более, есть модули для авторизации.

Плохая новость в том, что пока что с такими приложениями не густо. Я ни одного не знаю.

Лично меня очень воодушевило мнение, что в VIMA можно поставить агент мониторинга железа, и он, работая в этой ВМ, сможет показывать данные по железу. Для ESXi(не ESX) это весьма актуально. Вроде бы(вроде бы), такое возможно. Будет возможно. Судя по этой теме форума, после того, как появятся оптимизированные под такой режим работы агенты.

Two options for installing the VMware Infrastructure Management Assistant.

Тут рассказывается о том, как начать пользоваться ВИМой - скачивание, добавление в иерархию, запуск и первоначальная настройка.

оттуда же VIMA quick tips

1. There is no graphical interface for VIMA as VIMA is a command-line tool as it is here to replace the service console (also a strictly command-line interface).

2. To manage ESX hosts, you need to add them using the following command: sudo vifp addserver (esx host to add)

3. Once servers are added, you need to initialize them with vifpinit (esx host)

4. Just about all VIMA commands start with vicfg-xxxx. There are also the older esxcfg-xxxx.

How VMware Infrastructure Management Assistant bridges the ESXi management gap.

А это продолжение, в котором приводятся некоторые подробности по работе с сабжем.

Кстати, текущая версия ВИМы поддерживает добавление до 20 хостов.

Хостинг ВМ. Продолжение

http://vmware.servirse.ru/

Я уже писал об этом сервисе Хостинг ВМ.

Но в первый раз затронута была техническая составляющая.

Теперь же любезно были затронуты и другие темы:

организационные:

Мы уже поддерживаем оплату через WebMoney и Yandex.Деньги, в ближайшее

время планируем расширить список платежных систем (например - Robox)

Для юр. лиц - работа по договору, с возможностью фиксации в договоре

индивидуальных SLA.

Порядок работы:

для физ. лиц

- заявка через сайт/почту

- мы заводим аккаунт в биллинге

- клиент оплачивает тарифный план, и получает доступ к виртуальной

машине/пулу машин

для юр. лиц:

- заявка на сайте/через почту

- подписание договора

- оплата

- клиент получает доступ к виртуальной машине/пулу.

Т.е. получить доступ к машине можно "не выходя из дома".

Для юр. лиц процесс несколько дольше, из-за согласования и подписания договора.

Для юр. лиц находящихся не в Москве, но желающих быстро арендовать

виртуальную машину вполне возможен такой вариант:

- заявка на почту/через сайт,

- отправка нами на эл. почту заказчика договора,

- если заказчик согласен с договором, то он нам присылает гарантийное письмо,

- мы выдаем доступ к виртуальной машине/пулу,

- пересылка подписанных документов почтой/курьерской службой

Вопросы клиентов:

а) какая реальная производительность/какие ресурсы мне необходимы вот

под такую задачу

б) что значит кол-во процессоров, и как они соотносятся с реальными процессорами

в) как быстро можно изменить кол-во арендуемых ресурсов

г) сколько прямых IP адресов выдается на пул/на одну машину

д) с какой дискретностью можно разделять ресурсы между машинами при аренде пула

е) можно ли получить доступ к архиву ISO образов операционных

систем/можно ли попросить предоставить доступ к специфичному образу

ж) что значат параметры Host Memory Usage, Guest Memory Usage, Memory,

Memory Overhead и т.п., т.е. по сути "как ESX работает с памятью"

з) в чем выгода аренды виртуального сервера в сравнении с арендой

физического сервера

и) в чем выгода аренды виртуального сервера в сравнении с покупкой

физического сервера

Грабли с которыми столкнулись:

а) при создании домена, на W2k3 серверах, нужно очень аккуратно делать

Revert to Snapshot, поскольку возможна потеря связей между

контроллерами.

б) если License Server развернут на виртуальной машине, и хост на

котором он крутился, ушел в down по каким-либо причинам, а потом

быстро вернулся - возможна потеря License Server, из-за чего хосты

переходят в Unlicensed

в) ролевые политики в VC Server - нет поддержки гибких прав

разграничения на доступ к datastore и директориям в

datastore(читать/читать+писать)

г) VC Server не всегда видит пользователей из "не дефолтного" OU в

домене, причем возникали ситуации, когда после удаления OU VC Server

отказывался видеть пользователей даже из дефолтных контейнеров

Статистика применения ПО:

- соотношение *nix/Windows 70/30 - это связано в первую очередь с тем,

что мы пока не подписали SPLA с Microsoft, хотя интерес к аренде

лицензий велик, и растет

- в первую очередь сервера арендуют все-таки для предоставления

публичных сервисов (Web-Server, Game-Server и т.п.) причин этому

видится несколько

- в качестве роутеров для пулов клиенты используют очень часто (более

50% случаев) Vyatta Community Edition

из новых комментариев

Какое то время назад давал ссылку Как использовать Solaris 10 с его ZFS как NFS хранилище для ESX.

Откомментировали:

Еще Solaris 10 u6 теперь поддерживает загрузку и установку на ZFS. В принципе можно использовать Solaris 10 как NFS зранилище, но есть возможность задействовать и как iSCSI. Програмный target теперь идет в нативной поставке дистрибутива и конфигурируется буквально 1й командой. Вот

здесь приведены инструкции как настроить ZFS-том для использования его в iSCSI среде

# zfs create -V 2g tank/volumes/v2

# zfs set shareiscsi=on tank/volumes/v2

# iscsitadm list target

Target: tank/volumes/v2

iSCSI Name: iqn.1986-03.com.sun:02:984fe301-c412-ccc1-cc80-cf9a72aa062a

Connections: 0

Так же, тот же автор добавил коммент и в пост готовый вариант построения отказоустойчивой СХД за крайне небольшие деньги:

Собственно немножко про Solaris 10 и ZFS я говорил в соответствующей теме, добавлю про дешевые СХД - та же компания Sun продает в своем роде уникальную железку Sun Fire X4500 - это 4U сервер имеющий 2 2хCore процессора Opteron, 8 или 16Gb RAM и 48 SATA дисков емкостью или 0.5 или 1Тб. И стоит это всего 10к$ в максимальной комплектации. Также в прошлом месяце Sun был анонсирован выход СХД на базе этого сервера (из 48 дисков 2 частично используется под модифицированный мариант Solaris 10 оформленый как firmware) стоимостью где-то 12к$. Единственный минус - это получается СХД с 1м SP, что не может не огорчать, но можно 2 Х4500 обьединить в кластер (все средствами "firmware" через web-консоль) и раздавать дисковую емкость как по NFS, так и по програмному iSCSI. Еще один огорчительный момент - напрямую на этот сервер ESX не встает, т.к. не имеет драйверов SAS-контролера, что там установлен.

txh камрад Maniaq.

VMware vCenter Site Recovery Manager

Потихоньку буду наверстывать пропущенное.

Во первых, с офигенным опозланием но дам ссылки на VMware vCenter Site Recovery Manager FAQs.

Тот вопрос, на который не ответили сразу, касался лицензирования SRM и VI на обоих сайтах. В этом FAQ внятно отвечается на этот вопрос и дается хорошая картинка:

Single-direction failover. Requires licenses for 2 VirtualCenter Management Servers, 10-CPU VMware Infrastructure, and 6-CPU Site Recovery Manager.

Bi-directional failover. Requires licenses for 2 VirtualCenter Management Servers, 10-CPU VMware Infrastructure, and 10-CPU Site Recovery Manager.

Ну и связанные ссылки - VMware vCenter Site Recovery Manager Documentation;

и первый из заслуживаюих там внимания документов - VMware Site Recovery Manager Compatibility Matrixes - с чем совместно работает SRM.

thx камрадам Анонимный и Chernyaev Sergey.

суббота, 29 ноября 2008 г.

Новости про курсы VMware в России

Коллеги, в последнюю недельку в блог не писал.

Времени нету :(

Нету во многом потому, что кроме работы занимаюсь еще работой - делаю ревью русскоязычной версии курса VMware Infrustructure Install & Configure.

Это гуд.

Так же могу огласить еще пару новостей:

VMware Site Recovery Manager - ориентировочно в первой трети января я буду со страшной силой овладевать этим нереально крутым средством для построения катастрофоустойчивых решений. Думаю, ближе к новому году организовать сбор вопросов по нему. Соответственно, в следующем году можно будет сходить на курс по нему.

VMware VDI становится VMware View.

По VMware View будут два курса - однодневный для партнеров - может быть он будет доступен у нас уже в декабре, хотя начало следующего года более вероятно. На этом курсе теория и практика по VMware View для, повторюсь, партнеров.

В первом квартале у VMware появиться(а у нас станет доступен) трехдневный курс по VMware View, для тех кто прикупил это клевое решение не без помощи парнтеров VMware, которые его предложили используя знания с однодневного курса.

Как то так.

Начало переименования продуктов\фич VMware

Коллеги, углядел тут ссылку на документ: VMware Product Name Changes.

Скоро привычные нам вещи станут называться по другому. Например:

VirtualCenter Server -> VMware vCenter Server.

VMware Update Manager -> VMware vCenter Update Manager.

Даже самостоятельная версия VMware Converter будет называться VMware vCenter Converter Standalone.

Файловая система VMFS теперь - VMware vStorage VMFS.

Все, что связанно с VDI -> теперь связанно с VMware View.

К ознакомлению рекомендуется.

Кстати говоря, вот тут - Подборка страшных слов - можно углядеть логику этого переименования, и понять что еще появиться, из неуказанного в приведенном документе.

пятница, 28 ноября 2008 г.

из переписки

Пришло в аську:

Анюта (15:24:22 28/11/2008)

виртуальная машина - это круто

Анюта (15:24:38 28/11/2008)

мы взяли скопировали чужое и развернули )) и вот у нас есть свой стенд!!!

Анюта (15:24:46 28/11/2008)

ничего особенного не настраивали

Пикантность ситуации в том, что это мне написала моя супруга :)

Так что еще одна компания разработчик программного обеспечения начала осознавать плюсы виртуализации, и Virtual Appliance(мне, кстати, понравился вариант перевода "Виртуальное решение").

Ну и плюс из их жизни:

Под проект нужен сервер.

Покупать свой жаба душит.

Вроде бы дает партнер.

Дает то дает, но забывает дать рельсы. Админы отказываются разворачивать стоечный сервер не в стойке. Сервер неделю лежит в коридоре.

Привозят рельсы. Сервер ставится в стойку. Проект уже горит, админы не спеша(у них свои дела) разворачивают.

Ставят туда VMware Server и два дня трахаются с глюками из за драйверов к сетевушкам.

И вот, на исходе второй недели. сервер в строю.

Теперь, с моим мнением что можно было попробовать Хостинг ВМ, соглашаются. А время то ушло :(

понедельник, 24 ноября 2008 г.

Изменение имени DataStore

При восстановлении VMFS один из Datastore не захотел менять своё имя на правильное. При этом VC помнит что ВМ'ы находятся на недоступном (теперь) DataStore. Изменить имя не получается, оно "залочено" т.е. "используется".

Вариант только один. Разрегистрировать машины (удалить из инвентори), которые ссылаются на этот DataStore, т.е. их конфиги или диски находились на нем. Количество таких машин указано при просмотре DataStore на панели DataStores. Когда количество будет 0, DataStore исчезнет и можно сменить имя на правильное. После этого все машины в ручную нужно зарегистрировать через

vmware-cmd -s register name_machine.vmx

При этом слетают дополнительные диски машин. Но это уже другая история.

Переезд VI3. Опыт. Грабли.

Понадобилось мне переехать. Для этого была отключена вся инфраструктура VI3.

Какие были проблемы.

- Отсутствие бекапов. Да, не удивляйтесь, но их не было.Делайте ! Пусть даже и через Clone на горячей системе, если нет VCB. Такой Clone можно делать начиная с ESX 3.5 U2. Их отсутствие прибавило мне седых волос и убавило нервных клеток (хоть они и восстанавливаются).

- Не делайте suspend для ВМ. После запуска VI и ВМ, часть ВМ машин работала криво. Где отъехала сеть, где демоны, где пинг был огромным. Пришлось всё перезагружать. К тому же с suspend-машину нельзя отредактировать, что очень было надо. Лучше выключить все ВМ машины.

- Видимо отключение ESX хостов надо проводить через maintance mode. После включения VI, луны с VMFS оказались заблокированными. Как с этим бороться.

- DNS это маленькая подзадача. Выносится на отдельную маленькую ВМ. НО ! После включения VC, хосты ввести нельзя - DNS'а нет ! Выход - прописать имена в файл hosts на VC. Правильный выход - второй DNS не на ВМ.

- Не штатная проблема. После включения ESX хостов, у меня не оказалось DataStore's. LUN'ы видны, а DataStore нет. А точнее луны пустые.

Как это получилось я не знаю, и вряд ли когда-нибудь узнаю. Как лечить - рассказано здесь.

воскресенье, 23 ноября 2008 г.

it4business

Коллеги, в рамках взаимного обмена ссылками :) хочу рассказать вам об интересном проекте - it4business.ru.

Портал для IT-менеджеров: для тех кто руководит, принимает решения и отвечает за результат.

этот проект уже третья инкарнация идеи специализированного проекта для специалистов IT-отрасли. Вначале был проект для тестировщиков, потом он стал проектом про тестирование, а сейчас существует как проект для IT-менеджеров, чтобы со временем, возможно, развернуться до проекта про IT и программную инженерию и взаимоотношения с бизнесом.

Из интересного:

Рекомендуемые блоги ИТ специалистов, и подобные ресурсы.

вторник, 18 ноября 2008 г.

Linked Clones in ESX 3.5

Linked clones.

Эта технология уже поддерживается при использовании Lab Manager, и вроде как ее обещают в VI4.

Но можно попользоваться ее фичами и сейчас.

Напомню, что суть этой фичи - в экономии места на диске.

Возможна она, когда у нас есть много однотипных ВМ.

В этом случае удобно хранить одну копию базового образа - то, что едино для многих ВМ, и для каждой индивидуально разницу относительно этого образа.

Подробная инструкция тут - Linked Clones in ESX 3.5.

Это неподдерживаемое решение.

понедельник, 17 ноября 2008 г.

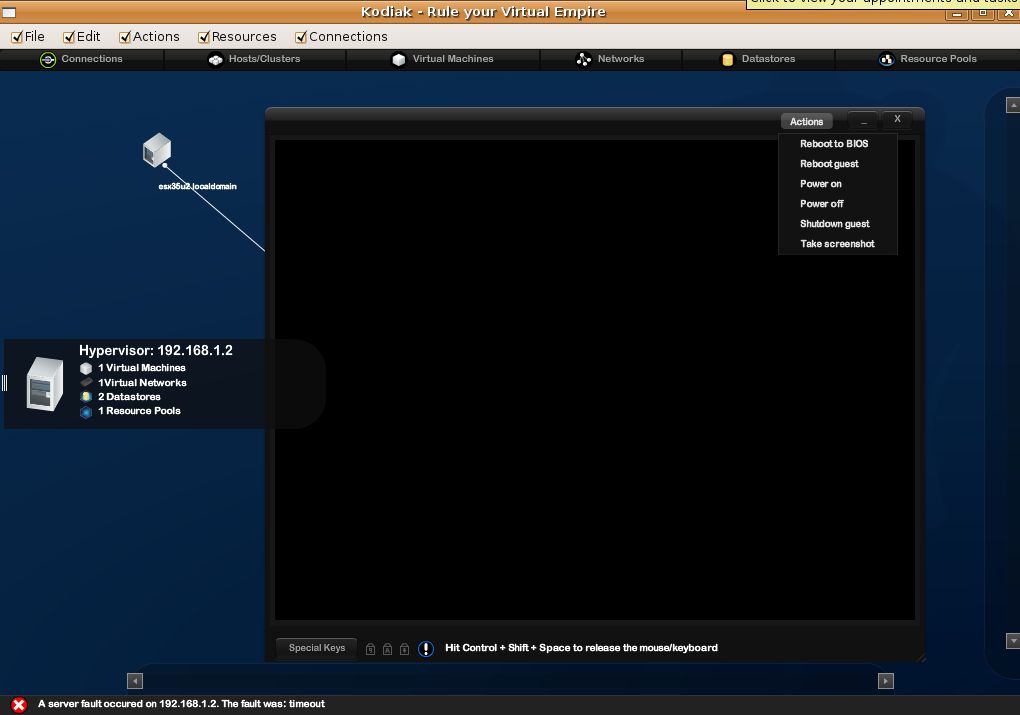

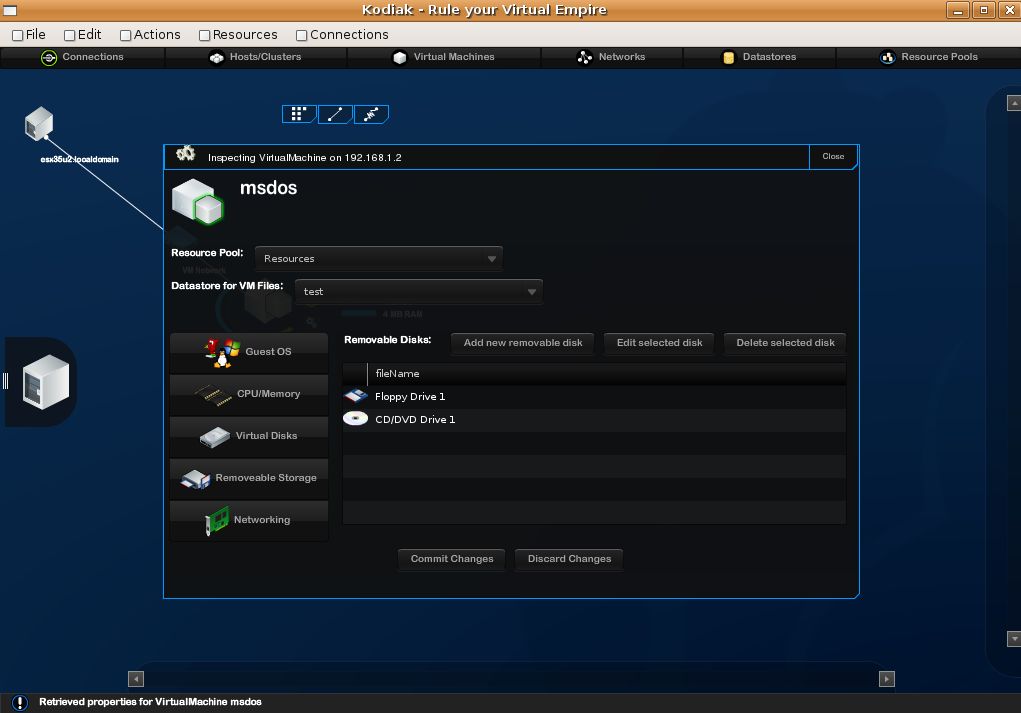

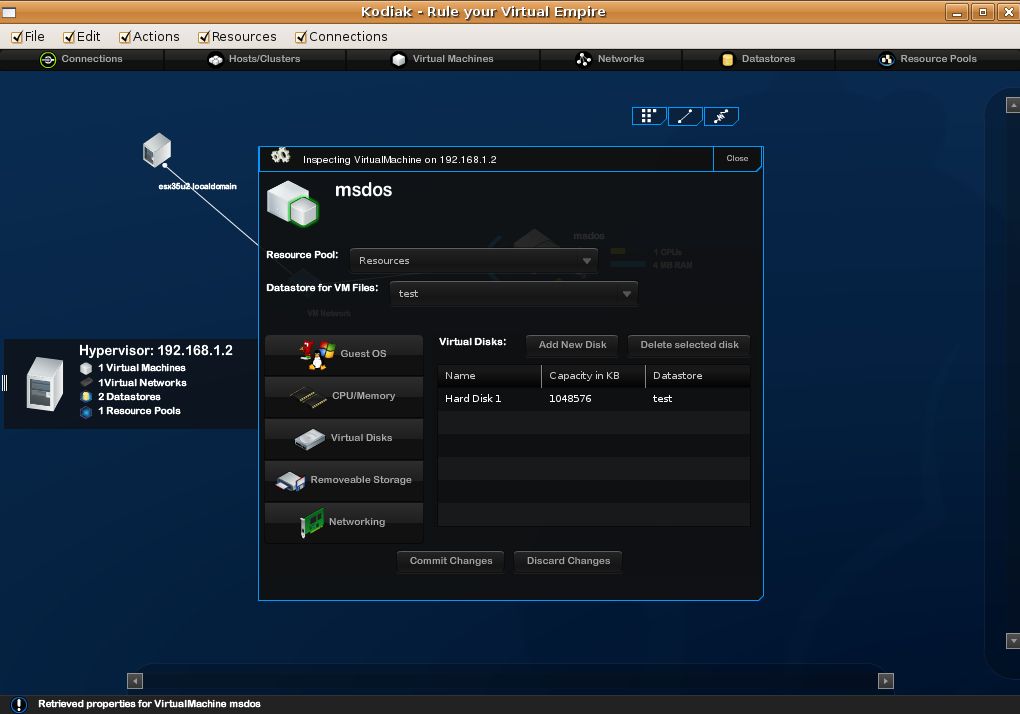

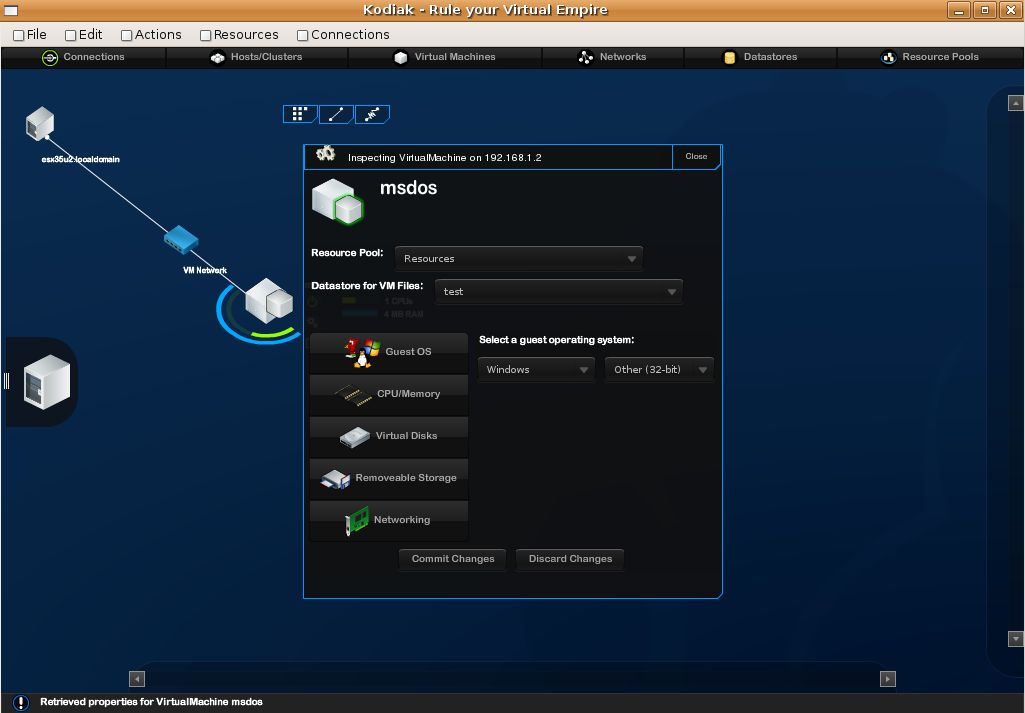

Kodiak

Как то я писал про кроссплатформеный клиент для управления всеми гипервизорами, а потом

Kodiak - кроссплатформеный клиент для управления всеми гипервизорами.

Чтож, проект развивается.

Клиент обрастает функциями.

Красивости же были у него изначально :)

Получил тут краткий отзыв от попробовавшего бету:

Установил, красотища неимоверная конечно :)

Можно визульно мышкой таскать ЕСХ хост и остальное хозяйство по экрану елозит за ним :)

Есть консоль ВМ, редакция свойств у ВМ, браузинг датастор

По функционалу ограничен: со снапшотами ВМ не работает и не дает новую ВМ сделать

Ну и тормозит само по себе временами :)

скриншоты отсюда - Part 2: Bluebear’s Kodiak, what’s all the fuss about….

Еще скрины и инфа на сайте Kodiak.

Видео:

Как подключить NTFS раздел к ESX

Андрей Вахитов радует второй инструкцией:

За основу взяты документы http://communities.vmware.com/thread/47225?tstart=0&start=0 и http://communities.vmware.com/thread/49040?tstart=0&start=15. Я их немного переработал, т.к. следование им не привело меня к требуемому результату.

Если есть необходимость в сервисной консоли ESX Sever 3,5 U2 подключить NTFS-раздел на чтение, то можно воспользоваться командой «mount –t ntfs /dev/sda1 /mnt/ntfs1», где «/dev/sda» – какое-то физическое устройство, на котором мы подключаем партицию №1, а «/mnt/ntfs1» соответственно точка монтирования (аналог логической буквы e:\ в Windows). Список физических устройств нам даст

«esxcfg-vmhbadevs»;

список разделов на дисках «fdisk –l».

Однако при запуске команды «mount» мы получим ошибку – «данная файловая система не поддерживается ядром». Как подружить ядро с NTFS?

0) Т.к. я не очень разбираюсь в линуксе, то по этой инструкции подключать модуль NTFS придется каждый раз после перезагрузки сервера с помощью «modprobe ntfs».

1) В каталоге /lib/modules находим каталог вида «2.4.21-37.0.2.ELvmnix». У меня это «2.4.21-57.ELvmnix». Выполняем резервное копирование

«cp 2.4.21-57.ELvmnix 2.4.21-57.ELvmnix.old».

2) «cd /usr/src/linux-2.4/configs».

3) «nano vmnix.config», ищем строку «CONFIG_NTFS_FS» и изменяем ее на «CONFIG_NTFS_FS=m».

4) «cp vmnix.config kernel-2.4.21-i686-vmnix.config».

5) «cd ..».

6) «nano Makefile». Ищем строку, начинающуюся на «EXTRAVERSION» и меняем ее конец на ELvmnix. (nano Makefile, change the end of the EXTRAVERSION line from ELcustom to ELvmnix).

7) «make oldconfig && make dep».

8) «nano .config». Вносим изменения аналогично пункту №3.

9) «make modules».

10) Если все проделано верно, то в каталоге ./fs/ntfs/ должен появиться драйвер для NTFS – «ntfs.o». Копируем его «cp ./fs/ntfs/ntfs.o /lib/modules/2.4.21-57.ELvmnix/kernel/fs/ntfs/». Если каталога NTFS не существует, сначала необходимо его создать.

11) Теперь можем вручную загрузить драйвер NTFS (пункт№0) и вуаля.

P.S. Нюанс – подключить таким образом можно раздел размером менее 2х терабайт.

воскресенье, 16 ноября 2008 г.

Материалы и отчет по встрече от 31 октября 2008

Что же было 31 октября сего года:

TCO.

Сначала был разговор про подсчет стоимости владения. В качестве основы использовался инструмент для подсчета TCO в виде xls документа. Кстати, он на русском языке, поэтому к ознакомлению рекомендуется.

Основная графа расходов - это СХД, по этому пункту возражений не было. Если она уже есть, то стоимость миграции на виртуальную инфраструктуру меркнет перед выгодами от нее. Если ее нет, то цифирки выгоды чуть менее шоколадны. См. еще тут - Хостинг ВМ.

Важный момент - все это здорово для крупных предприятий, где счет серверов до виртуализации идет на сотни, может быть на десятки. Для компаний поменьше и совсем поменьше стоимость СХД, похоже, перебьет любые выгоды. По крайней мере у меня такое впечатление создалось. Хотя, "СХД" понятие растяжимое. Например, тут мне вспомнился пост “Недоступный NetApp”: мифы и разоблачения. В нев автор утверждает, что коробочное решение от NetApp, поддерживающее iSCSI и NFS с 6 ТБ RAW емкости и 2 годами сервиса обойдется ~ 250 000 руб. Вроде бы, не так много.

На встрече в этом месте разгорелась любопытная дискуссия - "middle range storage". Представители двух банков рассуждали, хороши они или не очень под виртуализацию, пока ими практически одновременно не были произнесены фразы:

"Ну от мидл ренжа больших иопсов не добиться!"

"Ну в мидлж ренже очень неплохие иопсы обойдуться достаточно дешево!"

Когда зал просмеялся, дискуссия как то увяла, а жаль. Вопрос СХД применительно к ESX - один из популярных и сложных практически всегда.

Так же, когда поднялся вопрос про SMB, один из присутствующих признался, что лично он собрал и продал очень дешевое решение - что то вроде пары серверов под ESXi, а в качестве СХД чуть ли не бытовой NFS сторадж с парой SATA дисков. Всех всех очень заинтересовали подробности. И они лично мне были обещаны по мылу - напоминаю об этом публично - к сожалению, я потерял емейл обещавшего :((

Вопрос лицензий тоже достаточно интересен.

Для компаний покрупнее, стоимость лицензий VMware погоды не делает. Ни по деньгам, ни по сложности процесса лицензирования. Чего не скажешь про Майкрософт - опять какое то время было потрачено на вопросы лицензирования ОС и продуктов MS под виртуализацию.

Автоматизация и управление в виртуальной инфраструктуре.

Lab, Stage, Lifecycle и Site recovery Manager'ы.

Доклад представителей VMware. Русскоязычная презентация доступна тут - Презентация M&A. "M&A" означает Management and Automation. Что мне запомнилось из нее:

Lab Manager - продукт для компаний с разработчиками. Предлагает для них:

Быстрое развертывание многомашинных конфигураций.

Библиотеку часто используемых конфигураций.

Портал для пользователей, где они самостоятельно смогут работать с созданием\удалением конфигураций, не дергая IT отдел.

Stage Manager - автоматизация манипуляций с виртуальной инфраструктурой, в первую очередь с ВМ.

Lifecycle Manager - продукт для автоматизации развертывания, в первую очередь. На базе VMware Orchestrator. Пользователь запросил -> админ утвердил -> пользователь получил(в смысле, запрошенную\ые ВМ) -> по истечении срока архивация\удаление ВМ.

Притом, продукт VMware Orchestrator - это офигенно мощная платформа, с помощью которой можно автоматизировать что угодно. Можно прикупить стандартный Lifecycle Manager - тогда он автоматизирует только то, что подготовила VMware - то, что я только что описал. А можно прикупить разблокирование всех возможностей Orchestrator - с его помощью можно автоматизировать хоть захват власти над этой планетой. Были бы разбирающиеся в нем кадры.

Site Recovery Manager(SRM) - решение для упрощения восстановления после катастроф.

Тезисы:

Нужны - резервный ЦОД, репликация СХД. SRM позволяет создать план восстановления, и безопасно оттестировать его. Красноречивый скриншот:

Из минусов для себя отметил необратимость процедуры восстановления, в том смысле что если мы переехали на резервную локацию, то обратно SRM наши ВМ не перетащит сам. Процесс возвращения на основной ЦОД надо будет оформить как восстановление после сбоя резервного ЦОДа.

Был, кстати, вопрос по поводу лицензирования VI на резервном ЦОДе для SRM. Ответить сразу затруднились, сослались на FAQ по SRM. Что то я не нашел этот FAQ %), буду искать.

Далее.

Далее очень здорово выступил Антон Жбанков.

Для начала он рассказал про VDI. Составить впечатление можно по посту на его блоге - VDI - краткое введение и Ограничения лицензии VDI.

Кстати, вопросы лицензирования десктопных ОС под виртуализацию на русском описаны тут и тут.

После этого, рассказал про свой теоретический и практический опыт с разными гипервизорами. К сожалению, в текстовом виде есть разве что его пост Виртуальность от Sun. Надеюсь, он еще осветит этот вопрос.

Была демонстрация беты VI4. За стенд и саму демонстрацию отвечал я. Положа руку на сердце, надо признать, что демо получилось весьма скомканным :(

Т.к. я участвую в бете 4ой версии VI4, я подписывал настолько суровое соглашение о неразглашении, что как только я подумаю, чтобы что то про нее рассказать, как за левым плечом начинает материализовываться фигура безопасника vmware...

так что сошлюсь на данные из общедоступных источников - слухи о VI4, VMware VI и Linux, Некоторые новости VMware.

Коллеги, пока это все, что мне вспомнилось на данный момент.

За любые дополнения и отзывы, которые помогут нам лучше организовывать и проводить подобные мероприятия, буду благодарен.

Хвалительные жду тут в комментариях, ругательные мне на мыло ;)