Коллеги, открыта ссылка на регистрацию на московскую встречу сообщества VMware - тыц.

Смешно сказать, но большая кнопка Register Now пока не работает :-)

Пользуйтесь ссылкой Login to Begin Registration в нижней части страницы.

Мероприятие неофициальное, ресурсов на его рекламу нет - поэтому рекомендую сообщить о нем своим потенциально заинтересованным коллегам.

все вопросы - велкам мне. Mikhail.Mikheev@vm4.ru.

понедельник, 19 марта 2012 г.

VMUG 2012 Registration Page

воскресенье, 18 марта 2012 г.

HP Sizing Tool for VMware vSphere

Прикольная штука попалась на глаза – HP Sizing Tool for VMware vSphere.

На вход задаем параметры, при помощи мастера:

На выходе получаем результат:

5.01

На днях VMware выпустила обновления для большого числа продуктов:

- VMware ESXi 5.0 Update 1 – Release Notes

- VMware vShield 5.0.1 – Release Notes

- VMware vCenter Server 5.0 Update 1 – Release Notes

- VMware vCenter Site Recovery Manager 5.0.1 – Release Notes

- VMware vCloud Director 1.5.1 – Release Notes

- VMware vCenter Configuration Manager 5.5 – Release Notes

- VMware vCenter Chargeback Manager 2.0.1 – Release Notes

- VMware vCenter Server Heartbeat 6.4 Update 1 – Release Notes

Кроме того, появилась и новая версия View -

VMware View 5.01 – Release Notes

- Хорошая новость, особенно для тех кто не доверяет софту без первого сервис-пака

Перед обновлением ознакамливаемся с тем что, и в каком порядке обновлять – Порядок обновления до vSphere 5.0 Update 1.

среда, 14 марта 2012 г.

vmug 2012-1

Коллеги, вот вот откроется регистрация на VMUG в Москве..

UPD.

Коллеги, открыта ссылка на регистрацию на московскую встречу сообщества VMware - тыц.

Смешно сказать, но большая кнопка Register Now пока не работает :-)

Пользуйтесь ссылкой Login to Begin Registration в нижней части страницы.

Мероприятие

неофициальное, ресурсов на его рекламу нет - поэтому рекомендую

сообщить о нем своим потенциально заинтересованным коллегам.

все вопросы - велкам мне. Mikhail.Mikheev@vm4.ru.

Пока же сообщаю программу мероприятия:

- Erik Zandboer (EMC, http://www.vmdamentals.com)

«Тюнинг СХД под View» - Кирилл Сенкевич

«View vs. XenDesktop»

- Антон Жбанков (EMC)

«vSphere 5 HA Deepdive» - Олег Гашников

«Опыт построения национальной платформы распределенной обработки данных» - ОБЕД

- Роман Бобров (Iomega).

«Решения Iomega/EMC для виртуализации в сегменте SMB» - Введенский Константин (старший эксперт по виртуализации, De Novo).

«Обзор VXLAN: как, зачем и почему» - Сергей Щадных (Микротест), Андрей Курочкин.

«-Резервируем небольшой ЦОД.

Дорого.

-Да ладно?!» - Владимир Ескин (Veeam)

«Veeam Backup расширяет горизонты…» - Евгений Киселев (преподаватель, Ciscotrain)

«Несколько слов о живых демонстрациях продуктов VMware» - Игорь Гиркин (Cisco)

“Интеграция физической и виртуальной сетевых инфраструктур”

воскресенье, 11 марта 2012 г.

HP ACU on ESXi

Инструкция по установке и использованию HP Array Configuration Utility на ESXi 4 и 5 - How to run the HP Online ACU CLI for Linux in ESXi.

суббота, 10 марта 2012 г.

Image builder, esxcli

Помните, я писал про Image Builder, средство изменения образов ESXi?

(К слову – как пользоваться Image Builder для интеграции обновлений в дистрибутив ESXi - Customize the VMware ESXi 5 installation media by adding the latest patches using Image Builder)

На эту же тему хочется пару вещей сказать.

У HP есть прямая ссылка на репозиторий своего ПО для ESXi - http://vibsdepot.hp.com. Это упростит добавление или обновление компонентов от HP.

Эту ссылку можно напрямую регистрировать как Software Depot при работе c Image Builder, так и добавлять ее в VMware Update Manager (http://vibsdepot.hp.com/index.xml).

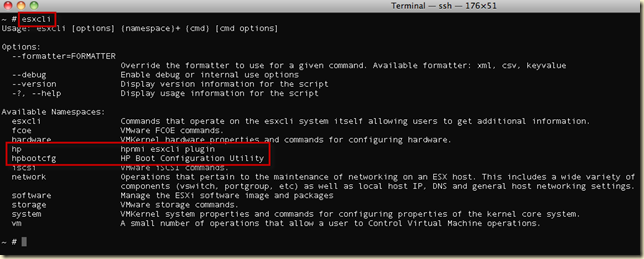

Второе – помните, я упоминал про esxcli – новую “командную строку” ESXi.

Еще одно ее преимущество – она расширяема. Примерно так:

Например, те из вас, кто использует ESXi с аддонами от HP (но HP все не ограничивается), могут обнаружить в пространстве имен (namespace) дополнительные, не входящие в стандартный ESXi.

Receive-Side Scaling

Еще в одной ветке на форуме VMware углядел интересную ссылку – Enable RSS (Receive Side Scaling) on Windows 2008 (R2) Virtual Machines.

Создали ВМ, дали ей два процессора, сетевую карту типа vmxnet3. Нагрузили ее сетевую подсистему, померяли нагрузку на процессоры. Увидели, что занят преимущественно только один процессор:

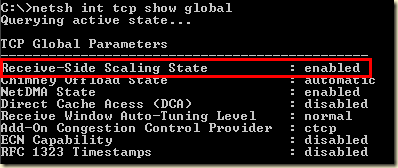

Проверили, включена ли технология Receive-Side Scaling для ОС. Включена:

Проверили, включен ли RSS для сетевой карты. Выключен:

После включения оба процессора стали обрабатывать сетевую нагрузку:

Мораль – включение RSS может дать прирост скорости сети..или избавить от лагов.

Интересно, есть ли противопоказания?

Почитать у MS - Receive-Side Scaling.

ESXi local raid performance

Интересный пост в одной из веток на официальном форуме VMware – Низкая производительность ESX на новых блейдах от HP на базе C3000 .

цитата:

Ну и в общем по теме, хочу поделитсья опытом, надеюсь кому-нибудь будет интересно.

Уже набралось энное количество опыта эксплуатации HP Smart Array контролеров для локальных датасторов на ESXi хостах. В основном это P410i и в 90% случаев там есть кэш (с батарейкой или флэшем)За время эксплуатации на разных дисках регулярно вижу в событиях хоста и датастора (в vSphere клиенте) события двух видов:

1. Время отклика на датасторе "таком то" возросло с тысяч микросекунд до сотен тысяч.....

2. Хост временно потерял доступ к датастору (следом за этим событием обычно идет сообщение что хост восстановил доступ к датастору).

В большинстве случаев такие события наблюдались уже длительное время и не вызывали проблем.

А вот на двух более мощных серверах, где много памяти (и соответственно виртуалок) начались были проблемы. В рабочее время, в пик нагрузки, события о потере хостом доступа к датастору появлялись все чаще, вплоть до 2 раз в минуту... и потом начинались реальные проблемы... все виртуалки начинали тормозить, и все пользователи жаловаться.

Все графики производительности, доступные у вмваре, вместо плавно изменяющихся линий превратились в "расческу"( Все показатели, и сеть, и диск, и время отклика диска, и утилизация процессора).

После всех разбирательств пришел к такому выводу.

Перешивка контроллеров до последней версии ничего не дала, ошибки так и продолжали сыпаться. Обновления прошивок на всем сервере и обновление гипервизора тоже не решило проблемы.

Проведя ряд тестов (с помощью IOmeter генерировал нагрузку) я прошелся по всем вариантам настройки контроллеров.

Вывод у меня такой - для высоконагруженных по дисковым операциям датасторов нельзя собирать Raid6 и Raid5 - эти варианты ожидаемо снижают производительность, а кроме того увеличивают потенциальную нагрузку (больше места - больше виртуалок)

По результатам тестов (я использовал прессеты от сюда: http://vmktree.org/iometer/ , наиболее показательным считаю второй тест60% случайно, 60% чтения - , его результаты и приведу)

Например на HP SmartArray p410i (прошивка 5.06 и 5.14) массив собирал из 8x600GbSAS10k дисков.

raid6 - ~1300 IOps

raid5 - ~1800 IOps

raid10 - ~3000 IOps

Так вот по поводу неочевидного результата.

Во время проведения нагрузочных тестов я мониторил возникающие события на хостах\датасторах. И результат такой - у вариантов с Raid5 и особенно уRaid6 под нагрузкой возникают оба описанных выше события (повышение времени отклика и потеря доступа к датастору). А вот Raid10 держит нагрузку лучше, там под нагрузкой очень редко проскакивают события о повышении времени отклика, но потери доступа не происходит.

Я в итоге понял так, что контроллеру не хватает вычислительной мощности под высокой нагрузкой на Raid6, и в итоге сам контроллер перестает отвечать хосту (на доли секунды). А хот сразу считает что датастор пропал (один единственный путь к датастору сдал нерабочим). Свои выводы я "передал руководству".... сказали что создадут тикеты в обоих техподдержках... но что-то уже месяц тихо.

Ни подтвердить ни опровергнуть свою гипотезу не могу, так что я переделал все на Raid10 и теперь у меня все ОК

thx mazday.

понедельник, 5 марта 2012 г.

VMUG 2012 Moscow

Коллеги, хочу сообщить хорошую новость.

30 марта мы планируем проводить встречу VMware User Group в Москве.

UPD.

Коллеги, открыта ссылка на регистрацию на московскую встречу сообщества VMware - тыц.

Смешно сказать, но большая кнопка Register Now пока не работает :-)

Пользуйтесь ссылкой Login to Begin Registration в нижней части страницы.

Мероприятие

неофициальное, ресурсов на его рекламу нет - поэтому рекомендую

сообщить о нем своим потенциально заинтересованным коллегам.

все вопросы - велкам мне. Mikhail.Mikheev@vm4.ru.

Напомню о чем речь - неофициальное мероприятие, предполагающее определенное количество интересных докладов, много обсуждений и офигенно интересное общение вне докладов.

Опыт предыдущих мероприятий показывает, что среди присутствующих обязательно отыщутся те, чей опыт будет интересен именно вам. Администраторы с опытом, инженеры, архитекторы, руководители ИТ - лично я каждый раз узнавал много нового :-).

Немного позже будет объявлена программа выступлений - сейчас проходят последние согласования.

Всех заинтересованных (а вам интересно, поверьте) я призываю:

- Освободить 30 марта от других дел.

- Дождаться начала регистрации (я сообщу чуть позже) - и после регистрации получить детальную организационную информацию.

Участие бесплатно, будет обед, ожидаются подарки и конкурсы с призами.

Раньше бывал заметный десант из других городов, если кто будет оформлять командировку - без проблем, поможем, печати поставим - но сказать об этом надо заранее. Говорить мне.

По тегу vmug доступна информация о том что бывало раньше.

Кстати, если вам интересно поделиться своим опытом в эксплуатации виртуальной инфраструктуры в виде доклада на vmug - смело пишите, нам есть о чем пообщаться.

mikhail.mikheev@vm4.ru.

воскресенье, 4 марта 2012 г.

memory, tps, large pages

Памятка - информация о памяти, и о TPS в частности.

Memory management - как и что в принципе с оперативкой происходит.

Как сэкономить память в своей виртуальной инфраструктуре - влияние отключения больших страниц на эффективность дедупликации ОЗУ - TPS vs. Large Pages in real life. Данные с боевой инфраструктуры.

Как выключить использование больших страниц для повышения эффективности TPS:.

Сервер -> Configuration -> Advanced Settings -> Mem -> AllocGuestLargePages -> поменять 1 на 0. После этого ВМ или перезагрузить, или мигрировать с этого сервера и вернуть обратно.

Дальнейшие изыскания на ту же тему, данные с тестового стенда - Trasparent Memory page Sharing + Large Pages + Address Space Layout Randomization.

Так как отключение больших страниц - одна из очень немногих настроек, эффект от которой просто шикарен, разумеется хочется знать "А в чем подвох?". Некоторые изыскания по этому поводу тут - boot storm. TPS vs. hardware MMU.

ESXi patch install–установка обновлений на ESXi из командной строки и PowerShell

Чтобы Установить обновление на ESXi из командной строки надо скачать обновление и выбрать какой командной строкой его ставить.

Загрузить файл обновления следует отсюда – http://www.vmware.com/patchmgr/download.portal.

Local CLI

Сначала скопировать файл с обновлением (например ESXi500-201112001.zip) на хранилище ESXi. Можно через встроенный файловый менеджер Browse Datastore.Затем команда

esxcli software vib install --depot=/vmfs/volumes/SharedLUN1/ESXi500-201112001.zip

Затем сервер надо будет перезагрузить и проверить что номер сборки (Build) поменялся.

PowerCLI

В случае PowerCLI два варианта:

спецкомандлет или esxcli

Сначала спецкомандлет:

Архив с обновлением следует распаковать, каталог с распакованным обновлением следует копировать на хранилище. Затем:

Connect-VIServer esxi01.vm4ru.local -User root -Password P@ssw0rd Get-VMHost esxi01.vm4ru.local | Set-VMHost -State Maintenance Get-VMHost esxi01.vm4ru.local | Install-VMHostPatch -Hostpath "/vmfs/volumes/datastore1/ESXi500-201112001/metadata.zip" Restart-VMHost esxi01.vm4ru.local -Confirm:$false

Однако этот командлет носит статус экспериментального. Альтернатива ему – использовать ESXCLI. Эта оболочка должна в будущем стать унифицированным интерфейсом в любой командной строке.

Однако я не понял как.

Зато узнал много полезного про esxcli в PowerCLI из документа http://communities.vmware.com/docs/DOC-14148.

Кратко:

Чтобы в PowerCLI использовать esxcli надо подключаться напрямую к хостам, не к vCenter.

Connect-VIServer <esxi>Вот так инициируется esxcli

$esxcli = Get-esxcli <esxi01.vm4ru.local>Вот так можно спускаться по “неймспейсам”, пространству имен

$esxcli | Get-MemberЕсли какое-то пространство имен нас заинтересовало, можно по нему посмотреть помощь

$esxcli.что-то.что-то.help()Если в этом пространстве имен заинтересовал какой-то метод – можно по нему посмотреть помощь

$esxcli.что-то.что-то.help(метод)Если для метода непонятны параметры, по ним также можно посмотреть помощь:

$esxcli.что-то.что-то.help(метод).Param[0]и т.д.

$esxcli.что-то.что-то.help(метод).Param[1]

Однако когда я смотрю помощь по методу установки:

PS C:\> $esxcli.software.vib.help("install")

=======================================================================================================================

vim.EsxCLI.software.vib.install

-----------------------------------------------------------------------------------------------------------------------

Installs VIB packages from a URL or depot. VIBs may be installed, upgraded, or downgraded. WARNING: If your installation requires a reboot, you need to disable HA first.

Param

-----------------------------------------------------------------------------------------------------------------------

- depot | Specifies full remote URLs of the depot index.xml or server file path pointing to an offline bundle .zip file.

- dry-run | Performs a dry-run only. Report the VIB-level operations that would be performed, but do not change anything in the system.

- force | Bypasses checks for package dependencies, conflicts, obsolescence, and acceptance levels. Reallynot recommended unless you know what you are doing. Use of this option will result in a warningbeing displayed in the vSphere Client.

- maintenance-mode | Pretends that maintenance mode is in effect. Otherwise, installation will stop for live installs that require maintenance mode. This flag has no effect for reboot required remediations.

- no-live-install | Forces an install to /altbootbank even if the VIBs are eligible for live installation or removal. Will cause installation to be skipped on PXE-booted hosts.

- no-sig-check | Bypasses acceptance level verification, including signing. Use of this option poses a large security risk and will result in a SECURITY ALERT warning being displayed in the vSphere Client.

- proxy | Specifies a proxy server to use for HTTP, FTP, and HTTPS connections. The format is proxy-url:po rt.

- vibname | Specifies VIBs from a depot, using one of the following forms: name, name:version, vendor:name, or vendor:name:version.

- viburl | Specifies one or more URLs to VIB packages to install. http:, https:, ftp:, and file: are all supported.

Я не понимаю как этим пользоваться.

По идее, должно быть что-то вроде такого:

$esxcli.software.vib.install(vmfs/volumes/datastore1,$false,$false,$false,$false,$false,$null,ESXi500-201112001.zip,file:/vmfs/volumes/datastore1ESXi500-201112001.zip)но меня смущают первый и последние два параметра.

Так что если кто выскажет дельную мысль – буду благодарен.