Технологии актуальные для SMB

2. Вследствие п.1 в Hyper-V нет технологии «живой» миграции виртуальных машин (ВМ), есть технология Quick Migration. Quick Migration позволяет мигрировать ВМ с временем простоя, требуемым для запуска сохраненного состояния ВМ. В ESX есть – vMotion. В Hyper-V R2 будет Live Migration. По информации LV будет бесплатной в Microsoft Hyper-V Server R2, но пока неясно насколько бесплатным будет софт управления этой виртуализацией. В VMware эти функции есть только в платных изданиях.

Отсутствие этой технологии не позволяет переносить ВМ между физическими хостами без прерывания их работы. Это необходимо в таких ситуациях как: плановая или внеплановая замена/апгрейд сервера или балансировка нагрузки между хостами.

..

Управление Live Migration встроено в стандартную mmc коноль Hyper-V Manager.

FREE 3. В Hyper-V нет технологии Memory Overcommitted и Transparent Page Sharing, позволяющих сократить количество требуемой хосту оперативной памяти до 30%.

Наиболее важной является технология Memory Overcommitted, которая позволяет выделять нескольким ВМ в совокупности ОЗУ больше, чем есть на хосте. При этом ВМ при работе занимает ровно столько ОЗУ, сколько требуется, а не весь выделенный объем. Transparent Page Sharing – технология дедупликации страниц памяти более актуальна для больших виртуальных инфраструктур, где на каждом хосте развернуто большое число ВМ. Также она актуальна для хостов, предназначенных для развертывания веб-серверов или тестовых ОС и приложений.

..

TPS для веб серверов наименее актульана... А вот MO для тестовых машин самое оно...

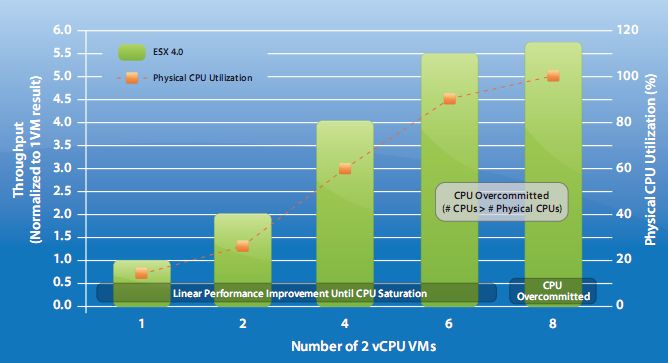

FREE 4. В Hyper-V нет технологии логических процессоров, аналога vSMP от VMware. В Hyper-V R2 эта технология анонсирована (в beta ее нет).

В связи с этим Microsoft не рекомендует разворачивать на одном хосте больше ВМ, чем на нем есть процессорных ядер. Для VMware таких ограничений нет.

..

про vSMP и количество логических процессоров - полный бред

FREE 5. Hyper-V кроме поддержки ОС семейства Windows официально поддерживает только SUSE Linux.

Возможно, на хост Hyper-V можно установить и другие ОС (linux, FreeBSD, Solaris, Novell), но, во-первых, для них нет драйверов оптимизации работы с устройствами, во-вторых, они официально не поддерживаются для производственной среды, а значит техническая поддержка такой конфигурации отсутствует.

FREE 6. Hyper-V поддерживает больший список аппаратного обеспечения, чем VMware, но только за счет использования драйверов от производителей для Windows Server 2008.

Как известно, проблема с драйверами – одна из основных причин проблем с работоспособностью Windows систем. ESX использует только оптимизированные для него же драйверы, поэтому работает гораздо стабильнее.

..

Пусть автор поделиться источниками откуда ему известо, что драйверы - одна из основных причин проблем с работоспособностью Windows систем. ИМХО основаная причина это приложения.

Кстати, работатоспособность WHQL драйверов гарантирует microsoft.

http://www.microsoft.com/whdc/winlogo/default.mspx

FREE 7. Сервер ESXi может быть установлен либо на флеш-карту, либо на SD карту (для ProLiant G6).

Флеш память на порядок надежнее жестких дисков, поэтому сам сервер при такой конфигурации становится намного надежнее. Кроме того, флеш-память в разы дешевле жестких дисков. Hyper-V занимает более 2 Гб, а установка на флеш-память не поддерживается.

..

Windows Server 2008 может быть установлен на 16 Гб флешку, а Hyper-V Server на 4ГБ. Про стоимость флеш памяти и надежность - полнейший бред.

..

насколько мне известно, установка Windows Server на флешку (не SSD) официально не поддерживается.

..

Установка ESXi на флешку так же не поддеживается VMware - поддерживается только покупка флешки(сервера с готовой флешкой).

FREE 8. Сам сервер ESX потребляет максимум 800 Мб ОЗУ, Hyper-V – от 1 Гб.

..

Родительский раздел Windows Server 2008 использует от 600МБ оперативной памяти. Зависит от редакции, настроек и установленных приложений.

..

у меня родительские разделы живут строго на 512 мегабайтах (в варианте установке Core) или 1024 (не Core). Я это точно знаю, потому что Hyper-V выделяет объём памяти для ВМ сразу, а не «по требованию», как ESX(i). Поэтому легко подсчитать, сколько именно осталось самому хосту. («У меня живут» — не значит, что это будет оптимально во всех сценариях. Это значит, что такая конфигурация вполне работоспособна при небольшом количестве ВМ. До пяти, примерно).

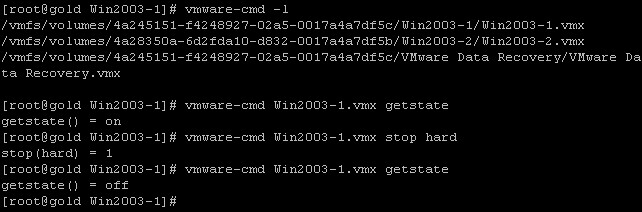

9. VSphere имеет встроенное средство резервного копирования ВМ Data Recovery.

Позволяет делать резервные копии/восстановления ВМ и их отдельных дисков. Поставляется в виде ВМ.

..

Windows Server 2008 имеет встроенное средство резервного копирования Windows Server Backup называется(бывший ntbackup). Включено во все редакции. ;)

..

я бы не стал называть WSB «Бывшим NTbackup». Начнём с того, что NTbackup — это сторонняя технология, которая в далёком прошлом была лицензирована у Veritas. (Примерно так же, как у Veritas лицензирована вся технология денамических дисков, как дефрагментатор Windows был лицензирован сначала у Symantec, а затем у Diskeeper и так далее). WSB — насколько мне известно, полностью самостоятельная разработка. Ну и вообще, сложно найти две более непохожих функции в Windows, чем NTbackup и WSB :)

10. Планируется, что технология Host Clustering (перезапуск ВМ с отказавших серверов) в Hyper-V R2 будет бесплатна. В VMware аналогичная технология HA доступна только в платных изданиях.

В существующей версии Hyper-V для кластера Host Clustering есть требование 1ВМ – 1LUN – это чрезмерное требования к СХД. В Hyper-V R2 такого требования по идее быть не должно

..

Требование 1ВМ на 1LUN – это рекомендация.

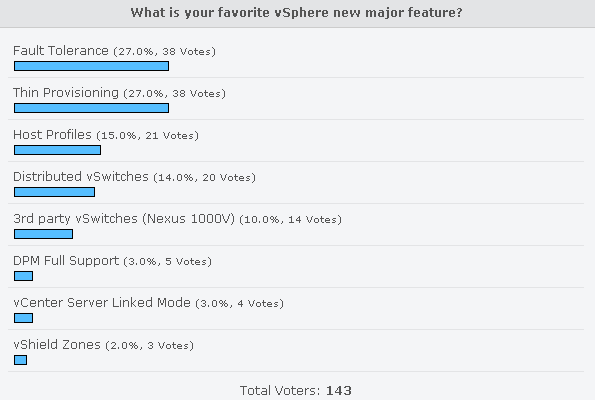

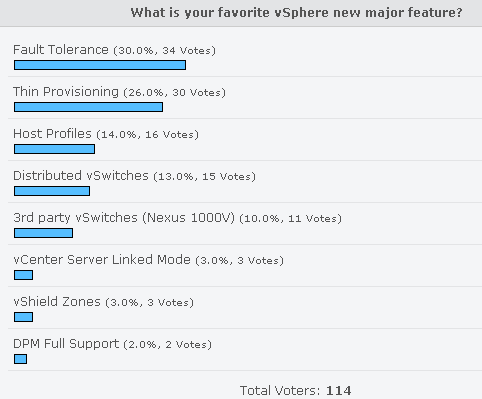

11. vSphere имеет технологию отказоустойчивости без прерывания работы Fault Tolerance (FT). FT позволяет сохранять работоспособность ВМ без прерывания транзакций при отказе хоста. Microsoft делает кластеризацию такого уровня средствами MFC, его плюс в том, что он позволяет защитить от сбоев ПО, а FT – только от сбоев железа.

Кластеризация MFC позволяет кластеризовать лишь выборочные приложения, поддерживающие кластеры Microsoft. FT позволяет кластеризовать любые приложения. Не смотря на то, что эта технология имеет ограничения, она очень важна, т.к. позволяет добиться отказоустойчивости на ранее недоступном уровне. Также для vSphere анонсирована технология, позволяющая в будущем отслеживать состояние процессов в системе, т.е. защититься от сбоев софта.

..

Аналогов технологии VMware Fault Tolerance у Microsoft нет. Но подобный функционал предоставляется ее технологическими партнерами, такими как Marathon или SteelEye.

Технологии обеспечивающие FT доступны с 1999 года.

А защититься от сбоев софта можно только не устанавливая этот софт.

..

Требование «1 ВМ на LUN» неактуально уже давно. Оно было устранено c августа 2008, после http://support.microsoft.com/kb/951308. Это обновление входит в Windows Server 2008 SP2. Единственное важное замечание: это требование остаётся в силе, если вы используете SCVMM. Вернее, он будет работать, но там есть тонкости. SCVMM 2008 R2 закроет эту тему окончательно, и всё будет работать без нюансов.

12. В VMware есть VMware vShield Zones – встроенное низкоуровневое средство обеспечения сетевой безопасности.

Позволяет разграничивать и мониторить доступ к ВМ по сети, обладает также полноценным функционалом firewall. Поставляется ввиде ВМ.

FREE 13. В VMware есть технология VMDirectPath for Virtual Machines.

Эта технология позволяет напрямую подключать некоторые PCI устройства в ВМ. Такими устройствами могут быть Ethernet или SAN адаптеры. Это важно, т.к. к примеру, позволяет в будущем виртуализовать ПО управления системами хранения.

..

Поддержка Intel VT-d очень правильная штука. И microsfot она тоже заявлена. В будущем... когда массово появятся соответствующие адаптеры.

14. Служба VMware Update Manager позволяет централизованно обновлять хост и гостевые ВМ Windows или Linux. Microsoft предлагает WSUS. Он предназначен только для обновления Windows систем, однако имеет более широкие возможности по настройке для обновления Windows.

ПО централизованного обновления позволяет значительно сократить время и сложность администрирования.

FREE 15. Компонент управления виртуальной инфраструктурой vCenter может устанавливаться на Linux, что позволяет сэкономить на лицензиях Windows Server.

Минус в том, что на данный момент такой vCenter обладает меньшим функционалом, чем полноценный.

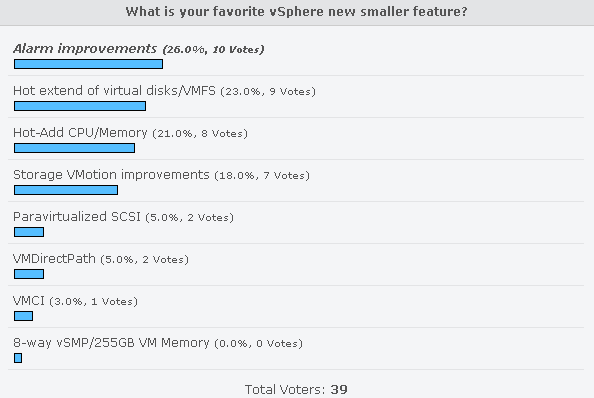

16. vSphere поддерживает горячее добавление оперативной памяти и процессоров в ВМ (Hot Add).

..

vSphere поддерживает горячее добавление оперативной памяти и процессоров в ВМ (Hot Add). Но без перезагрузки на Windows машинах добавление процессоров и памяти работает только редакции DataCenter, только памяти - для Enterprise, а в остальных случаях требуется презгрузка или останвка ВМ.

Технологии актуальные для Enterprise бизнеса

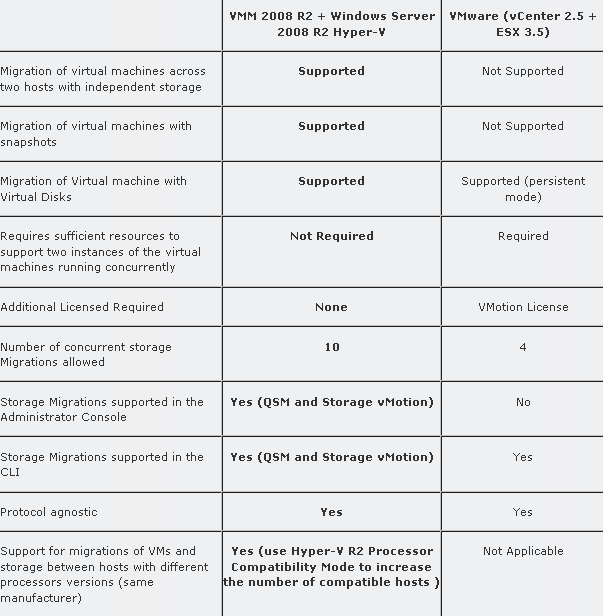

1. В Hyper-V нет Storage Vmotion. В Hyper-V R2 будет Storage Migration – технлогия миграции хранилищ со временем простоя около 2-х минут (зависти от объема файлов ВМ).

Storage Vmotion позволяет мигрировать диски ВМ между хранилищами данных без прерывания работы пользователей.

2. В VMware есть vNetwork Distributed Switch – встроенный коммутатор с поддержкой Private VLAN, Vmotion и виртуальных коммутаторов сторонних производителей.

Позволяет создать единую точку конфигурации взаимодействия виртуальной инфраструктуры. В качестве виртуального коммутатора может выступать также семейство Cisco Nexus 1000V.

3. vSphere в версии Enterprise Plus поддерживает до 8-ми виртуальных процессоров (vCPU).

Не ясным остается вопрос с поддержкой Thin Provisioning для систем хранения данных. В vSphere это есть. Для Hyper-V R2 нет информации на эту тему.

..

Thin Provisioning или Dynamic Disks доступны в Hyper-V. Подозреваю, из R2 этот функционал убирать не станут.