Коллеги, друзья - с новым годом!

Чтобы все было и ничего за это не было ;)

воскресенье, 30 декабря 2012 г.

пятница, 28 декабря 2012 г.

certification

За прошедший год VMware расширила свою сертификацию.

Как было раньше? Раньше был статус VCP. И все. Потом появились "продвинутые" сертификации - VCAP.

А сейчас - VCP это уровень сертификации, но VCP может быть разных направлений. \

То, что раньше было "просто VCP" сейчас "VCP vSphere", а еще есть "VCP Desktop", "VCP Cloud".

И та же самая петрушка с VCAP.

На этом новшевства не останавливаются, целиком ознакомиться с картиной можно тут - Certification.

По старой памяти мне засылают приглашения на бета-версии тестов. Вчера я сдавал тест View Design, дающий право на статус VCAP Desktop. Кстати, тест очень понравился, большинство вопросов по делу.

Некоторое неудобство бета-версий тестов в том, что результатов можно ждать месяцы, а бумажки - еще больше.

Вот только сегодня мне пришли бумажные подтверждения полугодовой давности:

И долго еще буду ждать результатов тестов на Cloud Design (VMware Certified Advanced Professional – Cloud Infrastructure Design (VCAP-CID)), и вышеупомянутый VMware Certified Advanced Professional - Desktop Design (VCAP-DTD).

fdd disconnect after vmotion

Из переписки:

Рабочее решение проблемы подключения флоппи образа после vMotion:

1. Понадобится установленный PowerCLI на сервере с vCenter.

2. Создаем скрипт на сервере с vCenter, например "c:\set_floppy.ps1" с содержанием:

connect-viserver <имя сервера vCenter>

$VMtoConnectFloppy = Get-FloppyDrive -VM "<имя виртуальной машины>"

Set-FloppyDrive $VMtoConnectFloppy -Connected:$true -Confirm:$false

3. Создаем CMD на сервере с vCenter, например "c:\mount_floppy.cmd" с содержанием:

C:\Windows\System32\

WindowsPowerShell\v1.0\ powershell.exe -psc "C:\Program Files (x86)\VMware\Infrastructure\ vSphere PowerCLI\vim.psc1" c:\set_floppy.ps1

4. Создаем ALARM в vCenter на уровне организации:

type = "Virtual Machines"

monitor type = "Monitor for specific events occurring on this object"

Trigger = "VM migrated"

action = "Run a command" в моем случае это "c:\mount_floppy.cmd"

понедельник, 3 декабря 2012 г.

e-Learning

Коллеги, за последнее время появилось несколько онлайн курсов VMware по разным темам.

Список доступен тут - Self-paced eLearning in Local Languages - на сегодня в нем вот что:

- Основы работы с VMware vCenter Operations Manager (VMware vCenter Operations Manager Fundamentals [V5.X]).

Все владельцы vSphere в курсе что этот продкт с немаленькой частью функций доступен бесплатно?

Я немного писал о нем тут. Так что можно запустить загрузку дистрибутива, и с помощью курса понять что с ним делать когда загрузится :) - Виртуализация важных бизнес-приложений (Virtualizing Business-Critical Applications [V5.X])

- Планирование аварийного восстановления и непрерывности бизнеса [v5.X]

- VMware vSphere 5.1: новые возможности.

среда, 21 ноября 2012 г.

http://www.vmwarelearningpaths.com/

Углядел тут сайт, красиво рассказывающий о вариантах (включая только планируемые) сертификации по разным направлениям VMware - http://www.vmwarelearningpaths.com/

понедельник, 19 ноября 2012 г.

vCenter Single Sign On (SSO) and Orchestrator

памятка.

Борясь с настройкой VMware Orchestrator нашел статью базы знаний, где рекомендовалось зайти в Web Client и выполнить настройки в пункте Home -> Administration -> Sign-On and Discovery -> Configuration.

Однако пункта Configuration у меня не было.

Оказалось, надо было авторизоваться в веб-клиенте учетной записью admin@system-domain, а не локальным админом. Под этой учеткой недоступны обычные объекты иерархии, однако доступны некоторые дополнительные настройки.

Так что надо запомнить что в 5.1, для компонента Single Sign On есть такая учетная запись:

admin@system-domain: The vCenter SSO administration account on a Windows installation. The password is set during the initial installation of the vCenter SSO Service.

пятница, 16 ноября 2012 г.

FTP server for VMware ESXi 5.x

Углядел интересную новость - сделан FTP сервер под ESXi.

[Release] ProFTPD (FTP server) for VMware ESXi 5.x

Так что те, кому надо много залить на хранилище, через Browse Datastore заливка медленная, и других идей нет - можно попробовать.

Разумеется, на свой страх и риск.

воскресенье, 11 ноября 2012 г.

VMware View

Памятка:

VMware VDI на базе VMware View 5.1.1: установка и настройка. Часть 1.

VMware VDI на базе VMware View 5.1.1: установка и настройка. Часть 2.

VMware VDI на базе VMware View 5.1.1: установка и настройка. Часть 3.

VMware VDI на базе VMware View 5.1.1: установка и настройка. Часть 4.

VMware VDI на базе VMware View 5.1.1: установка и настройка. Часть 5.

VMware VDI на базе VMware View 5.1.1: установка и настройка. Часть 6: последняя.

View Storage Accelerator in VMware View 5.1.

(Мой старый пост View 4.5 how-to. )

четверг, 1 ноября 2012 г.

VMware Tour 2012

Доступны презентации и лабгайды с нашего мероприятия от 18 октября.

http://vtrussia.ru/Agenda/

http://vtrussia.ru/Labs/

Лаб гайды могут быть интересны сами по себе - для иллюстрации своей темы.

вторник, 16 октября 2012 г.

vtrussia.ru

Напоминаю что в этот четверг, 18го, проходит большая конференция VMware, много с чем интересным.

У меня еще есть коды на большую скидку, обращайтесь.

четверг, 11 октября 2012 г.

VMworld закрывается

Ask the expert

На мой личный взгляд, самое архиполезное на VMworld - большой стенд VMware «Ask the Expert».

Доклады это тоже хорошо, но возможность найти специалиста, разработчика, а то и руководителя разработки по интересуещему продукту - и выслушать комментарии по своим вопросам - очень здорово для технического специалиста.

Помнится, в далеком 2008 я именно на таком стенде узнал неописанные в документации подробности про то, как себя ведет beacon probing в случае проблем когда у вКоммутатора только два аплинка. Меня это тогда очень порадовало.

вторник, 9 октября 2012 г.

VMRussia 2012

Сейчас я на европейском VMworld. Огромное мероприятие. Не удивлюсь, если подсчеты после окончания покажут больше десяти тысяч посетителей. Прямо сейчас я на основной сессии - огромаднейший зал, и везде люди люди люди. Интерес очень большой.

Три дня докладов, лаб, демонстраций - тут очень интересно.

И немного жалко, что большинство подобных мероприятий для нас с вами не «тут», а «там».

Но у нас есть желание поменять эту тенденцию. Первый шаг к, может быть, «VMworld Россия» мы делаем уже в этом году. Более того, внезапно!!!11, на следующей неделе.

Коллеги - в четверг, 18 октября 2012 в Москве будет проходить VMware Tour 2012. День докладов, лаб(!), демонстраций.

Я один из тех, кто отвечает за организацию лабораторных работ (и за один доклад). Но я - один из многих. Наша большая команда прикладывает много усилий чтобы сделать вам интересно.

Сайт - http://vtrussia.ru - там программа, подробности, ссылка на регистрацию.

Горячо рекомендую.

Обратите внимание - мероприятие делаем не для бла-бла, а для дела- участие платное. Давя авторитетом я выбил сколько-то скидок для старых читателей блога - пишите.

Основы работы с VMware vCenter Operations Manager Releases на русском языке

Пока я на VMworld - пришла новость о появлении переведенного на русский язык электронного курса «Основы работы с VMware vCenter Operations Manager».

понедельник, 8 октября 2012 г.

Костя

Лабы

На этих лабораторных работах реализована возможность выполнять лабы со своего ноутбука/планшета (умным словом это называется BYOD).

Эта возможность пользуется огромной популярностью, куча посетителей сидит на диванчиках, пуфиках и лежаках в специальной зоне.

Еще и полдня не прошло, а уже торжественно вручили памятный ништяк тому, кто выполнил 2 000ую лабу. 2000 лаб за несколько часов. Афигеть.

Внутри зала есть статистика - на сейчас было развернуто уже почти 21 000 виртуальных машин - в рамках этих лаб.

Лабы

VMWorld Europe 2012

понедельник, 2 июля 2012 г.

Guest Reclaim - как схлопнуть тонкий диск

Углядел в rss новости от экспериментальных разработок - VMware Labs: Guest Reclaim.

Судя по описанию (попробовать пока не успел), эта консольная Windows-утилита позволяет определить те блоки диска, которые уже не используются для хранения данных.

Напомню, что это важно для тонких дисков - по мере записи новой информации гостем они растут, а вот по мере удаления - не уменьшаются. Эта утилита как раз должна помочь нам "схлопнуть" тонкий диск.

Рекомендуется провести дефрагментацию диска перед применением утилиты - это может повысить эффективность схлопывания. Однако будьте внимательны - дефрагментация может вызвать значительное увеличение размера тонкого диска - и лучше бы у вас было достаточно места на хранилище для этого увеличения.

Кроме того, у ВМ не должно быть снапшотов.

С Linked Clones так же не работает.

В доке указано, что версия виртуального железа не должна быть меньше чем 9. Наверное. имелась в виду максимальная в ESXi 5 версия 8.

UPD.

Из переписки:

Миша, прив. версия 9 это из ESXi 5.1. У меня бета просто.С учетом этого комментария работоспособность утилиты под 5.0 под большим вопросом :(

Это я к вопросу об утилите.

видимо на 5.0 не будет работать?

Не, не будет.

Версия гостевой ОС - WinXP/Vista/7, Win2003/2008. Только NTFS.

Запускать как-то так

guestReclaim.exe --volumefreespace D:\

Сам я, к сожалению, не успел еще попробовать в деле - кто попробует на тестовой ВМ отпишитесь плиз что и как.

P.S. Интересная фраза из документа, цитирую:

Dead space from the virtual disk is released to the underlying VMFS data store. VMFS can then repurpose space for other virtual disk. Future releases of ESX will have tools that can further release this dead space to the backend array.

четверг, 31 мая 2012 г.

View Client resolution

Коллега обратил мое внимание на то, что новый клиент View для нового iPad позволяет выставить новое разрешение:

Кроме того, забавный факт - при подключении айпада к монитору\телевизору\проектору клиент View выводит рабочий стол на внешнее устройство, а сам iPad становится большим тачпадом. Выглядит довольно забавно, но я попробовал - резон в этом есть.

среда, 30 мая 2012 г.

Veeam One

Меня пригласили провести вебинар по продукту Veeam One.

Так как мне давно было интересно с ним поразбираться - согласился.

Так что отмечайте 21 июня в календаре и регистрируйтесь - приложу силы чтобы сделать вам интересно :-)

среда, 23 мая 2012 г.

the book, ebook

Коллеги, электронная версия книги по vSphere 5 ужe доступна.

Издатель экспериментирует - вам предлагается защищенный pdf. Чтение возможно на компьютере, на каком-то одном компьютере на одну купленную лицензию - но это полноценная электронная версия с поиском (разве что без копипаста).

На сайте есть некоторые шероховатости (улыбает рекомендация выбрать доставку почтой россии для электронной книги :) ), но в целом все работает.

Так что велкам - Администрирование VMware vSphere 5. Цифровая книга.

P.S. Лично я понимаю, что такой формат умерено удобен для компьютера и не применим для чтения на планшетах, телефонах и читалках - но я не имею отношения к продажам.

Так что писать об этом здесь или мне на почту смысла нет.

Опрос про более качественный вариант

Коллеги, по поводу книги была интересная переписка одного из вас с издателем:

++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++

Вопрос:

Добрый день.

Ваше издательство планирует через неделю выпустить

книгу Михаила Михеева "Администрирование VMware vSphere 5".

Интересует потенциальная возможность выпуска ограниченной "подарочной" серии 50-100 экземпляров данной книги в твёрдой обложке с цветными иллюстрациями.

Сколько примерно может стоить такая версия?

Ответ:

Добрый день!

В цвете у нас был план выпустить порядка 100 экз. и продавать только через наш сайт.

Но речь шла о мягкой обложке, а не твердом переплете.

В обложке цена была бы ок. 800 р., в переплете – 900 р.

Игра стоит свеч по вашему мнению?

Вопрос:

Добрый день, коллеги.

Можно предварительно инициировать на сайте

Михаила опрос или предварительный заказ такого издания. А по его

результатам определить формат обложки и целесообразность издания.

Лично мне интересен такой формат:

1. Твёрдый переплёт

2. Цвет

3. Автограф

4. Цена не более 1000 рублей

Ответ:

воскресенье, 20 мая 2012 г.

the book, III

Коллеги, обратите внимание на эту картинку:

Да, да, я хочу третий раз продать вам ту же самую книгу

А если серьезно, то издатель уже принимает предварительные заказы по сниженной цене.

(На самый первый тираж тоже был предварительный заказ, и с ним не все было гладко. Но в этот раз издатель обещает исправиться (из переписки):

Михаил, добрый день!)

Книга в типографии, к форуму VMware (30 мая) будет тираж.

На нашем сайте разместил анонс с возможностью заказа книги по льготной цене.

Уже почти все автоматизировано, так что будет проще чем прошлый раз с первой книгой.

Замечу что мы на сайте продаем книги ТОЛЬКО ПО ПРЕДОПЛАТЕ с доставкой курьером по Москве и почтой по России. Самовывоз в Москве тоже будет.

Также на сайт поместим эл. версию книги в защищенном виде – уже почти все готово.

Что поменялось в третьем издании:

- убрал неактуальную инфу – например о ESX, теперь же только ESXi;

- добавил новый фичи vSphere 5 (Storage DRS, Profile Driven Storage и др.);

- кучу всего по мелочам (например, для многих действий добавил как их сделать через PowerShell);

- сделал предметный указатель (судя по отзывам – можно было добавлять только его, про все остальное отзывов\пожеланий практически не было

).

Оглавление\указатель:

Как-то так.

среда, 9 мая 2012 г.

Мероприятие в Екатеринбурге

Коллеги, думаю, некоторым будет интересно – 15 мая в Екатеринбурге будет проходить официальная конференция VMware. Это редкая возможность послушать “из первых рук” как и что мы видим и планируем в плане вектора развития – официальные мероприятия VMware, проводимые с внешней стороны МКАД редки, и это одно из них.

Уважаемые коллеги!

Мы рады пригласить вас на конференцию VMware End-User Computing & Datacenter virtualization Roadshow, посвященную виртуализации ЦОД, рабочих мест и приложений.

Конференция пройдет 15 мая 2012 в Екатеринбурге, по адресу: Гостиница "Маринс Парк Отель", ул. Челюскинцев, д. 106

Виртуализация входит в список приоритетов многих ИТ-директоров, поскольку приносит значительные выгоды и высокую окупаемость вложений: обеспечивается непрерывность бизнеса, существенно сокращаются расходы на клиентское оборудование, повышается защищенность данных, упрощается обслуживание, резервное копирование и восстановление данных, ускоряется развертывание приложений.

Во время мероприятия у вас будет уникальная возможность напрямую пообщаться с экспертами компании VMware, посмотреть решение VMware View в действии и узнать об опыте внедрения этого решения от ваших коллег и компаний-партнеров.

Участие в мероприятии бесплатное.

Регистрация обязательна.

Предварительная программа:

09:00 – 10:00

Регистрация и приветственный кофе

10:00 – 10:05

Приветственное слово главы представительства VMware в России и СНГ

10:05 – 10:30

Общее облачное видение. Доклад представителя VMware

10:30 – 11:10

Виртуализация датацентров. Доклад представителя VMware

11:10 – 11:30

Кофе-брейк. Работа демо-зоны

11:30 – 12:10

Серверные решения для виртуализации серверов и рабочих мест. Доклад представителя Генерального партнера конференции

12:10 – 12:40

История успешного внедрения VMware View. Докладчик уточняется

12:40 – 13:00

Кофе-брейк. Работа демо-зоны

13:00 – 14:15

Возможности VMware View 5 и VMware ThinApp. Доклад представителя VMware

14:15 – 15:15

Обед. Работа демо-зоны

15:15 – 15:40

Интегрированные с VDI решения и клиентские рабочие места. Доклад Золотого партнера конференции

15:40 – 16:05

Доклад Золотого партнера конференции

16:05 – 16:30

Кофе-брейк. Работа демо-зоны

16:30 – 16:50

Доклад Золотого партнера конференции

16:50 – 17:15

Доклад Золотого партнера конференции

17:15 – 18:00

Фуршет

РЕГИСТРАЦИЯ

С уважением,

Команда VMware

VMware Site Recovery Manager

Правильный vExpert Евгений продолжает ваять нетленку про продукты VMware. Теперь набор how-to про Site recovery Manager – продукт для переноса инфраструктуры на резервную площадку, т.е.для создания катастрофоустойчивой инфраструктуры.

Развертывание VMware SRM 5: часть 1.

У VMware есть замечательный продукт по защите целых сайтов от сбоев и катастроф – VMware SRM. В случае, если падает целый датацентр и у нас есть реплицированная копия датацентра в каком-либо ином месте, мы переключаем сервисы на эту копию, и продолжаем работать:

В данном мануале мы развернем VMware SRM 5 с использованием Array-Based Replication, попробуем защитить от сбоя одну VM и протестировать работоспособность VMware SRM.

Развертывание VMware SRM 5: часть 2.

Array-Based Replication: SnapMirror

Развертывание VMware SRM 5: часть 3.

Установка VMware SRM и SRA (Storage Replication Adapter )

Развертывание VMware SRM 5: часть 4.

Настройка VMware SRM.

Развертывание VMware SRM 5: часть 5 – последняя!

Тестирование VMware SRM

В актуальной версии SRM (SRM 5) умеет делать репликацию и своими силами, без репликации на уровне системы хранения данных.

Кроме того, в пятой версии появилась функция Automated Failback, ее можно охарактеризовать как “вернуть все взад”, в том смысле что это автоматизированный процесс возвращения инфраструктуры с резервной на основную площадку.

Про эти вещи можно глянуть вот эту интересную статью - Failback with SRM and vSphere Replication.

вторник, 1 мая 2012 г.

vCloud & Chargeback from jabuin

Коллеги, интересный цикл постов от одного из наших vExpert'ов:

Облако VMware vCloud: часть 1 - .. - Облако VMware vCloud&Chargeback: часть 9 – последняя!.

Рекомендую.

среда, 25 апреля 2012 г.

vCenter Operations Manager

Коллеги, есть такая интересная и даже очень интересная штука - vCenter Operations Manager.

Это автоматическая аналитика vSphere, вот в двух словах так:

А не в двух - шикарная штука, которая покажет ОЧЕНЬ много инфы о вашей инфраструктуре в самых разных разрезах. Притом это не "значение счетчика такого-то = 40", а "значение счетчика такого-то выше чем обычно - подозрительно!". Т.е. акцент я тут делаю на автоматической аналитике. Полезные вещи для себя, красивые картинки начальству, все дела :-)

Вот, к примеру:

Рекомендую попробовать в деле триальную версию.

1) Идем на vmware.com/products, загружаем дистрибутив.

Нас интересует комплект vCenter Operations Management Suite.

Затем жмем Download Free Trial.

Авторизуемся или заводим учетку.

Если завели новую то после активации учетки по ссылке в письме получаем доступ к лицензиям и дистрибутивам.

В vCenter Management Suite входят несколько продуктов, он бывает разных версий (в основном набором продуктов и отличающиеся, но не только).

Сейчас берем vCenter Operations Manager

2) Продукт в виде Virtual Appliance, вводится в эксплуатацию за пару минут. На выходе вы получите vApp с двумя ВМ внутри.

Что потребуется:

- группа портов куда будет подключена пара ВМ, два IP адреса (с возможностью подключиться к vCenter), IP pool (см. ниже);

- 900 гигабайт(!) места. В идеале. Если у вас найдется лишний террабайт места - вы развернете эти ВМ с толстыми дисками. Если нет - с тонкими. Навскидку, для демо, гигов 200 обычно хватает (для демо!!!!). Но с тонкими дисками почему-то могут быть лаги в интерфейсе. Владельцам СХД с правильной дедупликацией\тонкими LUN повезло;

- учетка с правами read-only на те объекты vCenter, инфа о которых нужна. Часто это корень иерархии. Несколько vCenter подключить можно.

- DRS кластер или сервер не в кластере. Кластер без включенного DRS не годится - в нем не могут существовать vApp. Если вдруг у вас только так - освободите один сервер, выведите его из кластера, импортируйте на него vApp, вытащите ВМ из этого vApp, возвращайте хост обратно в кластер и в нормальную эксплуатацию.

Подключайтесь клиентом vSphere к vCenter, выделяйте Datacenter куда будете развертывать загруженный апплайнс. Вкладка IP Pools. Там вам необходимо создать новый IP pool. Заполняем вкладки IPv4 (флажок Enable IP pool _не_ ставим), DNS, Assotiations (выбираем ту группу портов куда будем импортируемые ВМ подключать, если ее еще нет - Cancel и создаем). Этот пул - суть фикция, но данные лучше указать корректные.

Затем File -> Deploy ovf template -> находим ранее загруженный *.ova -> next next next.

На какие шаги мастера стоит обратить внимание:

- Deployment Configuration - если у вас менее 1500 ВМ, оставляйте small;

- Storage - лучше бы хранилище с террабайтом свободного места;

- Disk Format - если место есть лучше thick;

- Network Mapping - правильную группу портов;

- IP Address Allocation - Fixed. На следующем шаге указываем те IP адреса, которые присвоятся двум импортируемым ВМ. Адрес UI VM - на него будете потом стучаться в веб-интерфейс, запомните какой дали;

- Ставим флажок Power on after deployment, Finish, ждем пока испортируется и включится.

Авторизуемся как admin/admin (не забываем поменять пароль на недефолтный, незабываем незабыть новый пароль).

Регистрируем vCenter с которого будут сниматься данные:

- Registration user - пользователь от имени которого Operations Manager обратится на vCenter один раз, сейчас, для регистрации. Это должен быть пользователь с административными правами на vCenter.

- Collector user - пользователь, упомянутый выше, с правами read-only.

Картинка как на самом первом рисунке появится через несколько минут, смысл обретет на следующее утро - сами понимаете, для анализа статистических данных статистику надо бы накопить. Появится она по адресу https:// UI VM IP/vcops-vsphere.

Разумеется, за кадром осталось много вкусного. Это и "а как понять _вот_это_что-то_ при углублении в первую картинку?", и "а что я вижу зайдя на https:// UI VM IP/vcops-custom/ и какой профит я могу извлечь?", и "а как интегрировать с HP Openview и SCOM?", и "а как мне таки сделать вот ту карту как на втором рисунке?", и другие.

Не переключайтесь ;-)

Кстати, вопросы можно задавать - гарантий быстрого ответа дать не могу, но неспеша постараюсь ответы давать.

Кстати, для тех кто любит читать инструкцию до наступания на грабли - Admin guide.

Кстати - буду благодарен если поделитесь на почту скриншотами заглавных цифирок (картинка 1) своих боевых инфраструктур. mailto:mikhail.mikheev@vm4.ru.

понедельник, 23 апреля 2012 г.

VMUG videos

Коллеги, в конце марта была знаковая встреча VMUG - с видеозаписью докладов.

Встречайте - все 10 докладов на youtube.

upd. На рутрекере.

вторник, 17 апреля 2012 г.

vExpert

Вроде бы я стал vExpert 2012, по блату за заслуги :-)

Надо пожалуй напрячься и начать писать в блог, по крайней мере о самом интересном.

А то в юбилейный пятый раз уже не дадут :-)

Поздравляю всех причастных :)

понедельник, 2 апреля 2012 г.

VMUG 2012-1

Коллеги, прошла встреча сообщества VMware в Москве.

В ней участвовало более 200 человек, частично приехавшие из других городов и даже стран.

Было проведено 10 докладов. Интерес вызывал каждый.

Удалось привлечь западных докладчиков, в том числе из группы разработки VMware - планируем продолжить и развить эту практику в перспективе, для того чтобы максимизировать техническое качество и полезность докладов.

Множество дискуссий - последних дискутирующих остановило только то, что гардероб закрывется в 19. Ну как остановило - переместило к гардеробу :-)

Впервые в истории мероприятия осуществлялась видеозапись докладов.

По результатам:

Ориентировочно скоро будут доступны материалы выступлений (видео - позже, в связи с трудоемкостью обработки и подготовки).

Следующее мероприятие по сильно предварительным планам хотим провести в октябре.

Есть интерес к проведению VMUG за пределами дефолт-сити - но тут нам нужна помощь с мест. Интересно поучаствовать в организации? Мы поможем. Пишите! (Кстати, границами России наши интересы тоже не ограничиваются).

Кстати - кто там был и фотографировал - буду благодарен если поделитесь фотографиями. Для начала - VMUG Russia 2012 (Фотоотчет).

понедельник, 19 марта 2012 г.

VMUG 2012 Registration Page

Коллеги, открыта ссылка на регистрацию на московскую встречу сообщества VMware - тыц.

Смешно сказать, но большая кнопка Register Now пока не работает :-)

Пользуйтесь ссылкой Login to Begin Registration в нижней части страницы.

Мероприятие неофициальное, ресурсов на его рекламу нет - поэтому рекомендую сообщить о нем своим потенциально заинтересованным коллегам.

все вопросы - велкам мне. Mikhail.Mikheev@vm4.ru.

воскресенье, 18 марта 2012 г.

HP Sizing Tool for VMware vSphere

Прикольная штука попалась на глаза – HP Sizing Tool for VMware vSphere.

На вход задаем параметры, при помощи мастера:

На выходе получаем результат:

5.01

На днях VMware выпустила обновления для большого числа продуктов:

- VMware ESXi 5.0 Update 1 – Release Notes

- VMware vShield 5.0.1 – Release Notes

- VMware vCenter Server 5.0 Update 1 – Release Notes

- VMware vCenter Site Recovery Manager 5.0.1 – Release Notes

- VMware vCloud Director 1.5.1 – Release Notes

- VMware vCenter Configuration Manager 5.5 – Release Notes

- VMware vCenter Chargeback Manager 2.0.1 – Release Notes

- VMware vCenter Server Heartbeat 6.4 Update 1 – Release Notes

Кроме того, появилась и новая версия View -

VMware View 5.01 – Release Notes

- Хорошая новость, особенно для тех кто не доверяет софту без первого сервис-пака

Перед обновлением ознакамливаемся с тем что, и в каком порядке обновлять – Порядок обновления до vSphere 5.0 Update 1.

среда, 14 марта 2012 г.

vmug 2012-1

Коллеги, вот вот откроется регистрация на VMUG в Москве..

UPD.

Коллеги, открыта ссылка на регистрацию на московскую встречу сообщества VMware - тыц.

Смешно сказать, но большая кнопка Register Now пока не работает :-)

Пользуйтесь ссылкой Login to Begin Registration в нижней части страницы.

Мероприятие

неофициальное, ресурсов на его рекламу нет - поэтому рекомендую

сообщить о нем своим потенциально заинтересованным коллегам.

все вопросы - велкам мне. Mikhail.Mikheev@vm4.ru.

Пока же сообщаю программу мероприятия:

- Erik Zandboer (EMC, http://www.vmdamentals.com)

«Тюнинг СХД под View» - Кирилл Сенкевич

«View vs. XenDesktop»

- Антон Жбанков (EMC)

«vSphere 5 HA Deepdive» - Олег Гашников

«Опыт построения национальной платформы распределенной обработки данных» - ОБЕД

- Роман Бобров (Iomega).

«Решения Iomega/EMC для виртуализации в сегменте SMB» - Введенский Константин (старший эксперт по виртуализации, De Novo).

«Обзор VXLAN: как, зачем и почему» - Сергей Щадных (Микротест), Андрей Курочкин.

«-Резервируем небольшой ЦОД.

Дорого.

-Да ладно?!» - Владимир Ескин (Veeam)

«Veeam Backup расширяет горизонты…» - Евгений Киселев (преподаватель, Ciscotrain)

«Несколько слов о живых демонстрациях продуктов VMware» - Игорь Гиркин (Cisco)

“Интеграция физической и виртуальной сетевых инфраструктур”

воскресенье, 11 марта 2012 г.

HP ACU on ESXi

Инструкция по установке и использованию HP Array Configuration Utility на ESXi 4 и 5 - How to run the HP Online ACU CLI for Linux in ESXi.

суббота, 10 марта 2012 г.

Image builder, esxcli

Помните, я писал про Image Builder, средство изменения образов ESXi?

(К слову – как пользоваться Image Builder для интеграции обновлений в дистрибутив ESXi - Customize the VMware ESXi 5 installation media by adding the latest patches using Image Builder)

На эту же тему хочется пару вещей сказать.

У HP есть прямая ссылка на репозиторий своего ПО для ESXi - http://vibsdepot.hp.com. Это упростит добавление или обновление компонентов от HP.

Эту ссылку можно напрямую регистрировать как Software Depot при работе c Image Builder, так и добавлять ее в VMware Update Manager (http://vibsdepot.hp.com/index.xml).

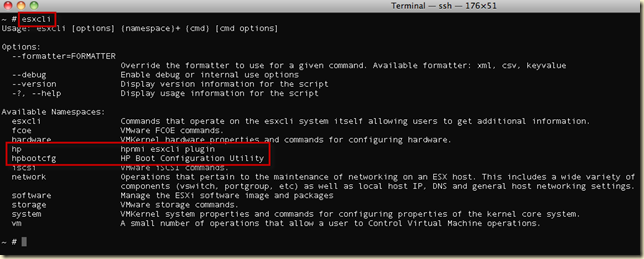

Второе – помните, я упоминал про esxcli – новую “командную строку” ESXi.

Еще одно ее преимущество – она расширяема. Примерно так:

Например, те из вас, кто использует ESXi с аддонами от HP (но HP все не ограничивается), могут обнаружить в пространстве имен (namespace) дополнительные, не входящие в стандартный ESXi.

Receive-Side Scaling

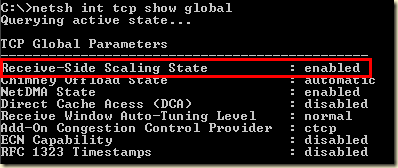

Еще в одной ветке на форуме VMware углядел интересную ссылку – Enable RSS (Receive Side Scaling) on Windows 2008 (R2) Virtual Machines.

Создали ВМ, дали ей два процессора, сетевую карту типа vmxnet3. Нагрузили ее сетевую подсистему, померяли нагрузку на процессоры. Увидели, что занят преимущественно только один процессор:

Проверили, включена ли технология Receive-Side Scaling для ОС. Включена:

Проверили, включен ли RSS для сетевой карты. Выключен:

После включения оба процессора стали обрабатывать сетевую нагрузку:

Мораль – включение RSS может дать прирост скорости сети..или избавить от лагов.

Интересно, есть ли противопоказания?

Почитать у MS - Receive-Side Scaling.

ESXi local raid performance

Интересный пост в одной из веток на официальном форуме VMware – Низкая производительность ESX на новых блейдах от HP на базе C3000 .

цитата:

Ну и в общем по теме, хочу поделитсья опытом, надеюсь кому-нибудь будет интересно.

Уже набралось энное количество опыта эксплуатации HP Smart Array контролеров для локальных датасторов на ESXi хостах. В основном это P410i и в 90% случаев там есть кэш (с батарейкой или флэшем)За время эксплуатации на разных дисках регулярно вижу в событиях хоста и датастора (в vSphere клиенте) события двух видов:

1. Время отклика на датасторе "таком то" возросло с тысяч микросекунд до сотен тысяч.....

2. Хост временно потерял доступ к датастору (следом за этим событием обычно идет сообщение что хост восстановил доступ к датастору).

В большинстве случаев такие события наблюдались уже длительное время и не вызывали проблем.

А вот на двух более мощных серверах, где много памяти (и соответственно виртуалок) начались были проблемы. В рабочее время, в пик нагрузки, события о потере хостом доступа к датастору появлялись все чаще, вплоть до 2 раз в минуту... и потом начинались реальные проблемы... все виртуалки начинали тормозить, и все пользователи жаловаться.

Все графики производительности, доступные у вмваре, вместо плавно изменяющихся линий превратились в "расческу"( Все показатели, и сеть, и диск, и время отклика диска, и утилизация процессора).

После всех разбирательств пришел к такому выводу.

Перешивка контроллеров до последней версии ничего не дала, ошибки так и продолжали сыпаться. Обновления прошивок на всем сервере и обновление гипервизора тоже не решило проблемы.

Проведя ряд тестов (с помощью IOmeter генерировал нагрузку) я прошелся по всем вариантам настройки контроллеров.

Вывод у меня такой - для высоконагруженных по дисковым операциям датасторов нельзя собирать Raid6 и Raid5 - эти варианты ожидаемо снижают производительность, а кроме того увеличивают потенциальную нагрузку (больше места - больше виртуалок)

По результатам тестов (я использовал прессеты от сюда: http://vmktree.org/iometer/ , наиболее показательным считаю второй тест60% случайно, 60% чтения - , его результаты и приведу)

Например на HP SmartArray p410i (прошивка 5.06 и 5.14) массив собирал из 8x600GbSAS10k дисков.

raid6 - ~1300 IOps

raid5 - ~1800 IOps

raid10 - ~3000 IOps

Так вот по поводу неочевидного результата.

Во время проведения нагрузочных тестов я мониторил возникающие события на хостах\датасторах. И результат такой - у вариантов с Raid5 и особенно уRaid6 под нагрузкой возникают оба описанных выше события (повышение времени отклика и потеря доступа к датастору). А вот Raid10 держит нагрузку лучше, там под нагрузкой очень редко проскакивают события о повышении времени отклика, но потери доступа не происходит.

Я в итоге понял так, что контроллеру не хватает вычислительной мощности под высокой нагрузкой на Raid6, и в итоге сам контроллер перестает отвечать хосту (на доли секунды). А хот сразу считает что датастор пропал (один единственный путь к датастору сдал нерабочим). Свои выводы я "передал руководству".... сказали что создадут тикеты в обоих техподдержках... но что-то уже месяц тихо.

Ни подтвердить ни опровергнуть свою гипотезу не могу, так что я переделал все на Raid10 и теперь у меня все ОК

thx mazday.

понедельник, 5 марта 2012 г.

VMUG 2012 Moscow

Коллеги, хочу сообщить хорошую новость.

30 марта мы планируем проводить встречу VMware User Group в Москве.

UPD.

Коллеги, открыта ссылка на регистрацию на московскую встречу сообщества VMware - тыц.

Смешно сказать, но большая кнопка Register Now пока не работает :-)

Пользуйтесь ссылкой Login to Begin Registration в нижней части страницы.

Мероприятие

неофициальное, ресурсов на его рекламу нет - поэтому рекомендую

сообщить о нем своим потенциально заинтересованным коллегам.

все вопросы - велкам мне. Mikhail.Mikheev@vm4.ru.

Напомню о чем речь - неофициальное мероприятие, предполагающее определенное количество интересных докладов, много обсуждений и офигенно интересное общение вне докладов.

Опыт предыдущих мероприятий показывает, что среди присутствующих обязательно отыщутся те, чей опыт будет интересен именно вам. Администраторы с опытом, инженеры, архитекторы, руководители ИТ - лично я каждый раз узнавал много нового :-).

Немного позже будет объявлена программа выступлений - сейчас проходят последние согласования.

Всех заинтересованных (а вам интересно, поверьте) я призываю:

- Освободить 30 марта от других дел.

- Дождаться начала регистрации (я сообщу чуть позже) - и после регистрации получить детальную организационную информацию.

Участие бесплатно, будет обед, ожидаются подарки и конкурсы с призами.

Раньше бывал заметный десант из других городов, если кто будет оформлять командировку - без проблем, поможем, печати поставим - но сказать об этом надо заранее. Говорить мне.

По тегу vmug доступна информация о том что бывало раньше.

Кстати, если вам интересно поделиться своим опытом в эксплуатации виртуальной инфраструктуры в виде доклада на vmug - смело пишите, нам есть о чем пообщаться.

mikhail.mikheev@vm4.ru.

воскресенье, 4 марта 2012 г.

memory, tps, large pages

Памятка - информация о памяти, и о TPS в частности.

Memory management - как и что в принципе с оперативкой происходит.

Как сэкономить память в своей виртуальной инфраструктуре - влияние отключения больших страниц на эффективность дедупликации ОЗУ - TPS vs. Large Pages in real life. Данные с боевой инфраструктуры.

Как выключить использование больших страниц для повышения эффективности TPS:.

Сервер -> Configuration -> Advanced Settings -> Mem -> AllocGuestLargePages -> поменять 1 на 0. После этого ВМ или перезагрузить, или мигрировать с этого сервера и вернуть обратно.

Дальнейшие изыскания на ту же тему, данные с тестового стенда - Trasparent Memory page Sharing + Large Pages + Address Space Layout Randomization.

Так как отключение больших страниц - одна из очень немногих настроек, эффект от которой просто шикарен, разумеется хочется знать "А в чем подвох?". Некоторые изыскания по этому поводу тут - boot storm. TPS vs. hardware MMU.

ESXi patch install–установка обновлений на ESXi из командной строки и PowerShell

Чтобы Установить обновление на ESXi из командной строки надо скачать обновление и выбрать какой командной строкой его ставить.

Загрузить файл обновления следует отсюда – http://www.vmware.com/patchmgr/download.portal.

Local CLI

Сначала скопировать файл с обновлением (например ESXi500-201112001.zip) на хранилище ESXi. Можно через встроенный файловый менеджер Browse Datastore.Затем команда

esxcli software vib install --depot=/vmfs/volumes/SharedLUN1/ESXi500-201112001.zip

Затем сервер надо будет перезагрузить и проверить что номер сборки (Build) поменялся.

PowerCLI

В случае PowerCLI два варианта:

спецкомандлет или esxcli

Сначала спецкомандлет:

Архив с обновлением следует распаковать, каталог с распакованным обновлением следует копировать на хранилище. Затем:

Connect-VIServer esxi01.vm4ru.local -User root -Password P@ssw0rd Get-VMHost esxi01.vm4ru.local | Set-VMHost -State Maintenance Get-VMHost esxi01.vm4ru.local | Install-VMHostPatch -Hostpath "/vmfs/volumes/datastore1/ESXi500-201112001/metadata.zip" Restart-VMHost esxi01.vm4ru.local -Confirm:$false

Однако этот командлет носит статус экспериментального. Альтернатива ему – использовать ESXCLI. Эта оболочка должна в будущем стать унифицированным интерфейсом в любой командной строке.

Однако я не понял как.

Зато узнал много полезного про esxcli в PowerCLI из документа http://communities.vmware.com/docs/DOC-14148.

Кратко:

Чтобы в PowerCLI использовать esxcli надо подключаться напрямую к хостам, не к vCenter.

Connect-VIServer <esxi>Вот так инициируется esxcli

$esxcli = Get-esxcli <esxi01.vm4ru.local>Вот так можно спускаться по “неймспейсам”, пространству имен

$esxcli | Get-MemberЕсли какое-то пространство имен нас заинтересовало, можно по нему посмотреть помощь

$esxcli.что-то.что-то.help()Если в этом пространстве имен заинтересовал какой-то метод – можно по нему посмотреть помощь

$esxcli.что-то.что-то.help(метод)Если для метода непонятны параметры, по ним также можно посмотреть помощь:

$esxcli.что-то.что-то.help(метод).Param[0]и т.д.

$esxcli.что-то.что-то.help(метод).Param[1]

Однако когда я смотрю помощь по методу установки:

PS C:\> $esxcli.software.vib.help("install")

=======================================================================================================================

vim.EsxCLI.software.vib.install

-----------------------------------------------------------------------------------------------------------------------

Installs VIB packages from a URL or depot. VIBs may be installed, upgraded, or downgraded. WARNING: If your installation requires a reboot, you need to disable HA first.

Param

-----------------------------------------------------------------------------------------------------------------------

- depot | Specifies full remote URLs of the depot index.xml or server file path pointing to an offline bundle .zip file.

- dry-run | Performs a dry-run only. Report the VIB-level operations that would be performed, but do not change anything in the system.

- force | Bypasses checks for package dependencies, conflicts, obsolescence, and acceptance levels. Reallynot recommended unless you know what you are doing. Use of this option will result in a warningbeing displayed in the vSphere Client.

- maintenance-mode | Pretends that maintenance mode is in effect. Otherwise, installation will stop for live installs that require maintenance mode. This flag has no effect for reboot required remediations.

- no-live-install | Forces an install to /altbootbank even if the VIBs are eligible for live installation or removal. Will cause installation to be skipped on PXE-booted hosts.

- no-sig-check | Bypasses acceptance level verification, including signing. Use of this option poses a large security risk and will result in a SECURITY ALERT warning being displayed in the vSphere Client.

- proxy | Specifies a proxy server to use for HTTP, FTP, and HTTPS connections. The format is proxy-url:po rt.

- vibname | Specifies VIBs from a depot, using one of the following forms: name, name:version, vendor:name, or vendor:name:version.

- viburl | Specifies one or more URLs to VIB packages to install. http:, https:, ftp:, and file: are all supported.

Я не понимаю как этим пользоваться.

По идее, должно быть что-то вроде такого:

$esxcli.software.vib.install(vmfs/volumes/datastore1,$false,$false,$false,$false,$false,$null,ESXi500-201112001.zip,file:/vmfs/volumes/datastore1ESXi500-201112001.zip)но меня смущают первый и последние два параметра.

Так что если кто выскажет дельную мысль – буду благодарен.

воскресенье, 26 февраля 2012 г.

vBenchmark

На сайте экспериментальных продуктов VMware появился новый Virtual Appliance под названием vBenchmark.

Судя по официальному описанию она умеет вот что:

- считать эффективность (Efficiency). Такие вещи как сколько физической памяти было сэкономлено виртуализацией?

- Operational Agility: сколько времени в среднем занимает развертывание ВМ?

- Quality of Service: как много простоев было в инфраструктуре?

Можно:

- Собирать данные с нескольких vCenter;

- Отдельные хосты и кластеры можно исключать из анализа;

- Можно экспортировать данные – для анализа потом и сравнения с результатами за попозже;

После импорта этой ВМ убеждаемся, что она получила IP (или задаем с консоли ВМ руками), и обращаемся на этот IP браузером.

(у меня не получилось по https, только по http).

Указываем адрес\адреса наших vCenter и учетные записи для доступа. Указываем количество месяцев, анализ данных за которые нас интересует.

И видим красивые картинки:

Хотел наделать картинки, но на моей демо-лабе все цифирки суперскромные, неинтересно. Так что ограничусь первой обзорной, на остальных вкладках каждое значение раскрывается более подробно.

Отдельной фишкой является возможность в два клика поделиться своими данными c VMware, а в ответ получить доступ к этим собранным со всех данным. После манипуляций на вкладке Shares нам становятся доступны данные таких же как мы:

Обратите внимание на верхний блок (выделен и со стрелочкой) – при выгрузке своих данных мы указываем индустрию нашей компании и размер – а затем можем сравнить свои данные с другими компаниями в своей категории.

суббота, 25 февраля 2012 г.

четверг, 16 февраля 2012 г.

cisco nexus 1000v Update

Из переписки:

Михаил, привет.

Хочу поделиться граблями по поводу cisco nexus 1000v для vSphere.

При проведении обновления с с версии 4.0 sv1(3b) до версии 4.2 (любой редакции) требуется перенастройка на nexuss1kv интерфейса control0 с l2 на маршрутизацию l3. Это дает определённые бонусы, которые в инструкции указаны.

Сама процедура переключения l2 на l3 тривиальна и не вызывает никаких прерываний в сети или сбоев, достаточно сделать её по инструкции.

Но там оказался подводный камень - в момент переключения nexus 1000v VSM модуль может потерять связь до VEM модулей, которые установлены на серверах esx и это в инструкции не указано. А следовательно любой vMotion виртуальных машин, который произойдет на серверах после потери связи между vsm и vem модулями оставит мигрируемые виртуальные без всякой связи с сетью.

В консоли vsm эти порты будут выглядеть как status down, а в vcenter в интерфейсе dVS они будут выглядеть status blocked и vlan 1.

То есть на момент обновления nexus 1000v лучше DRS перевести в Manual режим, чтобы избежать ситуации с пропавшей сетью внутри виртуалок.

А после переключения интерфейся control0 с l2 на l3 в консоли vsm набрать:

show module

и проверить показывает ли он там vem модули, если да, то можно смело продолжать действия по инструкции. Если нет, то убедитесь, что не произойдет vMotion между серверами или переместить все виртуалки на серверы без nexus 1000v, а потом продолжать обновление

thx Волнянский Виталий

вторник, 14 февраля 2012 г.

my new job

Я устал. Я ухожу.

Коллеги, совсем недавно я прочитал свой очередной курс, и все идет к тому что он был последний в моей практике.

Я не смог удержаться от фразы в заголовке, но эта так, очередная попытка пошутить.

На самом деле я полон сил и энергии, и решил уйти из преподавания для реализации этого добра.

Теперь адрес моей корпоративной почты заканчивается на @vmware.com.

Так что не удивляйтесь тому, что посты станут появляться реже – свободного времени теперь будет меньше.

На письма по адресу mikhail.mikheev@vm4.ru буду стараться отвечать, как и раньше – но будьте готовы к задержкам.

воскресенье, 12 февраля 2012 г.

posh + vCenter Alarms

Чего-то у меня не получается выполнить posh скрипт как реакцию alarm в vCenter.

Кто-нибудь делал такое?

сделал файл a.bat, его запуск прописал в alarm.

В самом батнике:

%SystemRoot%\system32\windowspowershell\v1.0\powershell.exe -psc "C:\Program Files (x86)\VMware\Infrastructure\vSphere PowerCLI\vim.psc1" -command "c:\test_vc_alarm-start.ps1"

четверг, 9 февраля 2012 г.

Auto Deploy GUI

Помните я как-то писал про VMware Auto Deploy?

Это сервер PXE-загрузки ESXi.

Хорошая штука, но немного огорчали две вещи:

Настройка Auto Deploy только из командной строки PowerShell, плюс тоже только через posh можно использовать Image Builder – инструмент изменения образа ESXi. С помощью Image Builder можно собирать разные образы (с разным набором драйверов, в первую очередь) , регистрировать их на Auto Deploy и затем на разные сервера назначать эти разные образы.

Второе что немного огорчало – это отсутствие средств резервирования Auto Deploy. Сервер, с которого загружаются десятки и сотни ESXi слегка, хм, сыкотно оставлять в единственном экземпляре.

Только что углядел на сайте экспериментальных продуктов VMware о появлении GUI для Auto Delpoy, в виде, ура ура, плагина к клиенту vSphere.

Судя по прилагающемуся pdf, в этом плагине реализован полный функционал – и по сборке образа, и по регистрации его на Auto Deploy.

Судя по инструкции и скриншотам в ней – отличная штука!!!

Жаль я сам сейчас в деле не могу попробовать.

Но вот про отказоустойивость мне пока не совсем понятно.

Теоретически, если использовать Windows-версию AutoDeploy и Windows-версию vCenter, то их можно поставить на одной машине (это даже рекомендуется в документации). И если настроить vCenter Heartbeat – будет ли он защищать еще и AutoDeploy? Afaik, heartbeat делает репликацию, в т.ч. на уровне файлов – может быть и будет тогда защищать AutoDeploy?

может быть всюду использовать EFI?

В пятом ESXi можно вместо BIOS использовать EFI.

Насколько я понимаю, это надо делать тогда, когда к ВМ хотим подключить диск более 2 Тб.

UPD. тут подсказывают что EFI необходим если загрузиться хотим с диска > 2Тб.

А противопоказания какие-нибудь есть?

вторник, 7 февраля 2012 г.

VMware tools Update without reboot

Обновление VMware Tools без немедленной перезагрузки.

1) на вкладке Virtual Machines выбрать требуемые виртуалки, правый клик -> Guest -> Install\Upgrade VMware tools.

Выбрать Automatiс Tools Upgrade

В поле Advanced Options вбиваем

/S /v “/qn REBOOT=R”

2) PowerCLI

Get-VM <выборка из одной или нескольких ВМ> | Update-Tools -NoReboot

3) VUM

есть такая кнопка - VMware Tools upgrade settings. Вроде как с ее помощью можно указать запускать установку новой версии при перезагрузке\выключении ВМ.

То же самое указывается если нажать remediate.

понедельник, 6 февраля 2012 г.

схлопывание тонких дисков

Игрался полвечера с разными случаями - но похоже старый способ "схлопывания" тонких дисков через sdelete и Storage vMotion не работает.

UPD.

Что делал:

- добавил к ВМ два тонких диска, записал файлов внутрь чтобы они выросли, удалил эти файлы.

- натравил sdelete с ключами -с и -z - один на один диск, другой на другой.

- начал по разному перемещать эти диски

- переносить между хранилищами на схд и локальным диском. не схлопнулось.

- переносить между VMFS 5 и VMFS 3 (с блоком = 4 и 8 МБ). не схлопнулось.

- якобы отключал оптимизированный механизм копирования через vsish set /config/VMFS3/intOpts/EnableDataMovement 0. переносил пару раз - не схлопнулось.

- натравливал vmkfstools -K. не помогло. мигрировал после этого - не помогло.

- делал клон этой ВМ.не схлопнулось.

Идеи?

USB over IP решения для ВМ на ESXi

Памятка про USB:

Хотя подключить к ВМ можно USB устройство и хоста и клиента, для постоянно подключенных устройств на голову удобнее пользоваться USB-over-IP решениями.

Популярная железка - Digi AnywhereUSB, Network-attached USB hubs.

Отзыв, см. камменты -USB over IP и VMware ESXi.

Программные решения:

Проброс USB в виртуальные машины.

Использование бесплатного пакета USBIP для проброса USB внутрь виртуальных машин.

Если кто использует не упомянутые железные или программные решения - буду благодарен подсказкам.

UPD. Поделились опытом:

Для проброса USB используем http://www.seh-technology.com/

Ed.

ESXi backup PowerCLI - GUI

Писал на днях про простенький скрипт для бекапа конфигурации ESXi.

А на vmind.ru углядел про GUI для этого же, притом то же на posh. (а сам я так и не смог овладеть джедайством создания оконных утилит на PowerShell :( )

ESXi 5.0 Host Backup & Restore GUI Utility (PowerCLI based).

воскресенье, 5 февраля 2012 г.

ESXi backup PowerCLI

Самое самое важное, простое и нужное использование PowerCLI:

Connect-VIServer vcenter -User administrator -Password password Get-VMHost | get-VMHostFirmware -BackupConfiguration -DestinationPath d:\esxibackup

Теперь в каталоге d:\esxibackup (он должен быть создан заранее) у вас появляются резервные копии конфигурации ESXi.

Если выполнить скрипт так как он приведен – всех ESXi в том vCenter, куда мы подключились в этой posh-сессии

Восстановить конфигурацию можно вот так:

$esxi = get-vmhost esxi01 Set-VMHost $ESXi.Name -State 'maintenance' Set-VMHostFirmware -vmhost $ESXi -Restore -SourcePath “D:\temp\esxibackup\” -HostUser root –HostPassword password

Если в указанном каталоге бекапы нескольких серверов, то скрипт выберет нужный по имени.

Если изначально сделать выборку не одного хоста, а нескольких (или всех) – восстановит конфиг на всех.

UPD. Есть и GUI для такого скрипта:

суббота, 4 февраля 2012 г.

ESXi 5–новое в cli

Кто любит (или нужда заставляет) покопаться в командной строке ESXi – очень интересные ссылки:

RDM–> vmdk

Проверил на пятерке старый трюк по превращению RDM в vmdk:

К ВМ подключен LUN как RDM.

В каталоге ВМ появились файлы vm.vmdk и vm-rdm.vmdk. Реальный размер последнего (смотрелся командной du -h) = 0.

Теперь делаем svMotion.

Ничего не поменялось.

Теперь опять делаем svMotion, но явно указываем тип диска (не “same as source, a thin\thick”).

Содержимое RDM было скопировано в vmdk файл, LUN теперь не подключен к этой ВМ, ее диском является этот новый файл.

Как и раньше.

Мораль – если надо RDM LUN перенести в vmdk – то Storage vMotion поможет.

Но если этого не надо – то при svMotion ВМ с RDM LUN’ом надо быть очень внимательным – если явно указать тип диска, то он перенесется в vmdk.

Верно только для Virtual RDM, для Physical RDM это не работает.

UPD. В комментариях подсказали ссылку где написано что перенос в vmdk заработает и для pRDM, если мигрировать на другое хранилище выключенную ВМ.

UPD2. Полное описания разных случаев доступно угадайте где - http://kb.vmware.com/kb/1005241

troubleshooting

Памятка. Инструкции для решения проблем (Resolution Path KB articles):

- Troubleshooting ThinApp Issues

- Troubleshooting Storage Issues

- vSphere Install Troubleshooting

- Vsphere Licensing Troubleshooting

- Resolution Paths for VDR Issues

- Resolution Paths for VMware Site Recovery Manager Issues

- Unpresenting LUNs from ESX/ESXi 4.x

- Resolution Paths for OS Issues

- Resolution Paths for Converter Issues

- Resolution Paths for Lab Manager Issues

- vSphere Troubleshooting Network Issues

- VMware View Resolution Paths

- vSphere Troubleshooting Management Issues

- VMware Update Manager Resolution Paths

- VMware Fusion Resolution Paths

- VMware Workstation Resolution Path

- Fault Resolution Paths

- Capacity Planner Resolution Paths

пятница, 3 февраля 2012 г.

http://www.vmworld5.ru

В нашем полку прибыло - http://www.vmworld5.ru/

Мир Виртуализации

Блог технического характера про виртуализацию от VMware

четверг, 2 февраля 2012 г.

ESXi 5 snmp

Как настроить snmp на ESXi версии 5 при помощи PowerCLI:

# подключаемся к vCenter

Connect-VIServer vcenter –User <юзер> –Password <пароль>

# заносим в переменную все наши сервера ESXi

$esxis = Get-VMHost

# отключаемся от vCenter

disConnect-VIServer vcenter -Confirm:$false

# начинаем цикл – перебираем по одному сервера из списка

# дело в том, что эти команды вроде как работают только

# при прямом подключении, без vCenter

foreach ($esxi in $esxis) {

# подключаемся к текущему серверу

Connect-VIServer $esxi -user root –Password <пароль рута>

# заносим в переменную его настройки SNMP

$hostsnmp = Get-VMHostSnmp

# если захотим посмотреть настройки, то следующие три строки комментируем, и расскоментируем эту

# Test-VMHostSnmp -HostSnmp $Hostsnmp

# включаем snmp

Set-VMHostSnmp -HostSnmp $hostsnmp -Enabled:$true #-WhatIf

# указываем community, с которым ESXi будет получать команды snmp

Set-VMHostSnmp -HostSnmp $hostsnmp -ReadOnlyCommunity 'vsphererocommunity' #-WhatIf

# указываем на какой сервер и с каким community слать trap

Set-VMHostSnmp -HostSnmp $hostsnmp -AddTarget -TargetHost "192.168.22.250" -TargetCommunity "monitoring" #-WhatIf;

# отключаемся от текущего сервера

disConnect-VIServer $esxi -Confirm:$false

}

скрипт набросан за десяток минут и не отлажен – зато работает.

Охота посмотреть что приходит? Я пользуюсь SNMP Trap Reciever (кстати, кто знает аналоги, чтобы mib не приходилось по одному загружать\удалять как здесь?)

MIB для vSphere 5 – http://downloads.vmware.com/d/details/snmp_mibs/dHRAYnQlKmhiZHAlJQ==.

среда, 1 февраля 2012 г.

vSphere 5 SSL

Памятка про замену сертификатов ssl.

Официальная дока по vSphere 5 - vSphere Security –> Encryption and Security Certificates for ESXi and vCenter Server.

Change the Update Manger SSL Certificate - vSphere Update Manager 5.0 Documentation > Reconfiguring VMware vSphere Update Manager.

Для веб-клиента - Want to use a self signed SSL certificate with the vSphere Web Client?

Замена SSL сертификата на VMware vCenter Server Appliance (VCSA).

По-русски

SSL сертификаты в ESXi | VMware.

Замена сертификатов на vSphere 4.1.

Замена сертификатов на службах VMware vCenter Server 4.0.

На всякий случай

Replace SSL Certificates: Replace vCenter Server SSL Certificates

Replacing vSphere SSL Certificates

вторник, 31 января 2012 г.

the book

делаю тут предметный указатель. Дурацкий вопрос, но вдруг не очень дурацкий :-) : какие вещи в предметный указатель стоит добавить? Дружно вспоминаем и отписываемся в комментарии!!

hp eva 6500

...