делаю тут предметный указатель. Дурацкий вопрос, но вдруг не очень дурацкий :-) : какие вещи в предметный указатель стоит добавить? Дружно вспоминаем и отписываемся в комментарии!!

вторник, 31 января 2012 г.

the book

hp eva 6500

...

понедельник, 30 января 2012 г.

help

Стараюсь из блога не делать дневник "на что гляжу о том пою", но вот это, проскочившее сегодня в рсс, очень очень порадовало:

Простая, на первый взгляд, просьба «Помогите!» может иметь очень даже разные смыслы.

Первый — самый частый: «Сделайте за меня».

Второй, такой же частый: «Дайте мне».

Только третий, и отнюдь не частый: «Я делаю — прошу мне подсобить».

И уж самый редкий — четвертый: «Научите меня, как делать самому».

Поэтому если хотите поучаствовать в помощи страждущим, сперва разберитесь: чего же из вышеперечисленного они от вас хотят?

воскресенье, 29 января 2012 г.

vSphere 5 Licenses

Памятка про лицензирование vSphere 5.

Дорогие лицензии:

Покупаются на процессор, каждая штука лицензии дает право на 32\64\96 Гб vRAM.vRAM - в общий пул, из которого нельзя вылезать в среднем за год. Ограничение только юридическое.

Дешевые лицензии - Essentials и Essentials Plus. Вторая умеет HA и Data Recovery. Одна штука такой лицензии дает право на ESXi для 3х двухпроцеесорных серверов и vCenter Foundation. vRAM - 192 ГБ. Ограничение vRAM техническое.

Документ с подробностями про лицензирование - VMware vSphere 5 Licensing, Pricing and Packaging.

ESXi c бесплатной лицензией не может управляться через vCenter, 32 Гб vRAM.

Что делать если есть купленные лицензии на vSphere 4, а нужны на vSphere 5

или

есть купленные лицензии на vSphere 5, а нужны на vSphere 4.

Upgrading and downgrading VMware product licenses.

суббота, 28 января 2012 г.

Storwize V7000 + ESX 5.0 iSCSI LUN ALUA

Из переписки.

Со мной и с вами поделились информацией:

Итак, изначально настроены 2 target на Storwize, в список Storage adapter добавлен vmhba iSCSI адаптер (vmhba34).

На двух виртуальных коммутаторах созданы интерфейсы vmk1(iSCSI) и vmk2(iscsi-2)

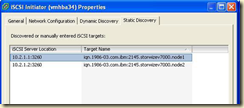

В свойствах iSCSI initiator оба интерфейсы добавлены на вкладке Vmkernel Port Binding

Поскольку интерфейс vmk2 мы добавили после того, как были добавлены LUN (у нас их 2), то видим такую картину:

2 адаптера, 2 контроллера, 2 LUN. То есть должно быть 4 пути к каждому LUN, но их 6 и в сумме получается 12 к двум LUN.

Такое же поведение видно обсуждают в комментах здесь: http://www.yellow-bricks.com/2009/03/18/iscsi-multipathing-with-esxcliexploring-the-next-version-of-esx/

При перезагрузке ESX всё встает на свои места и мы видим, как положено, 4 пути к LUN, суммарно 8.

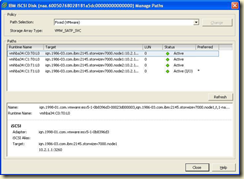

Далее заходим в свойства datastore, Manage Path:

Видим, что SATP плагин для Storwize по умолчанию VMW_SATP_SVC и политика Fixed. При этом если нагрузить массив, увидим следующее:

Трафик идет через vmnic1. Изменим политику на Round Robin.

Посмотрим интерфейсы

Трафик идет через оба vmnic к обоим контроллерам Storwize, что можно увидеть в интерфейсе управления.

Контроллер 1 (node1):

И контроллер 2 (node2):

Видно, что трафик между iSCSI интерфейсами storwize разделен поровну.

В данном случае, запросы отправляются к 2 контроллерам и по оптимальному пути и по неоптимальному. Интересно всё таки включить ALUA, так как массив этот режим поддерживает.

Открываем VMware HCL, и видим, что тестированная конфигурация для Storwize V7000 v6.3 является 8G FC-SVD-FC, SATP плагин VMW_SATP_SVC и политика VMW_PSP_FIXED.

Пренебрежем этим, поскольку у нас даже не FC, а iSCSI и проведем эксперимент. Найдем идентификатор нашего LUN: na.6005.........000. Далее заменим default SATP плагин для этого LUN на VMW_SATP_ALUA

Перегрузим ESX.

После перезагрузки идем в свойства нашего datastore на вкладку Manage Path:

Видим, что SATP плагин изменился на VMW_SATP_ALUA. Но пока что политика Fixed.

Трафик на интерфейсах:

Трафик идет через vmnic1.

Изменим на Round Robin:

Видим, что при политике RR и плагине ALUA активны только 2 оптимальных пути к контроллеру 2.

Трафик на интерфейсах:

Трафик идет через оба интерфейса.

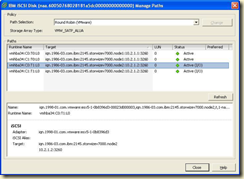

Посмотрим на интерфейс управления Storwize

Контроллер 1(node1):

Запросов к контроллеру нет, поскольку LUN принадлежит контроллеру 2.

Контроллер 2 (node2)

Как видно, запросы обрабатывает контроллер 2.

Возможно, что-то сделал не совсем верно, просьба меня поправить. Если нужно что-то проверить и потестировать, пока Storwize в моем распоряжении – готов помочь.

Thx Andrey Gritsay

понедельник, 23 января 2012 г.

к вопросу о резервном копировании ESXi с бесплатной лицензией

Из переписки:

Pavel Alexei:

Добрый день

Читаю уже давно Ваш блог.

Давно бьюсь с задачей backup free версии ESXi, которое бы воспринимало thin файлы. Все коммерческие продукты backup не работают с free версией ESXi, так как в ней отсутствует vStorage APIs for Data Protection.

К сожалению единственное на текущий момент решение, которое я нашел, это ghettoVCB, причем первой версии, которая работает как скрипт на консоли ESXi. Но и тут есть подвох, не могу «вытащить» куда-то на сторону thin vmdk файлы. Даже если монтировать в качестве внешнего datastore NFS шару, то и там -flat.vmdk в виде sparse файлов лежат. А хочется иметь возможность положить куда-то «далеко». Если NFS от линукс, то можно там, на месте, это зажать при помощи tar -S, тогда tar понимает что это sparse файл, и получаем то что хочется. Этот «маленький» tar можно переложить куда хочется.

НО, хочется большего :-) Хочется нормальный GNU tar под ESXi, чтоб делать все там, на месте. Есть где-то «нормальные» портированные gnu утилиты под ESXi?

я:

приветствую.

мне такого не встречалось.

впрочем, я и не искал - не вставало такой задачи.

Pavel Alexei:

По ходу я нашел. Совсем случайно

http://ftp.cica.es/mirrors/Linux/pramberger.at/vmware/esx4i/IPKGS/

правда установить через ipk не получилось, но зато смог вытащить, ipk это tar.gz.

Теперь могу

tar cvfzS XXX.tgz XXX.vmdk XXX-flat.vmdk

можно свободно переносить XXXX.tgz. Этот tar sparse он точно понимает, из 4GB «пустого» vmdk файла она создала 10KB tgz, хотя ls показывает 4GB

Тут же вижу есть rsync, понимающий sparse файлы.

И еще coreutils с кучей полезностей.

Может еще пригодиться, чтоб не мучать по чем зря ssh/scp - ftp клиент для vmware (ftpput/ftpget)

block size

Тут был текст про размер блока IO. При попытке отредактировать его с помощью клиента текст пропал при падении клиента. Но оно и к лучшему - я ошибся, не надо было писать пост в час ночи :-)

уточню вопрос дополнительно, обновлю пост.

EVA P6500 на 100HDD

Из переписки:

у меня приехала EVA P6500 на 100HDD 600 10K и два хоста bl620g7 ESX5 Ent.

если есть время и желание, то в ближайшие пару дней я могу что-нить погонять...

у меня одна дисковая группа на 100 дисков.

поверх них можно нарезать разных Virtual Disks с разными Vraid'ами.

..

Вот что у меня получилось при тестирование io-analyzer'ом

Дополнительные материалы тестирования.

Есть возможность померять и в других конфигурациях, если есть идеи - предлагайте.

пятница, 13 января 2012 г.

В нашем полку прибыло - http://vladek.net

Новый, потенциально интересный блог от Владислава Кирилина. Пост – про зонирование / FibreChannel Zoning.

вторник, 10 января 2012 г.

Commands to monitor snapshot deletion

Как многие знают, снапшоты - штука такая, неоднозначная. Вот на русскоязычной ветке офффорума не напрягаясь можно найти описания случаев со всякими чудесами. И чудесами плохими.

Одна из характерных ситуаций - многочасовое удаление больших снапшотов. Ситуация неприятна тем, что ВМ заблокирована, индикации нет (часто большую часть времени прогрес бар находится в состоянии 99%), что происходит и происходит ли что-то вообще непонятно.

Углядел новую для себя статью базы знаний - Commands to monitor snapshot deletion. Правда, пятый ESXi не заявлен в списке продуктов, для которых это предназначено - так что надо будет проверить.

UPD. Альтернатива -Мониторим процесс удаления снапшот(а/ов) из командной строки.

ESXi 5 partition table

Хороший пост про структуру разделов на системном диске ESXi - Разделы VMware ESXi 5.0.

Полезные вещи на эту тему:

Creating a persistent scratch location for ESX - http://kb.vmware.com/kb/1033696.

если локальный VMFS был, но его удалили - то восстановить скорее всего получится только переустановкой ESXi - http://kb.vmware.com/kb/2000454. Кстати интересно - а подхватятся ли конфиги при переустановке той же версии поверх?

partedUtil - утилита для работы с разделами в локальной командной строке ESXi 5. Как с ней обращаться - http://kb.vmware.com/kb/1036609.

желательно настроить сбор логов ESXi на отдельной системе - http://www.vm4.ru/2011/10/vmware-syslog-collector.html. Или хотя бы перенаправить локальные логи на какой-то нелокальный VMFS - чтобы когда сервере станет нерабочим (тьфу-тьфу) - были шансы найти в логах "а что и почему?".

еще сюда же http://kb.vmware.com/kb/2003322.

PCoIP Log Viewer 2.0

Попробовал в деле новую утилиту - PCoIP Log Viewer 2.0.

Прикольно.

На машине где установлена java устанавливаем ее, запускаем.

В меню File –> New Connection указываем адрес виртуального десктопа – той ВМ, куда подключается пользователь.

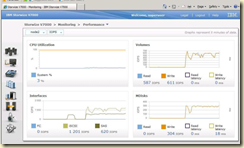

После авторизации видим красивые графики:

в данный момент на этом десктопе имитируется офисная нагрузка при помощи VDI Sizing tool, о которой я уже упоминал в недавнем посте.

Как видно, при работе с офисном пакете нагрузка на сеть крайне мала.

Коллеги, было бы интересно узнать – а что показывает эта утилита для ваших пользователей, с той или иной рабочей нагрузкой?

получение инфы о настройка Distributed vSwitch

Углядел перловый скрипт, который запускается локально на хосте, для сбора и вывода данных о распределенном коммутаторе – Retrieving Information from a Distributed vSwitch.

Для конфигурирования dvSwitch из командной строки есть, неофициальные правда но вполне рабочие, модули PowerShell – PowerCLI + Distributed switch.