Итак, коллеги, большая часть нового про большое обновление вСферы уже известны.

Я предложу свою подборку.

Из общего: названия ESX и ESXi теперь слегка отходят на второй план, а на первый план выходит vSphere Hypervisor. Кстати, теперь таково имя собственное “ESXi с бесплатной лицензией”.

Т.е. теперь есть vSphere = vSphere Hypervisor + vCenter Server. А то, что в рамках коммерческой лицензии “vSphere Hypervisor” это ESX или ESXi, это уже нюансы.

Читать далее.

ESX ESXi vCenter

- для ESXi теперь возможна установка с файлом ответов.

- поддержка развертывания ESXi по PXE.

- полная поддержка boot-from-SAN для ESXi, с FC, iSCSI и FCoE.

- vCenter Server требует обязательно

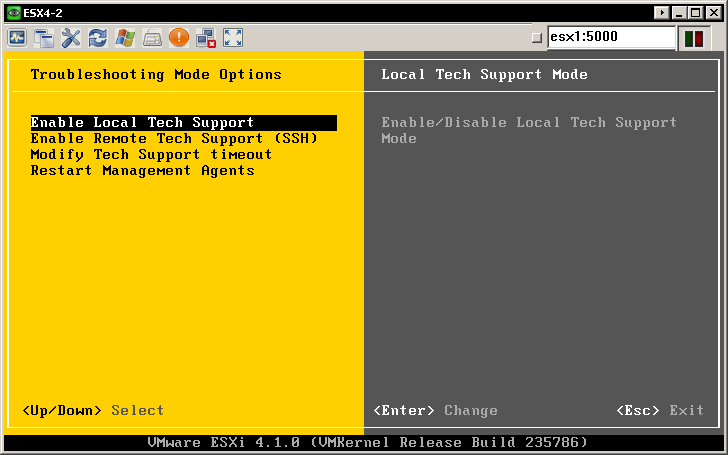

64-битной ОС для себя. - неподдерживаемая локальная консоль и SSH теперь включаются из локального меню ESXi

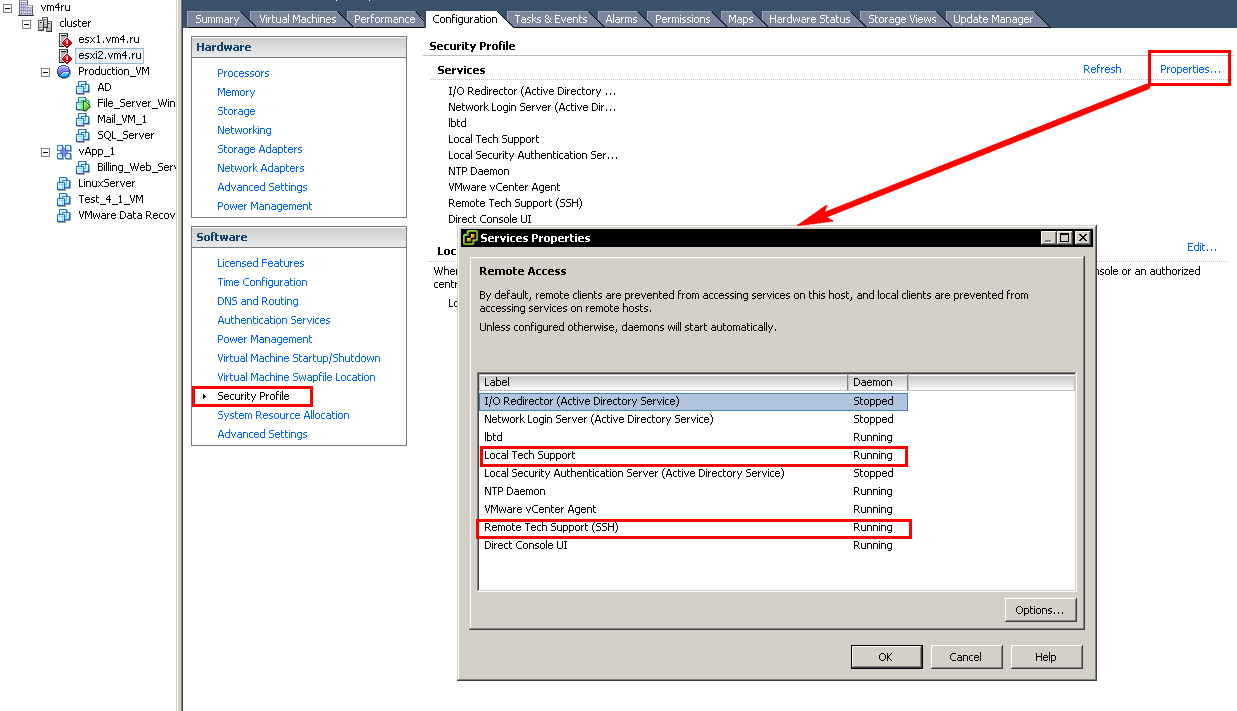

и даже из клиента vSphere

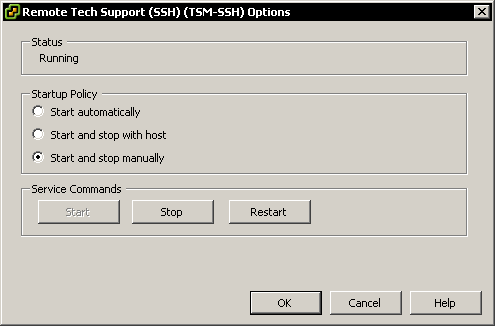

а по нажатию Options – настройки автостарта службы сервера SSH.

все операции через локальный TechSupport режим попадают в syslog.

- клиент vSphere теперь не входит в установленный ESX(i). Ссылка на web-странице установленного ESX(i) теперь ведет на сайт VMware. Впрочем, он продолжает поставляться с vCenter, и как и раньше его можно скачать отдельным дистрибутивом.

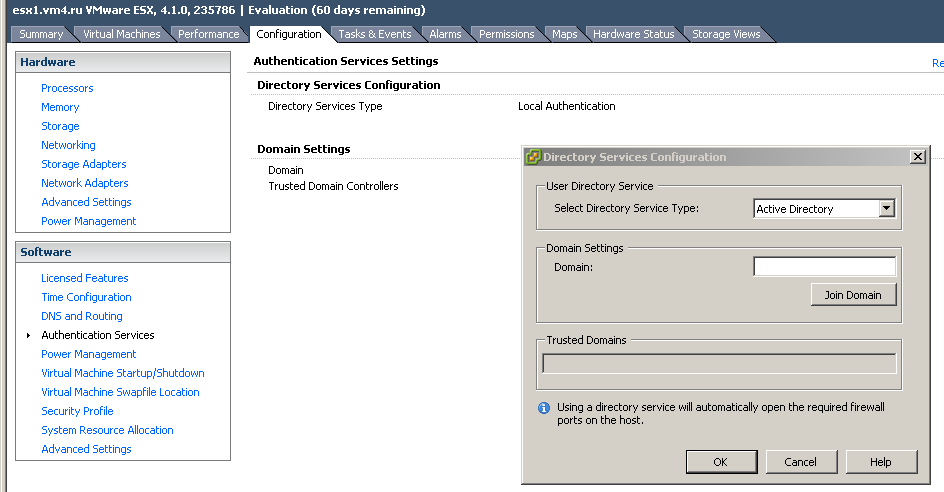

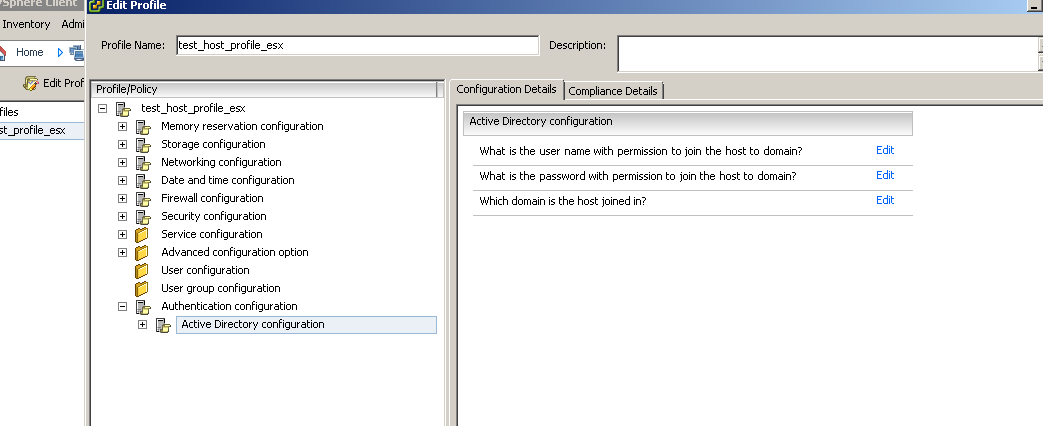

- аутентификация на хостах учетками из AD —

настройка этого, в том числе, через Host Profiles

Админский доступ имеют члены группы “ESX Admins”.

- появился счетчик «Power» для серверов и ВМ. Если ESX(i) смог через IPMI получить информацию о потреблении питания, то нам покажут эти данные.

СХД

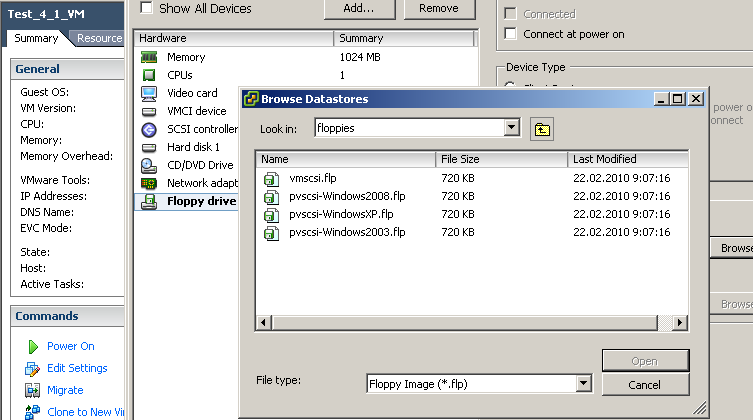

- появился драйвер PVSCSI для WinXP — образ флопика с ним лежит там же, где и обычно. Так же поддерживаются Win7, Vista.

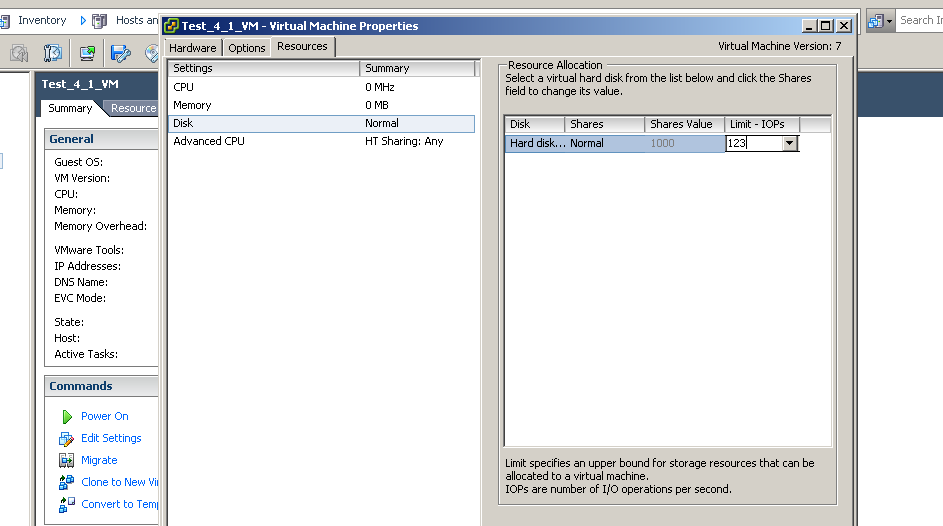

- самая ожидаемая фича — контроль ввода вывода!

лимит по операциям ввода вывода на диске! Для каждой ВМ.

Раньше:

Сейчас:

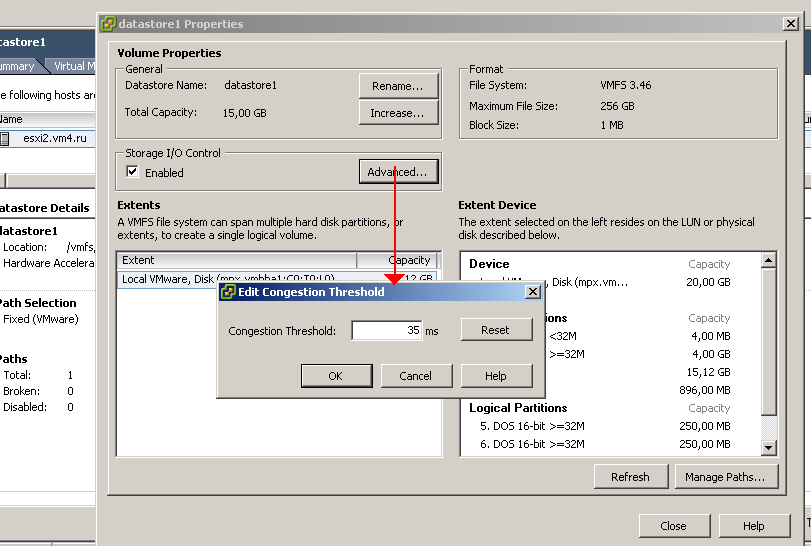

Чтобы этим воспользоваться, следует включить контроль задержек (Latency) для конкретного хранилища

тут мы указываем, при какой величине latency ESX(i) начинают использовать shares по дискам.

Включается, и значение latency указывается для каждого хранилища независимо.

Limit, вроде как, работает всегда.

За контроль отвечает vCenter, поэтому на хранилище должны лежать ВМ с хостов, управляемые одним vCenter.

Для NFS это не работает.

Для хранилищ с extent это не работает.

Если у кого “Automated tiered storage”, то для таких стораджей эта штука пока не поддерживается.

Видео:

Можно настроить alarm на срабатывание мониторинга.

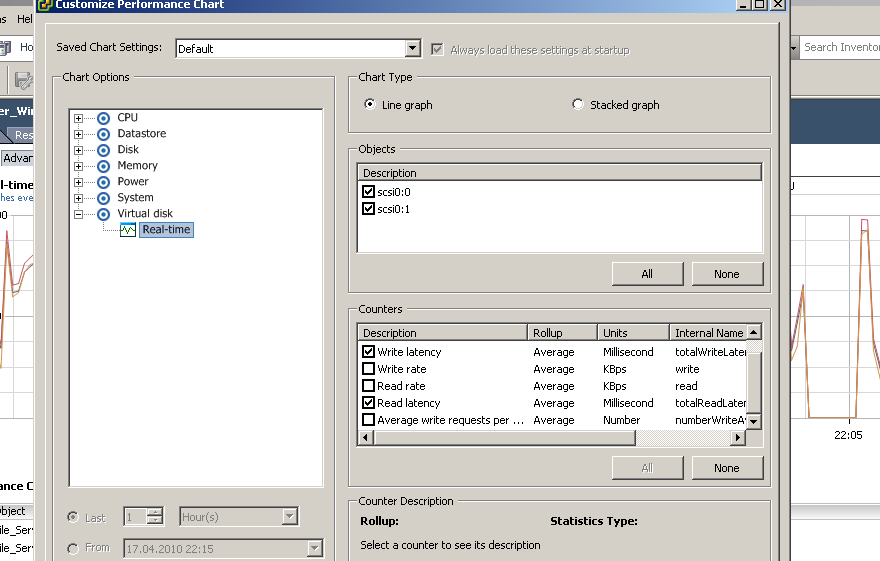

- в графическом интерфейсе мониторинга Performance добавилось информации по дискам — отдельным дискам ВМ и хранилищам хостов. Кроме того, доступна информация по нагрузке на пути к хранилищам.

- новые alarm, по latency, например

- заявлена поддержка Storage Offload, когда функции, связанные с копированием или переносом информации выполняются самой СХД. См. тут — VAAI — vStorage API for Array Integration.

Это операции:

Storage vMotion (раз в 5 быстрее)

развертывание ВМ из шаблонов (возможно ускорение до 10-20 раз)

клонирование ВМ.

работа с тонкими дисками.

уменьшение блокировок VMFS для многих операций.

Вкратце — версия VMFS слегка обновилась (в бете это VMFS 3.46). В этой новой версии добавились т.н. VAAI, the vStorage APIs for Array Integration — они как раз и нужны для оффлоада задач на СХД. К сожалению, апгрейд VMFS возможен только путем пересоздания.

Мне уже попадались упоминания о том, что поддержка данных API возможна, иногда, всего лишь обновлением прошивки системы хранения. Например, про EqualLogic - EqualLogic firmware with vStorage API.

В HCL должен появиться список стораджей, поддерживающих оффлоад.

Отзыв от использования:

Today I installed a new firmware from Equallogic supporting the hardware acceleration feature. It appears after I clone and created virtual machines and perhaps enabled storage I/O control. Cloning VMs works completely off the ESX — esxtop doesnt show any I/O values. Cool...

- iSCSI iBFT Boot Support — vSphere 4.1 allows ESXi to boot from iSCSI using iBFT. Broadcom 57711 is supported.

Тут я пока не просек – насколько это круто.

Отзыв

I will add some notes here as it might be useful to someone else who would like to set it up at a later date.

This is for ESXi only. Do no try to implement it with classic ESX.

The broadcom NIC must have the iSCSI Boot Option ROM Enabled in the BIOS. Make sure it is a relatively new iBFT ROM version. I was using version 3.0.6 which was quite old and caused me some issues. I eventually used a 4.x version of the iBFT ROM.

The broadcom NIC must be the first boot device is the BIOS.

Boot to iSCSI target must be disabled in the iSCSI Configuration parameters in the Broadcom MBA initially. It needs to be set to enabled for subsequent reboots.

On initial install during server boot before the server attempts to boot from the CDROM, ensure that your iSCSI initiator has successfully logged into the iSCSI target and discovers a LUN. Details about the initiator, target, login and lun disocvery should all be displayed on the server before installation starts.

The iSCSI LUN should appear in the ’Select a Disk’ screen in the installer. If it doesn’t, you’ve gone wrong, so revisit your setup

- iSCSI Hardware Offloads — vSphere 4.1 enables 10Gb iSCSI hardware offloads (Broadcom 57711) and 1Gb iSCSI hardware offloads (Broadcom 5709).

на русском - iSCSI Hardware Offloads в ESX/ESXi 4.1. - 8GB Fibre Channel Support — vSphere 4.1 supports 8GB Fibre Channel storage arrays. You can deploy ESX and ESXi with 8GB end-to-end Fibre Channel SANs.

Сеть

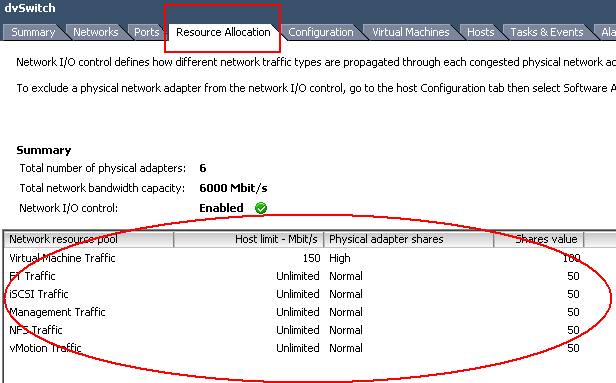

- при создании dvSwitch спрашивают его версию — 4.0.0 или 4.1.0. Первая нужна для совместимости с 4.0, последняя — поддерживает новые фичи. Это ограничение пропускной способности для трафика разных типов, балансировка нагрузки в зависимости от загрузки pNIC и VMDirectPath v.2

- Появилась возможность приоретизировать трафик по типу: управляющий, от ВМ, VMotion, Fault Tolerance, iSCSI, NFS

если задать limit = 0, то соответствующий трафик ходить не должен вообще.

Данная фича числится предназначенной для конфигурации, когда весь трафик ходит наружу через пару десятигигабитных канала.

Limit – ограничивает трафик какого-то типа для всех аплинков сразу.

Shares – здесь – гарантирует какой-то минимум, притом высчитывается для конкретного адплинка (vmnic#).

- Кстати, если стоит задача какой-то из pNIC вывести из под действия этого алгоритма, то можно сделать так: configuration —> advanced settings —> net —> в последней опции «Net.IOControlPnicOptOut» перечислить аплинки, для которых фильтровать трафик не надо.

- для распределенного коммутатора появилась балансировка нагрузки в зависимости от нагрузки на NIC

Начинает работать когда нагрузка на аплинк (Tx или Rx) достигает > 75% в течении 30 сек.

В первой реализации этот механизм не учитывает shares для сети, рассмотренные выше.

- Pv6 Enhancements — IPv6 in ESX supports Internet Protocol Security (IPsec) with manual keying.

Доступность

- VMware HA Healthcheck Status — HA обеспечивает контроль за тем, чтобы требуемая конфигурация кластера соблюдалась всегда. В случае отклонений от конфигурации создается событие в журналах vCenter. Также можно настроить alarm для оповещения о таком событии.

- VMware HA Operational Status — дополнительно окно, отображающее статус узлов кластера HA. Здесь отображаются сервера с проблемами — и кроме проблемы, для них указывается статус — Primary они для кластера, или Secondary.

- Готовятся HA API – ожидается появление сторонних приложений, так или иначе интегрирующихся с HA.

- появилась неподдерживаемая настройка:

das.preferredPrimaries = <имена или IP адреса хостов, которые должны стать Primary>. После указания настройки кластер следует выключить и включить.

Обратите внимание — указывать следует короткое имя, не FQDN. Длинна поля ограничена (на момент написания) 80 символами, так что если у вас длинные имена хостов — вам не повезло.

Кроме того, я узнал, что HA агент не поддерживает имена хостов длиннее 26 символов.

И надо бы уточнить, поддерживает ли IPv6.

- Fault Tolerance (FT) Enhancements — стал лучше. Но самая главная беда, однопроцессорность защищаемой ВМ – на месте.

Виртуальные машины, защищенные FT, полноценно участвую в жизни кластера DRS, в том числе со включенным EVC. DRS выбирает хост для включения Primary ВМ, и мигрирует и Primary и Secondary ВМ для балансировки нагрузки.

Пропала нужда в одинаковости билдов ESX(i) для работы FT.

Теперь можно задействовать FT не включая HA. - vStorage APIs for Data Protection (VADP) Enhancements — теперь для резервного копирования поддерживается дерганье VSS для Windows 2008 и Windows 2008 R2 .

- HA начала поддерживать виртуальные машины, защищенные Windows Failover Cluster.

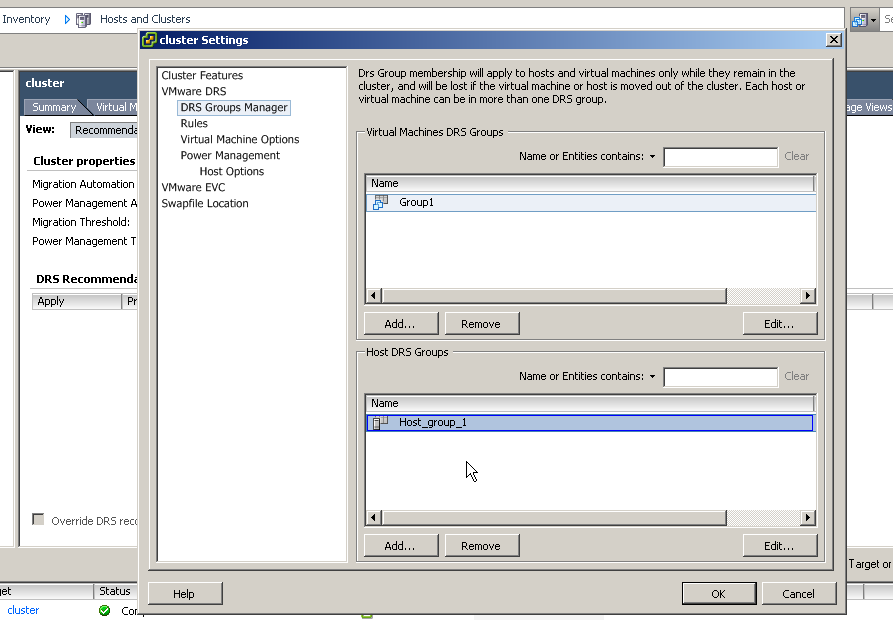

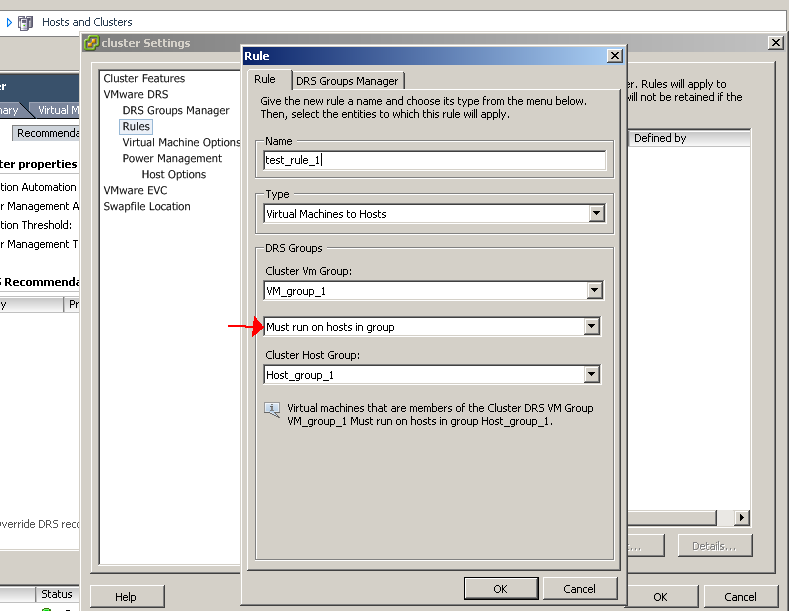

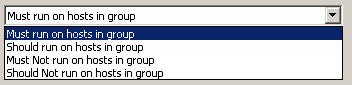

- DRS научился делить ВМ и сервера по группам:

и через правила указывать кто как должен относительно этих групп работать

Хотя вроде HA тоже должен придерживаться этих правил. Если правила нарушены вручную – генерится событие в журнал.

- vMotion Enhancements — VMotion стал работать быстрее. Как минимум за счет того, что увеличилось количество одновременно запускаемых миграций до 4(для гигабита) и 8 (для десятигигабита). Это важно для операций, требующих убрать все ВМ с сервера – установка обновлений, например.

- Improvements in Enhanced vMotion Compatibility — EVC начал поддерживать процессоры последних поколений. AMD Opteron Generation 3 работает в режиме EVC без технологии 3DNow!™, что позволяет создать кластер, который будет совместим с новыми версиями процессоров AMD. Также улучшения в EVC коснулись указания режима EVC, более детализированных ошибок и снижения требования к перезагрузке ВМ.

- DPM теперь можно включать выключать по расписанию, через встроенный планировщик vCenter. При выключении DPM все сервера просыпаются – можно нормально включать их ДО начала рабочего дня.

Управляемость

- vCenter Converter Hyper-V Import — Converter позволяет подключиться на хост Hyper-V. Конвертер покажет виртуальные машины, работающие на Hyper-V, можно будет выбрать выключенные ВМ для импорта в vSphere.

- Улучшения в Host Profiles — теперь этот механизм позволяет соблюдать требования по смене пароля администратора. Кроме того, что-то там сделали для Cisco Nexus 1000v и нумерации PCI-устройств.

- Аутентификация без запроса в vMA - vMA4.1 поддерживает интеграцию с Active Directory и команды для настройки авторизации.

- vCenter Orchestrator предлагает новые предустановленные процессы для автоматизации задач администрирования, такие как управление снимками состояния, забытыми VMDK-файлами (!), множественные операций конвертирования thick-дисков в thin и отключение съемных устройств через vCenter.

- Улучшено управление перевыпущенными обновлениями в Update Manager - теперь VUM отправляет оповещения о таких обновлениях, выводит список хостов, где они установлены и не дает установить старое обновление.

- Update Manager научился может обновлять драйвера, CIM провайдеры и другие модули.

- Для HA и DRS максимум ВМ стал одинаков – 320 ВМ на хост, 3000 на кластер, вне зависимости от числа серверов.

Конфигурация ВМ

- последовательный порт каким-то образом прокидывается через сеть.

This enables solutions such as third-party virtual serial port concentrators for virtual machine serial console management or monitoring.

на данный момент я не понял, к чему же через еть подключается виртуальный com порт.

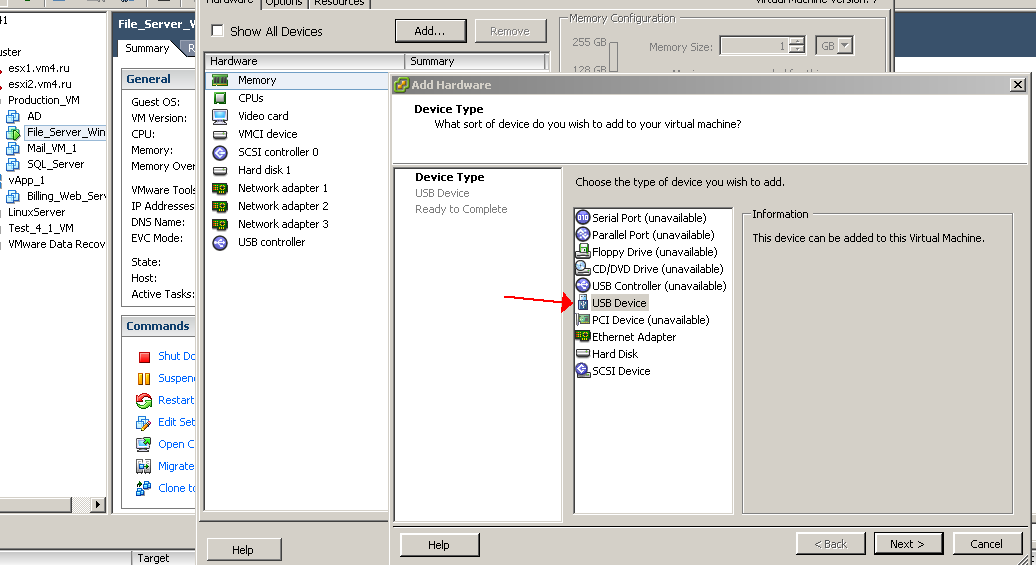

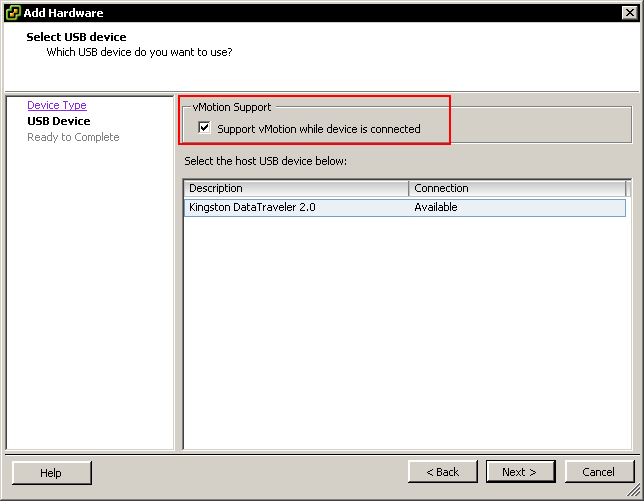

- Подключение к ВМ устройства USB, подключенного к хосту:

при миграции ВМ на другой сервер USB устройство ПРОДОЛЖАЕТ БЫТЬ доступным!!!

похоже, на хост до 15 ВМ с прокинутым USB (хотя я могу ошибиться, и тут имеется в виду до 15 USB контроллеров сервера).

Поддерживается и USB 2.0, и USB 1.1, притом и одновременно.

До 20 USB устройств на одну ВМ, и на один хост тоже не больше 20. (насколько я понимаю, проблемой могут быть устройства, который с. точки зрения USB содержат в себе сразу несколько устройств)

В списке поддерживаемых, кроме прочего, Aladdin HASP HL Drive, Aladdin Knowledge HASP HL 3.21, Aladdin HASP HL NetTime Software Protection Dongle и др.

Поддерживается автоподключение — если к ВМ было подключено USB устройство, то после его извлечения и нового втыкания в сервер оно само подключается к той же ВМ.

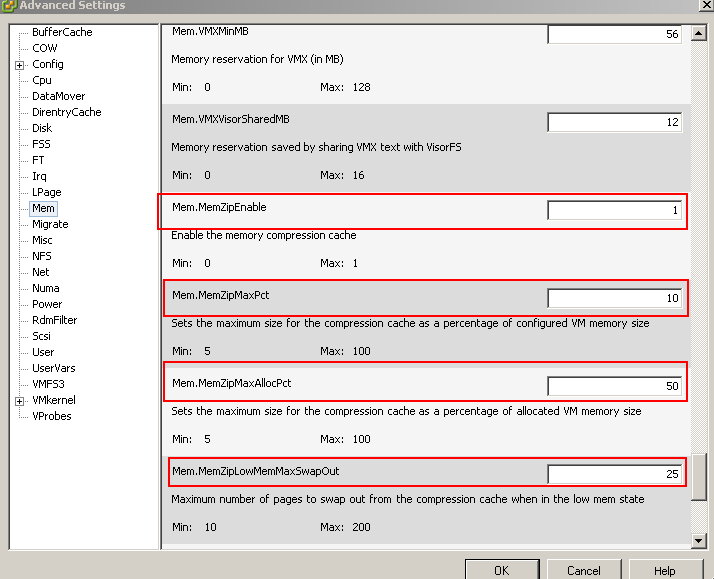

- Memory Compression — новый уровень абстракции оперативной памяти ВМ.

Перед использованием файла подкачки (пока не понял, имеется в виду только vmkernel swap, или balloon тоже) будет так: часть памяти ВМ резервируется под кэш, и в этом кэше располагается ее же память, но сжатая гипервизором. Настраивается эта технология только через Advanced Settings.

- Улучшилась виртуализация CPU - CPU scheduler improvements in 4.1.

a) there were a lot of general scalability & performance improvements — reducing lock contention, general overhead, etc.

b) We extended our optimizations for NUMA architectures to also optimize scenarios where thenumber of vcpus in a VM is larger than the number of cores in a single NUMA node on the host. In other words, for such VMs we are improving CPU fairness and memory locality.

Дистрибутивы доступны на странице скачивания:

http://downloads.vmware.com/d/info/datacenter_downloads/vmware_vsphere_4/4

Сравнение функционала в различных редакциях

Редакции Standard, Advanced, Enterprise и Enterprise Plus:

http://www.vmware.com/products/vsphere/buy/editions_comparison.html

Редакции Essentials, Essentials Plus, Advanced Acceleration Kit,

Midsize Acceleration Kit (w/Enterprise) и Enterprise Plus Acceleration Kit:

http://www.vmware.com/products/vsphere/buy/small_business_editions_comparison.html

Еще из полезных ссылок:

все то же самое, но официально и с отсылками на доку - What’s New in vSphere 4.1.

Гайд по обновлению.

Весь набор документации, как и раньше, тут - http://pubs.vmware.com.

Спасибо за подробный пост, Слюни уже текут :)

ОтветитьУдалить>>клиент vSphere теперь не входит в установленный ESX(i). Ссылка на web-странице установленного ESX(i) теперь ведет на сайт VMware

Блин, а это не так удобно, как раньше :(

пожалуйста.

ОтветитьУдалитьпо поводу удобства - в целом согласен, в некоторых ситуациях слегка менее удобно.

>>в некоторых ситуациях слегка менее удобно

ОтветитьУдалитьНе совсем слегка, допустим на вопрос: а где взять ViClient? уже не ответишь -скачай с https://hostname/viclient.exe

К тому же не всегда у хоста есть доступ к интернету.

Хотя количество новых плюсов перекрывает этот недостаток. Чего только проброс USB стоит.

*К тому же не всегда у хоста есть доступ к интернету.

ОтветитьУдалитьУ задающего вопрос имеется ввиду.

доступ в инет должен быть у той машины, которая зайдет на http://hostname/, и на этой страничке нажмет ссылку vmware.com/viclient.exe.

ОтветитьУдалитьmichigun комментирует...

ОтветитьУдалитьдоступ в инет должен быть у той машины, которая зайдет на http://hostname/, и на этой страничке нажмет ссылку vmware.com/viclient.exe.

Я исправился тут :)

>>email комментирует...

*К тому же не всегда у хоста есть доступ к интернету.

У задающего вопрос имеется ввиду.

%)

ОтветитьУдалитьну я думаю мы поняли друг друга

Миша, спасиб большой за твой труд по собирательству полезняшек в одном месте...

ОтветитьУдалитьпожалуйста, рад помочь.

ОтветитьУдалитьаж руки чешутся... так хочется сразу в продуктив ставить :(

ОтветитьУдалитьвчера, когда читал пдф-ку с презентацией, с каждой страницей так и представлял, как увеличивается отрыв esx-а от остальных :)

Если кратко - "королева в восхищении"(с).

ОтветитьУдалитьЕсли верить презенташке с нашего сайта, то Techmode на ESXi перестал быть Unsupported. :)

ОтветитьУдалитьТеперь его разрешается включать для запуска постинсталляционных скриптов.

Использование его для Cron, SSH и т.п. по-прежнему не поддерживается.

Хотите командную строчку - юзайте vMA.

>>при миграции ВМ на другой сервер USB устройство ПРОДОЛЖАЕТ БЫТЬ доступным!!!

ОтветитьУдалитьчто-то я не понял этого момента:

если я перенесу вм с сервера ALPHA на сервер BETA, она все-равно будет иметь доступ к USB девайсу, хоть он и подключен к серверу APLHA?

2mops

ОтветитьУдалитьда.

я сам три раза проверил, прежде чем убедился что все правда работает :)

2 michigun

ОтветитьУдалитьфантастика 8)

да нет, обычная магия

ОтветитьУдалить:-)

ОтветитьУдалитья так понимаю, что они просто интегрировали USB-over-IP прямо в ESX(i).

Пасиб за пост

ОтветитьУдалитьЯ вот только не могу найти в различиях между редакциями, возможность отдавать 8 vCPU на одну машину осталось только в ENT Plus или теперь во всех редакциях?

позже еще посмотрю, но по моему с этим изменений не произошло.

ОтветитьУдалитьЭтот комментарий был удален автором.

ОтветитьУдалитьМихаил, ESXi теперь поддерживает проброс COM-порта в виртуалку или нет?

ОтветитьУдалить2Анонимный

ОтветитьУдалитьсмотря какой проброс вы имеете в виду.

вариантов, в общем-то, два:

1) если использовать ESX, то как и раньше к ВМ можно мапить физические com порты. Что будет препятствовать миграции. Это не ваш вариант, раз спрашиваете про ESXi.

2) можно обзавестись сторонним com-hub, программным или аппаратным, который поддерживается vSphere.

для справки см, например,

http://www.ntpro.nl/blog/archives/1539-vSphere_4.1_-_Virtual_Serial_Port_Concentrator.html

Вторая картинка, на которой "Security prifile"

ОтветитьУдалитьЧто за сервисы:

I/O Redirector

ldtb

?

:)

а хз.

ОтветитьУдалитьСтоял ESX 4.0u1 был создан пользователь с shell access без административной роли. Под ним мог логиниться и по SSH и локально в сервисную консоль. Обновился до 4.1 пользователь остался, но пропал доступ к консоли, и пока не дашь административную роль не пускает. Что делать? Для этого пользователя права администратора не нужны.

ОтветитьУдалитьМихил... Огромное спасибо!!! Давно ваш читатель, но открыто благодарю впервые (пересекались на бороде до этого...)

ОтветитьУдалитьПросто как сам писал для себя!!!

Ой... напечатал и только сейчас увидел что имя не пропечатал ((( Ну так неловко!!!!

ОтветитьУдалитьМои извинения, МихАил ))))))))

> Анонимный комментирует...

ОтветитьУдалить> Стоял ESX 4.0u1 был создан пользователь с shell access без административной роли. Под ним мог логиниться и по SSH и локально в сервисную консоль. Обновился до 4.1 пользователь остался, но пропал доступ к консоли, и пока не дашь административную роль не пускает. Что делать? Для этого пользователя права администратора не нужны.

Это вы думаете, что не нужны. А вот VMware, например, думает наоборот — что очень даже нужны :)

«Это не баг, это фича» ©

Подробнее: http://communities.vmware.com/thread/275973

Enjoy your 4.1.

да, «Ссылки на это сообщение» доставляют :))

ОтветитьУдалитьв документации так и написано, что только с административной ролью. А мне нужно создать пользователя который не должен иметь прав админа, но должен попасть локально в консоль и иметь доступ к команде poweroff. Есть пути решения как дать этот доступ без адм. роли? Или альтернативные варианты. Заранее благодарен!

ОтветитьУдалитьДобавил пользователя в группу root'а, всЁ что нужно заработало. Спасибо!

ОтветитьУдалитьнаверно совсем не в тему если напишу сюда.

ОтветитьУдалитьПроблема при установке

esxi 4.1 выдает

install.vgz booting: mbi=0×000101f8 entry=0×00400256

сервер мать Intel S5500BC

проц 2 E5620

в чем заключается ошибка? В инете инфо не нашел. Думаю что в драйверах. Но чего сделать дальше не знаю.

Купил вашу книгу, но споткнулся о Linux

ОтветитьУдалитьПри установке

esxi 4.1 выдает

install.vgz booting: mbi=0×000101f8 entry=0×00400256

сервер мать Intel S5500BC

проц 2 E5620

в чем заключается ошибка?