Коллеги, в последнюю недельку в блог не писал.

Времени нету :(

Нету во многом потому, что кроме работы занимаюсь еще работой - делаю ревью русскоязычной версии курса VMware Infrustructure Install & Configure.

Это гуд.

Так же могу огласить еще пару новостей:

VMware Site Recovery Manager - ориентировочно в первой трети января я буду со страшной силой овладевать этим нереально крутым средством для построения катастрофоустойчивых решений. Думаю, ближе к новому году организовать сбор вопросов по нему. Соответственно, в следующем году можно будет сходить на курс по нему.

VMware VDI становится VMware View.

По VMware View будут два курса - однодневный для партнеров - может быть он будет доступен у нас уже в декабре, хотя начало следующего года более вероятно. На этом курсе теория и практика по VMware View для, повторюсь, партнеров.

В первом квартале у VMware появиться(а у нас станет доступен) трехдневный курс по VMware View, для тех кто прикупил это клевое решение не без помощи парнтеров VMware, которые его предложили используя знания с однодневного курса.

Как то так.

суббота, 29 ноября 2008 г.

Новости про курсы VMware в России

Начало переименования продуктов\фич VMware

Коллеги, углядел тут ссылку на документ: VMware Product Name Changes.

Скоро привычные нам вещи станут называться по другому. Например:

VirtualCenter Server -> VMware vCenter Server.

VMware Update Manager -> VMware vCenter Update Manager.

Даже самостоятельная версия VMware Converter будет называться VMware vCenter Converter Standalone.

Файловая система VMFS теперь - VMware vStorage VMFS.

Все, что связанно с VDI -> теперь связанно с VMware View.

К ознакомлению рекомендуется.

Кстати говоря, вот тут - Подборка страшных слов - можно углядеть логику этого переименования, и понять что еще появиться, из неуказанного в приведенном документе.

пятница, 28 ноября 2008 г.

из переписки

Пришло в аську:

Анюта (15:24:22 28/11/2008)

виртуальная машина - это круто

Анюта (15:24:38 28/11/2008)

мы взяли скопировали чужое и развернули )) и вот у нас есть свой стенд!!!

Анюта (15:24:46 28/11/2008)

ничего особенного не настраивали

Пикантность ситуации в том, что это мне написала моя супруга :)

Так что еще одна компания разработчик программного обеспечения начала осознавать плюсы виртуализации, и Virtual Appliance(мне, кстати, понравился вариант перевода "Виртуальное решение").

Ну и плюс из их жизни:

Под проект нужен сервер.

Покупать свой жаба душит.

Вроде бы дает партнер.

Дает то дает, но забывает дать рельсы. Админы отказываются разворачивать стоечный сервер не в стойке. Сервер неделю лежит в коридоре.

Привозят рельсы. Сервер ставится в стойку. Проект уже горит, админы не спеша(у них свои дела) разворачивают.

Ставят туда VMware Server и два дня трахаются с глюками из за драйверов к сетевушкам.

И вот, на исходе второй недели. сервер в строю.

Теперь, с моим мнением что можно было попробовать Хостинг ВМ, соглашаются. А время то ушло :(

понедельник, 24 ноября 2008 г.

Изменение имени DataStore

При восстановлении VMFS один из Datastore не захотел менять своё имя на правильное. При этом VC помнит что ВМ'ы находятся на недоступном (теперь) DataStore. Изменить имя не получается, оно "залочено" т.е. "используется".

Вариант только один. Разрегистрировать машины (удалить из инвентори), которые ссылаются на этот DataStore, т.е. их конфиги или диски находились на нем. Количество таких машин указано при просмотре DataStore на панели DataStores. Когда количество будет 0, DataStore исчезнет и можно сменить имя на правильное. После этого все машины в ручную нужно зарегистрировать через

vmware-cmd -s register name_machine.vmx

При этом слетают дополнительные диски машин. Но это уже другая история.

Переезд VI3. Опыт. Грабли.

Понадобилось мне переехать. Для этого была отключена вся инфраструктура VI3.

Какие были проблемы.

- Отсутствие бекапов. Да, не удивляйтесь, но их не было.Делайте ! Пусть даже и через Clone на горячей системе, если нет VCB. Такой Clone можно делать начиная с ESX 3.5 U2. Их отсутствие прибавило мне седых волос и убавило нервных клеток (хоть они и восстанавливаются).

- Не делайте suspend для ВМ. После запуска VI и ВМ, часть ВМ машин работала криво. Где отъехала сеть, где демоны, где пинг был огромным. Пришлось всё перезагружать. К тому же с suspend-машину нельзя отредактировать, что очень было надо. Лучше выключить все ВМ машины.

- Видимо отключение ESX хостов надо проводить через maintance mode. После включения VI, луны с VMFS оказались заблокированными. Как с этим бороться.

- DNS это маленькая подзадача. Выносится на отдельную маленькую ВМ. НО ! После включения VC, хосты ввести нельзя - DNS'а нет ! Выход - прописать имена в файл hosts на VC. Правильный выход - второй DNS не на ВМ.

- Не штатная проблема. После включения ESX хостов, у меня не оказалось DataStore's. LUN'ы видны, а DataStore нет. А точнее луны пустые.

Как это получилось я не знаю, и вряд ли когда-нибудь узнаю. Как лечить - рассказано здесь.

воскресенье, 23 ноября 2008 г.

it4business

Коллеги, в рамках взаимного обмена ссылками :) хочу рассказать вам об интересном проекте - it4business.ru.

Портал для IT-менеджеров: для тех кто руководит, принимает решения и отвечает за результат.

этот проект уже третья инкарнация идеи специализированного проекта для специалистов IT-отрасли. Вначале был проект для тестировщиков, потом он стал проектом про тестирование, а сейчас существует как проект для IT-менеджеров, чтобы со временем, возможно, развернуться до проекта про IT и программную инженерию и взаимоотношения с бизнесом.

Из интересного:

Рекомендуемые блоги ИТ специалистов, и подобные ресурсы.

вторник, 18 ноября 2008 г.

Linked Clones in ESX 3.5

Linked clones.

Эта технология уже поддерживается при использовании Lab Manager, и вроде как ее обещают в VI4.

Но можно попользоваться ее фичами и сейчас.

Напомню, что суть этой фичи - в экономии места на диске.

Возможна она, когда у нас есть много однотипных ВМ.

В этом случае удобно хранить одну копию базового образа - то, что едино для многих ВМ, и для каждой индивидуально разницу относительно этого образа.

Подробная инструкция тут - Linked Clones in ESX 3.5.

Это неподдерживаемое решение.

понедельник, 17 ноября 2008 г.

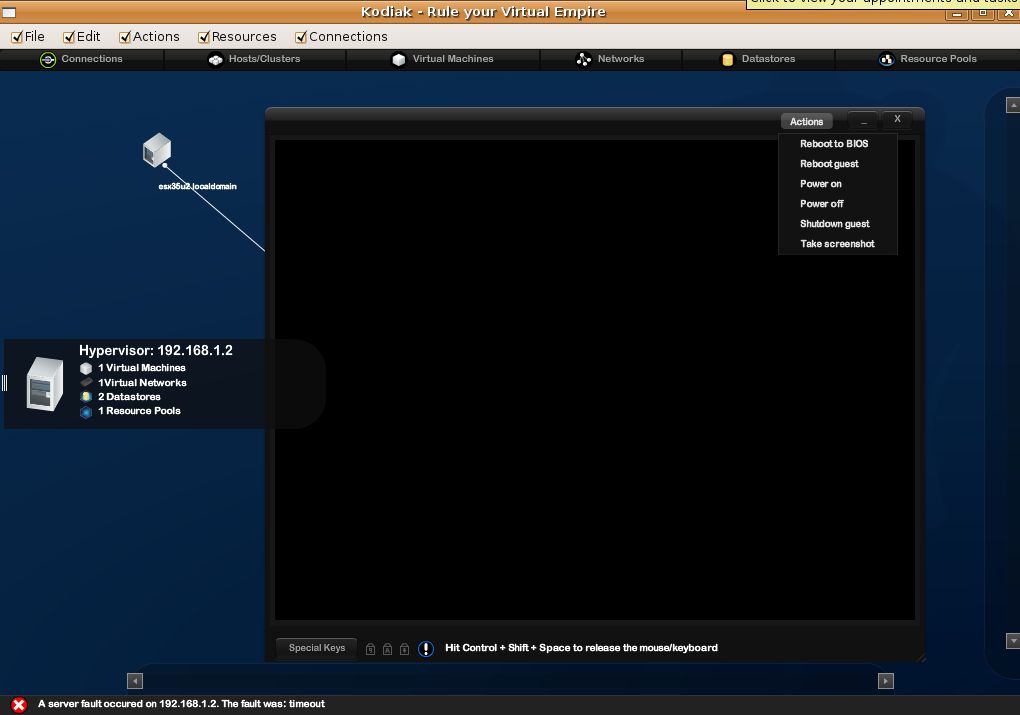

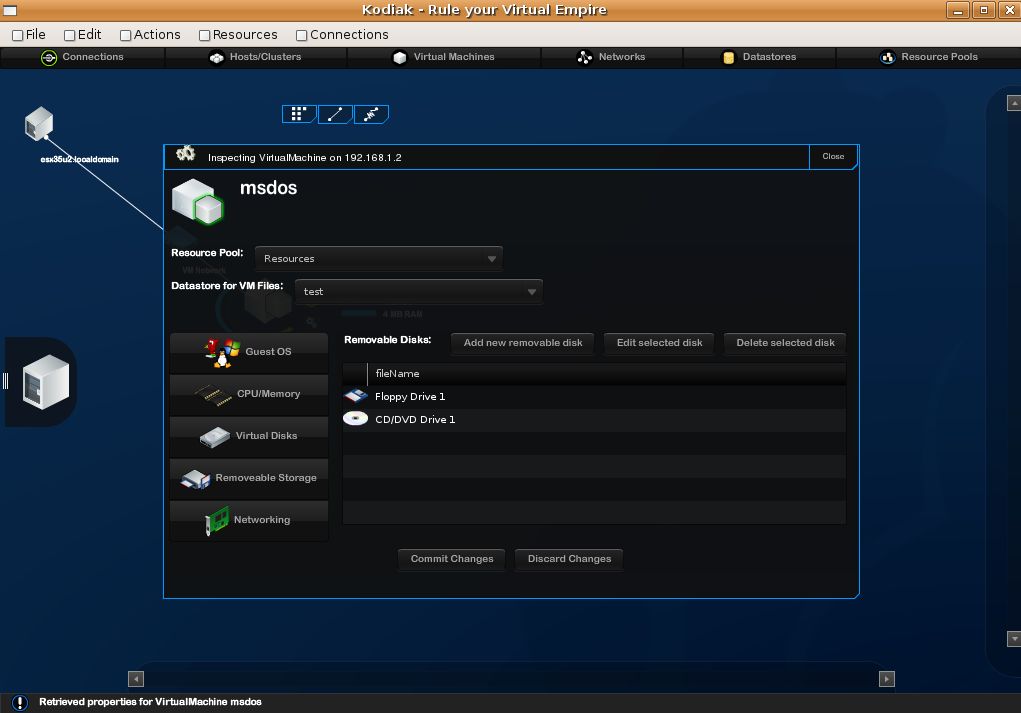

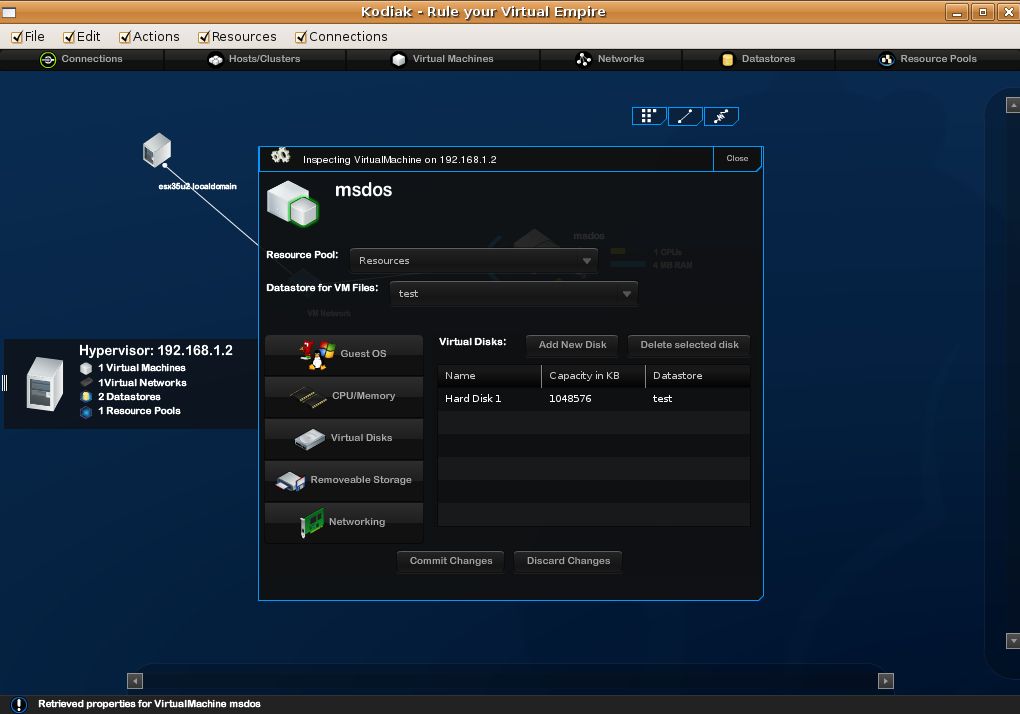

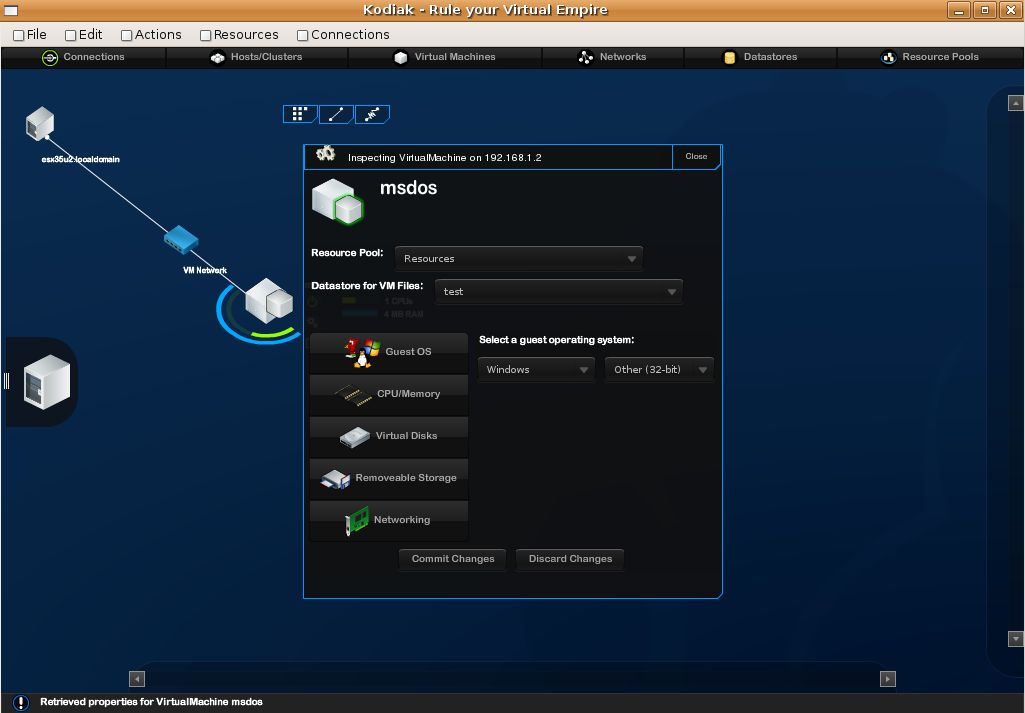

Kodiak

Как то я писал про кроссплатформеный клиент для управления всеми гипервизорами, а потом

Kodiak - кроссплатформеный клиент для управления всеми гипервизорами.

Чтож, проект развивается.

Клиент обрастает функциями.

Красивости же были у него изначально :)

Получил тут краткий отзыв от попробовавшего бету:

Установил, красотища неимоверная конечно :)

Можно визульно мышкой таскать ЕСХ хост и остальное хозяйство по экрану елозит за ним :)

Есть консоль ВМ, редакция свойств у ВМ, браузинг датастор

По функционалу ограничен: со снапшотами ВМ не работает и не дает новую ВМ сделать

Ну и тормозит само по себе временами :)

скриншоты отсюда - Part 2: Bluebear’s Kodiak, what’s all the fuss about….

Еще скрины и инфа на сайте Kodiak.

Видео:

Как подключить NTFS раздел к ESX

Андрей Вахитов радует второй инструкцией:

За основу взяты документы http://communities.vmware.com/thread/47225?tstart=0&start=0 и http://communities.vmware.com/thread/49040?tstart=0&start=15. Я их немного переработал, т.к. следование им не привело меня к требуемому результату.

Если есть необходимость в сервисной консоли ESX Sever 3,5 U2 подключить NTFS-раздел на чтение, то можно воспользоваться командой «mount –t ntfs /dev/sda1 /mnt/ntfs1», где «/dev/sda» – какое-то физическое устройство, на котором мы подключаем партицию №1, а «/mnt/ntfs1» соответственно точка монтирования (аналог логической буквы e:\ в Windows). Список физических устройств нам даст

«esxcfg-vmhbadevs»;

список разделов на дисках «fdisk –l».

Однако при запуске команды «mount» мы получим ошибку – «данная файловая система не поддерживается ядром». Как подружить ядро с NTFS?

0) Т.к. я не очень разбираюсь в линуксе, то по этой инструкции подключать модуль NTFS придется каждый раз после перезагрузки сервера с помощью «modprobe ntfs».

1) В каталоге /lib/modules находим каталог вида «2.4.21-37.0.2.ELvmnix». У меня это «2.4.21-57.ELvmnix». Выполняем резервное копирование

«cp 2.4.21-57.ELvmnix 2.4.21-57.ELvmnix.old».

2) «cd /usr/src/linux-2.4/configs».

3) «nano vmnix.config», ищем строку «CONFIG_NTFS_FS» и изменяем ее на «CONFIG_NTFS_FS=m».

4) «cp vmnix.config kernel-2.4.21-i686-vmnix.config».

5) «cd ..».

6) «nano Makefile». Ищем строку, начинающуюся на «EXTRAVERSION» и меняем ее конец на ELvmnix. (nano Makefile, change the end of the EXTRAVERSION line from ELcustom to ELvmnix).

7) «make oldconfig && make dep».

8) «nano .config». Вносим изменения аналогично пункту №3.

9) «make modules».

10) Если все проделано верно, то в каталоге ./fs/ntfs/ должен появиться драйвер для NTFS – «ntfs.o». Копируем его «cp ./fs/ntfs/ntfs.o /lib/modules/2.4.21-57.ELvmnix/kernel/fs/ntfs/». Если каталога NTFS не существует, сначала необходимо его создать.

11) Теперь можем вручную загрузить драйвер NTFS (пункт№0) и вуаля.

P.S. Нюанс – подключить таким образом можно раздел размером менее 2х терабайт.

воскресенье, 16 ноября 2008 г.

Материалы и отчет по встрече от 31 октября 2008

Что же было 31 октября сего года:

TCO.

Сначала был разговор про подсчет стоимости владения. В качестве основы использовался инструмент для подсчета TCO в виде xls документа. Кстати, он на русском языке, поэтому к ознакомлению рекомендуется.

Основная графа расходов - это СХД, по этому пункту возражений не было. Если она уже есть, то стоимость миграции на виртуальную инфраструктуру меркнет перед выгодами от нее. Если ее нет, то цифирки выгоды чуть менее шоколадны. См. еще тут - Хостинг ВМ.

Важный момент - все это здорово для крупных предприятий, где счет серверов до виртуализации идет на сотни, может быть на десятки. Для компаний поменьше и совсем поменьше стоимость СХД, похоже, перебьет любые выгоды. По крайней мере у меня такое впечатление создалось. Хотя, "СХД" понятие растяжимое. Например, тут мне вспомнился пост “Недоступный NetApp”: мифы и разоблачения. В нев автор утверждает, что коробочное решение от NetApp, поддерживающее iSCSI и NFS с 6 ТБ RAW емкости и 2 годами сервиса обойдется ~ 250 000 руб. Вроде бы, не так много.

На встрече в этом месте разгорелась любопытная дискуссия - "middle range storage". Представители двух банков рассуждали, хороши они или не очень под виртуализацию, пока ими практически одновременно не были произнесены фразы:

"Ну от мидл ренжа больших иопсов не добиться!"

"Ну в мидлж ренже очень неплохие иопсы обойдуться достаточно дешево!"

Когда зал просмеялся, дискуссия как то увяла, а жаль. Вопрос СХД применительно к ESX - один из популярных и сложных практически всегда.

Так же, когда поднялся вопрос про SMB, один из присутствующих признался, что лично он собрал и продал очень дешевое решение - что то вроде пары серверов под ESXi, а в качестве СХД чуть ли не бытовой NFS сторадж с парой SATA дисков. Всех всех очень заинтересовали подробности. И они лично мне были обещаны по мылу - напоминаю об этом публично - к сожалению, я потерял емейл обещавшего :((

Вопрос лицензий тоже достаточно интересен.

Для компаний покрупнее, стоимость лицензий VMware погоды не делает. Ни по деньгам, ни по сложности процесса лицензирования. Чего не скажешь про Майкрософт - опять какое то время было потрачено на вопросы лицензирования ОС и продуктов MS под виртуализацию.

Автоматизация и управление в виртуальной инфраструктуре.

Lab, Stage, Lifecycle и Site recovery Manager'ы.

Доклад представителей VMware. Русскоязычная презентация доступна тут - Презентация M&A. "M&A" означает Management and Automation. Что мне запомнилось из нее:

Lab Manager - продукт для компаний с разработчиками. Предлагает для них:

Быстрое развертывание многомашинных конфигураций.

Библиотеку часто используемых конфигураций.

Портал для пользователей, где они самостоятельно смогут работать с созданием\удалением конфигураций, не дергая IT отдел.

Stage Manager - автоматизация манипуляций с виртуальной инфраструктурой, в первую очередь с ВМ.

Lifecycle Manager - продукт для автоматизации развертывания, в первую очередь. На базе VMware Orchestrator. Пользователь запросил -> админ утвердил -> пользователь получил(в смысле, запрошенную\ые ВМ) -> по истечении срока архивация\удаление ВМ.

Притом, продукт VMware Orchestrator - это офигенно мощная платформа, с помощью которой можно автоматизировать что угодно. Можно прикупить стандартный Lifecycle Manager - тогда он автоматизирует только то, что подготовила VMware - то, что я только что описал. А можно прикупить разблокирование всех возможностей Orchestrator - с его помощью можно автоматизировать хоть захват власти над этой планетой. Были бы разбирающиеся в нем кадры.

Site Recovery Manager(SRM) - решение для упрощения восстановления после катастроф.

Тезисы:

Нужны - резервный ЦОД, репликация СХД. SRM позволяет создать план восстановления, и безопасно оттестировать его. Красноречивый скриншот:

Из минусов для себя отметил необратимость процедуры восстановления, в том смысле что если мы переехали на резервную локацию, то обратно SRM наши ВМ не перетащит сам. Процесс возвращения на основной ЦОД надо будет оформить как восстановление после сбоя резервного ЦОДа.

Был, кстати, вопрос по поводу лицензирования VI на резервном ЦОДе для SRM. Ответить сразу затруднились, сослались на FAQ по SRM. Что то я не нашел этот FAQ %), буду искать.

Далее.

Далее очень здорово выступил Антон Жбанков.

Для начала он рассказал про VDI. Составить впечатление можно по посту на его блоге - VDI - краткое введение и Ограничения лицензии VDI.

Кстати, вопросы лицензирования десктопных ОС под виртуализацию на русском описаны тут и тут.

После этого, рассказал про свой теоретический и практический опыт с разными гипервизорами. К сожалению, в текстовом виде есть разве что его пост Виртуальность от Sun. Надеюсь, он еще осветит этот вопрос.

Была демонстрация беты VI4. За стенд и саму демонстрацию отвечал я. Положа руку на сердце, надо признать, что демо получилось весьма скомканным :(

Т.к. я участвую в бете 4ой версии VI4, я подписывал настолько суровое соглашение о неразглашении, что как только я подумаю, чтобы что то про нее рассказать, как за левым плечом начинает материализовываться фигура безопасника vmware...

так что сошлюсь на данные из общедоступных источников - слухи о VI4, VMware VI и Linux, Некоторые новости VMware.

Коллеги, пока это все, что мне вспомнилось на данный момент.

За любые дополнения и отзывы, которые помогут нам лучше организовывать и проводить подобные мероприятия, буду благодарен.

Хвалительные жду тут в комментариях, ругательные мне на мыло ;)

гайд по командной строке

Коллеги, напомню:

по работе с командной строкой ESX есть очень, имхо, полезный документик - ESX 3.x Service Console Guide.

суббота, 15 ноября 2008 г.

Сторонний бекап для VI3 Trilead VM Explorer

Доступна утилита Trilead VM Explorer 1.5 - решение для резервного копирования и восстановления ВМ. Так же возможно копирование файлов между ESX хостами (ESXi так же поддерживается).

Плюс SSH клиент и snapshot manager.

http://www.virtualization.info/2008/11/release-trilead-vm-explorer-15.html

Из аналогичных(в теории) решений на слуху Vizioncore и Veeam.

пятница, 14 ноября 2008 г.

MOA - cold clone boot CD

Подсказали мне тут про один интересный проект - MOA.

Multi

Operating system

Administration / Addicts.

Это live-cd с офигенными возможностями.

Всех его фич я не распробовал, но например:

он может служить диском для Cold p2v migration. Такого диска нет в штатной поставке бесплатного свободногодоступного VMware Converter Starter.

Кстати, на указанной страничке есть несколько весьма внятных видеороликов с примерами использования - рекомендуются к ознакомлению.

четверг, 13 ноября 2008 г.

приложение для мониторинга VI.

Есть приложение Zenoss для мониторинга инфраструктуры.

В версии Enterprise есть мониторинг VI3

В частности:

* Automatic discovery and inventory of all Virtual Infrastructure (VI3) components including Virtual Machines, ESX Servers, clusters, and VMware data stores

* Physical and Virtual resource usage and performance (memory, disk, CPU, and more)

* Real-time detection when Virtual Machines move from one VMware host to another (called VMotion)

* Physical and Virtual performance and availability information correlated and displayed in a single, central web console

* Integration with VMware Virtual Center

Источник:

http://www.zenoss.com/product/enterprise#vmware-management

thx Александр Кузнецов.

среда, 12 ноября 2008 г.

Глубина очереди

Queuedepth, ее влияние на производительность и как поменять.

Суть:

Сервер посылает на СХД команды. Когда все хорошо, команда пришла - и исполнилась, СХД что то прочитала\записала. Если в какие то пиковые моменты СХД перестает справляться с запросами, то они становятся в очередь.

Небольшой нюанс виртуализации: По пути от приложения, которое запросы посылает, до дисков, которые их обрабатывают, разных очередей много. Это очередь в гостевой ОС, в гипервизоре, на hba, на СХД...

По пути от приложения, которое запросы посылает, до дисков, которые их обрабатывают, разных очередей много. Это очередь в гостевой ОС, в гипервизоре, на hba, на СХД...

Поэтому, в частности, вопрос производительности дисковой подсистемы и тонкого тюнинга так не прост.

Так вот, конкретные примеры, как определить узкое место, если оно в очереди команд гипервизора к ЛУНу:

запустить esxtop в Service Console(или resxtop в RCLI для ESXi ). Нажать "d".

Углядеть примерно такую картинку: Это данные по загрузке HBA. Объяснение того, что там видно.

Это данные по загрузке HBA. Объяснение того, что там видно.

Значение в столбце QUED слишком близко к значению ACTV - т.е. очередь команд полна. Гипервизор простаивает при обращении к диску, ожидая обработки стоящих в очереди команд.

Далее: посмотрим данные по ВМ, которые лежат на этом ЛУНе. Я пока не понял, как понять какие именно ЛУНы нам нужны. Все, которые доступны через этот HBA?

Запустили esxtop, нашли нужную ВМ, запомнили ее GID.

Нажали "e", вбили GID.

Увидели картинку:

Величина LOAD должна быть менее 1. Не нулевое значение QUED практически всегда означает затык, что СХД не справляется.

В такой ситуации может помочь увеличение глубины очереди со значения по умолчанию - 32, до 64.

vmkload_mod -l | grep qla

esxcfg-module -s ql2xmaxqdepth=64 qla2300_707

esxcfg-boot –b

Перезагрузим сервер.

Наша цель - чтобы картинка загрузки дисков стала походить на эту:

Источник - A look at the ESX I/O stack.

Кстати, интересный англоязычный блог по СХД, рекомендую - Storage Nuts & Bolts.

Поиск владельца RDM.

Иногда бывает нужно определить, к какой машине подключен тот или иной ЛУН как RDM.

Сделать это поможет скрипт для Serice Console(работает и для ESXi) - ESX/ESXi Virtual Machine RDM Discovery Tool;

или PowerShell вариант.

понедельник, 10 ноября 2008 г.

Офигенный двухминутный видеоролик про DPM

Офигенный двухминутный видеоролик про DPM, Distributed Power Management.

воскресенье, 9 ноября 2008 г.

траблшутинг

Интересный пост - Common system management issues in VMware Infrastructure.

Камрад VMwarewolf рассказывает о том, что сейчас он работает в VMware по направлению доступности знаний, и дает скачать интересную штуку - sysmgmt.zip.

Это - что то вроде "траблшутинг для чайников". Каждая строка - проблема. В первом столбце - ее описание. В последующих - последовательность шагов для ее диагностики и решения, со ссылками на KB.

суббота, 8 ноября 2008 г.

Инструкция по установке «unsupported devices» в ESX 3.5

Коллеги, на днях случилась у меня радость:

приходит письмо

Приветствую. Возникла необходимость использования ESX с HBA, которая не сертифицировалась и не определилась после установки ESX. Через поиск найти подобную инструкцию не смог, поэтому было бы неплохо ее опубликовать…

И приложена инструкция, как заставить ESX признать железку, драйвер под которую есть, но ESX в этом не признается - Инструкция по установке «unsupported devices» в ESX 3.5.

А радуюсь я тому, что очень приятно увидеть единомышленников - в моем случае людей, которым интересно поделиться своими знаниями с коллегами.

Большое человеческое спасибо Андрею Вахитову.

UPD.

убрал саму инструкцию с неотобразившимися картинками, дал ссылку на файл.

vmgu.ru

За последнее время на сайте vmgu.ru появилось много интересного:

Citrix XenServer 5. Уже здесь. Новые возможности.

сайт www.xenserver5.com

и видеоролик

Архитектурное сравнение VMware ESX/ESXi с Microsoft Hyper-V.

Тема сравнений не раз поднималась, и ни разу - успешно. Определенные нюансы я заметил и тут:

- сравниваются ESX\ESXi с MS Hyper-V. Но без учета Hyper-V Server, который соотносится с Hyper-V примерно так же, как ESXi с ESX.

- Для ESX\ESXi указываются необходимое дисковое пространство и отсутствие Service Console верные только для ESXi, не ESX.

- То, что ESXi занимает 32 мегабайта - это конечно хорошо. Но это все таки более маркетинговый факт, ибо на диске\флешке он требует хотя бы гигабайт.

- По поводу поддержки ОС Microsoft - указанно, что VMware поддерживает 10 версий Windows в ВМ на ESX, в то время как MS - только 9 в ВМ на Hyper-V. Но эта поддержка - две большие разницы, имхо.

Правильная тема поднята - Выключение VMware ESX или ESXi при отключении питания и переходе на UPS APC. Предлагается ставить агент APC в ВМ, а не в сам ESX. Напомню, что с недавнего времени под подобные задачи имеет смысл брать\создавать не какую то ВМ, а специально созданную VMware именно под задачи обслуживания\управления\мониторинга ESX - VIMA.

Какие порты используются VMware в Virtual Infrastructure для ESX Server, VirtualCenter, VI Client и хранилищ.

Размышления о запланированных и незапланированных простоях в рамках VMware Virtual Infrastructure и ESX Server. Часть 1.

По сути - что VMware может предложить заказчика для уменьшения запланированных простоев. Список велик.

Update 3 для ESX 3.5

Состоялся релиз Update 3 для ESX 3.5.

Подробности можно посмотреть тут - VMware ESX Server 3.5 Update 3 Release Notes.

Что привлекло мое внимание - VMDK Recovery Tool!

Пока экспериментальная, но утилита(скрипт) с говорящим названием vmfs-undelete, задачей которого является восстановление vmdk файлов(файлов дисков ВМ) в случае их удаления или повреждения VMFS раздела!!!

ИМХО, такой штуки не хватало очень и очень давно.

четверг, 6 ноября 2008 г.

VIMA

Очень и очень прикольная штука, которая была упомянута на встрече 31 октября, но тема не была до конца раскрыта в силу новизны.

Расскажу о ней и я:

VIMA - VMware Infrastructure Management Assistant.

Это потенциально отличная штука. Virtual Appliance, т.е. готовая к работе ВМ.

64 битный Linux, в нем

# VMware Tools

# VI Perl Toolkit

# RCLI

# Basic SNMP

# Centralized ESX Server Logging

Т.е. эта ВМ заточена быть средством мониторинга и даже управления серверами ESX\ESXi.

Ранее нам уже был доступен RCLI в виде Virtual Appliance для ESXi, но VIMA отличается тем, что в нее можно поставить агента мониторинга железа(!) и изнутри ВМ мониторить железо ESX хоста(!!). Это очень здорово, ведь именно отсутствие возможности поставить агента мониторинга внутрь ESXi называют главным его минусом. А тут и мониторинг, и запуск скриптов, и установка третьесторонних приложений и утилит, и централизованное логирование - красота!

Пока лично для меня остаются открытыми некоторые вопросы касательно VIMA - например, достаточно ли одной копии для мониторинга нескольких хостов, и некоторых других.

Буду разбираться, по результатам отпишу.

Azure гипервизор

Есть интересное мнение - Windows Azure uses a hypervisor but it’s not Hyper-V - что в MS Azure в качестве гипервизора будет использовать не Hyper-V!

Что ж, есть вероятность что MS сделает ход конем.

S' Tech Blog

В нашем полку прибыло - представляю S' Tech Blog.

Виртуализация, VMware, технически интересные записи.

Мне понравилось.

Добавил на мою страничку с подборкой ссылок - Источники информации, и в поиск.

среда, 5 ноября 2008 г.

Хостинг ВМ

SaaS, Cloud Computing, VMware VDC OS, MS Azure..

Сдается мне, углядел я отечественный проект (первый?) на эту тему - VMware Virtual Machines.

Хостинг ВМ в их ЦОДе. Сейчас ЦОД в Москве, вскоре обещают еще парочку, в Европе в том числе.

ВМ можно загрузить свою, можно развернуть из их шаблона.

В данный момент в качестве ОС доступны 6 вариантов Linux. Вскоре обещают еще и разные варианты Winodows, плюс лицензии на ПО - "Office (various versions), Project, SQL Server 2005 (Std & Ent), Exchange Server 2003 or 2007 (Std & Ent), ISA Server & CRM Professional".

На главной странице вынесены примеры конфигураций:

ВМ с

# 9Gb HDD

# 128Mb RAM

# 500Mhz CPU

обойдется в 549 рублей в месяц.

Конфигурация:

# 73Gb Disk space

# 1024Mb RAM

# 1066Mhz CPU

обойдется в 7 849 рублей в месяц.

Так же можно закупить не ВМ, а пул ресурсов, в котором ВМ уже насоздавать сколько надо\влезет :).

Что приятно, любая конфигурация включает все фичи VMware VI 3.5 - это и VMotion, и Storage VMotion, и VMware HA, и пр.

Т.е. идея зарабатывания денег следующая:

Для маленькой компании вопрос закупить сервер не простой. Железка, ее надо настроить, ее надо обслуживать, ее надо поднимать ежели что и пр. С учетом текучки кадров среди дешевых админов и, думаю это важно, надвигающегося\надвинувшегося кризиса это проблема.

А вот прикупить не сами железки, а фактически ресурсы под и только под конкретные приложения, и еще и бекап, независимость от упавшей железки, наличие резервного сервера на котором можно поднять ту же ВМ и пр. и пр. - имхо весьма может быть интересной.

Притом на этом идеи не кончились, и сейчас думается над планом хостинга и десктопов. Неужели я узнаю о первом в России внедрении VDI? :)

Берутся сервера, каждому заказчику выделяется по VDM(коннекшн брокеру), и создается нужное кол-во ВМ с десктопной ОС(наверное, Win XP). Доступ к ним по RDP из офиса заказчика. Видимо, и доступ к кужному кол-ву ВМ\копий ОС\необходимому десктопному софту(MS Office как наиярчайший пример) будет осуществляться в рамках абонентской платы.

Само собой, мне было интересно задать вопросы скорее про техническую составляющую.

Какое железо?

Сервера на платформе SuperMicro, Xeon 5400, 32 ГБ памяти.Как выбирали гипервизор?

FC СХД, по 12 SAS дисков на полку в RAID 50.

Бекап делается на SATA диски.

Чтением разного рода источников(в основном, конечно, англоязычных), и имея опыт пилотных проектов у заказчиков.

Интересовали накладные расходы, надежность самой ОС, производительность и масштабируемость(особо была упомянута ОЗУ).

Так же важно было, что вендор обещает в будущем.

Таким образом, Microsoft показал себя отстающим по фичам на сегодня, и не спеша догоняющим на завтра.

Xen - цитирую:

По поводу Xen vs VMware (не вдаваясь в маркетологические споры о производительности, хотя нам и показалось, что VMware получше будет):

Первое - безопасность. У VMware c этим обстоит гораздо лучше, а при использовании в одном окружении машин нескольких заказчиков этот параметр крайне важен, плюс у VMware гибче с настройкой прав доступа, по крайне мере нам так показалось.

Второе - инструментарий управления - VMware VC в этом отношении смотрится сильно привлекательнее любых решений, которые мы видели/успели посмотреть - все удобно, все в одном месте - значит проще управлять, значит выше надежность и сервис. Когда рассматривали Xen и VMware, то думалось - "а как мы будем управлять этим (Xen), когда серверов/кластеров станет действительно много?"

Третье - поддерживаемые OS, и уровень их поддержки/совместимости -

опять же, VMware впереди.

Четвертое - поддержка DRS, на момент когда мы плотно сравнивали эти решения, у Xen такой поддержки не было.

Пятое - уровень документированности, у VMware он гораздо выше.

Т.о. по сумме ощущений - да, Xen хорош, лучше чем Hyper-V, но для того, чтобы предоставлять в аренду инфраструктуру production-уровня он не дотягивает, по нашему мнению.

Да, VMware в чем-то проигрывает Xen, но в 2009 появится все то новое в VMware, что кажется уже - "чего еще желать?" =)

Интересно, что при расчетах оказалось неважной стоимость самого гипервизора. У VMware дорогие лицензии, но с учетом всего прочего эти деньги незаметны.

Я рад был это услышать от людей, которые сами считали и думали, а не от маркетологов и иже с ними. Тем более это оказалось подтверждением слов VMware о расчетах TCO, которые говорились на встрече 31 октября. Впрочем, об этом я еще напишу.

Кстати, когда я этот вопрос уточнял, в ответ получил:

По поводу расчетов стоимости, если интересно, большую часть затрат составляют не сервера, и не лицензии, а стоимость их обслуживания и управления инфраструктурой, в чем мы еще раз убедились, составляя бизнес план.

Лично меня очень очень порадовали прямые ответы на мои вопросы.

Персональное спасибо Павлу Петлинскому.

пост по результатам пятничной встречи готовится

Коллеги,

послепраздников наступило.

Сегодня завтра планирую закончить пост по результатам пятничной встречи, ответы на вопросы с нее оставшиеся, и "раздаточные" материалы.

Те, кто писал мне по электронной почте - так же сегодня начну работать над ответами.